近日,Meta AI 推出了名为 MobileLLM-R1 的轻量级边缘推理模型系列,现已在 Hugging Face 平台上线。该系列涵盖从140M到950M参数规模的多种模型,专为高效执行数学、编程及科学推理任务而设计,在低于10亿参数的体量下展现出卓越性能。

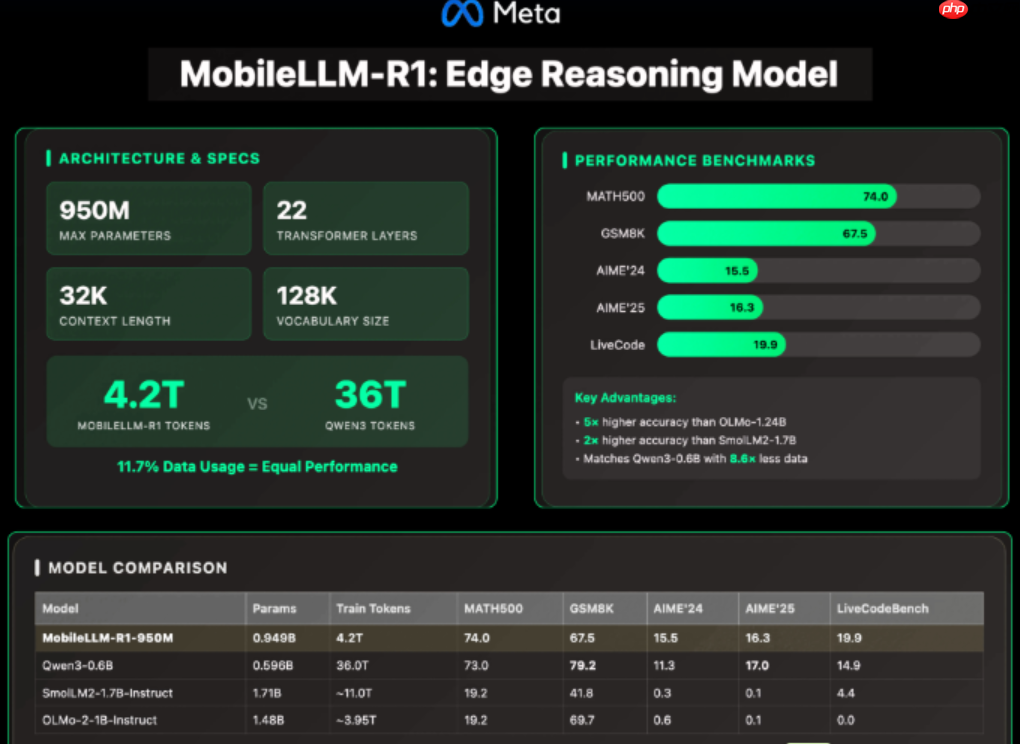

其中最大的型号为 MobileLLM-R1-950M,采用了多项架构优化:包含22层 Transformer 结构、24个注意力头以及6组分组 KV 头。其嵌入维度设为1536,隐藏层维度达到6144。

为提升效率,该模型引入了分组查询注意力(GQA)机制,有效降低计算与内存消耗;通过块级权重共享策略进一步压缩参数数量,同时避免显著增加延迟;并采用 SwiGLU 激活函数以增强小模型的表达能力。支持最长4K token 的上下文输入,后训练版本更可扩展至32K上下文长度。

在训练方面,MobileLLM-R1 展现出极高的数据利用效率。整个训练过程使用约4.2万亿 token,仅为 Qwen3-0.6B 所用36万亿 token 的11.7%,却实现了相当甚至更优的准确率表现。此外,模型经过数学、编码和推理相关数据集的监督微调,显著减少了训练所需的资源与成本。

基准测试结果显示,MobileLLM-R1-950M 在多个关键任务中表现突出:在 MATH500 数据集上,其准确率约为 OLMo-1.24B 的5倍,是 SmolLM2-1.7B 的约2倍。在 GSM8K、AIME 和 LiveCodeBench 等复杂推理与编程任务中,其性能与 Qwen3-0.6B 相当或更优,而后者所依赖的训练 token 数量远超前者。

然而,该模型的应用也存在一定局限。由于专注特定领域,其在通用对话、常识理解及创造性生成等任务上的表现不及更大规模的通用模型。此外,MobileLLM-R1 采用 FAIR NC(非商业用途)许可证,限制了其在商业场景中的部署;且较长的上下文支持(32K)会带来更高的 KV 缓存占用和运行时内存需求。