可通过集成第三方语音识别与合成工具实现豆包AI的语音助手功能。首先,使用科大讯飞或Azure等ASR服务将用户语音转为文本;接着,调用豆包AI的API获取文本回复;然后,利用阿里云或Google TTS将回复文本转为语音输出;最后,通过Python或Node.js搭建控制逻辑,协调录音、识别、对话与播放流程,并加入异常处理与静音检测机制以提升体验。整个过程需注意网络延迟与API调用配额限制。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

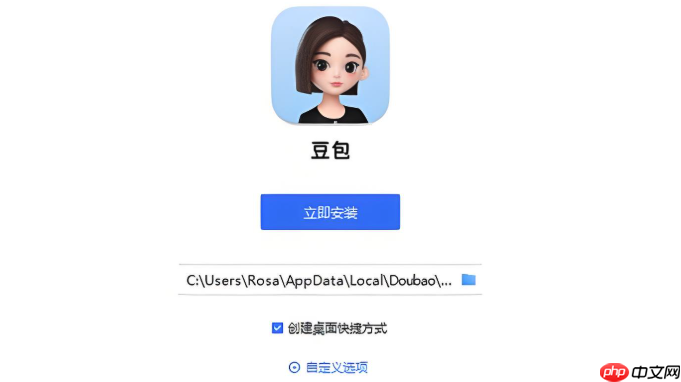

如果您希望使用豆包AI实现语音助手功能,但发现其原生应用未直接提供语音输入输出选项,则可以通过集成第三方语音识别与合成工具来实现。以下是具体操作步骤:

本文运行环境:iPhone 15 Pro,iOS 18

该步骤的目的是将用户的语音输入转换为文本,以便发送给豆包AI进行处理。需要选择一个稳定且支持高准确率语音转文字的API。

1、注册并获取一个语音识别平台的API密钥,例如科大讯飞、百度语音或Azure Speech服务。

立即进入“豆包AI人工智官网入口”;

立即学习“豆包AI人工智能在线问答入口”;

2、在应用中调用该平台的SDK,开启麦克风权限并开始录音。

3、将录制的音频文件上传至ASR接口,等待返回识别后的文本内容。

4、确保识别结果正确无误后,将此文本作为输入传递给豆包AI的对话接口。

注意:网络延迟会影响整体响应速度,建议在弱网环境下启用语音分段传输机制以提升稳定性。

此环节负责接收由语音转换而来的文本,并通过API请求获得豆包AI的回复内容。需配置正确的请求参数和认证信息。

1、访问火山引擎官网,注册账号并进入豆包大模型服务页面。

2、创建项目并申请API Key与Endpoint ID,用于后续的身份验证。

3、使用Python或其他编程语言编写代码,构造包含用户问题的JSON格式请求体。

4、向豆包提供的API地址发送POST请求,附带必要的请求头信息,包括Authorization字段。

5、接收服务器返回的JSON响应,提取其中的“content”字段,即为AI生成的文本答案。

关键点是确保API调用频率不超过配额限制,避免触发限流策略导致服务中断。

该步骤旨在将豆包AI返回的文本答案转换成自然流畅的语音,完成从听到说的闭环流程。

1、选择与ASR服务同一家或独立的TTS平台,如阿里云语音合成或Google Cloud Text-to-Speech。

2、将上一步获取的AI回复文本传入TTS API,设置合适的音色、语速和语调参数。

3、发起请求生成音频流,支持MP3或WAV格式输出。

4、在设备端调用本地音频播放器接口,实时播放生成的语音文件。

为保证用户体验,应启用流式音频输出模式,使语音在生成过程中即可开始播放,减少等待时间。

为了实现完整的语音助手交互体验,需要一个中央控制模块来串联语音识别、AI对话和语音合成三个环节。

1、使用Python脚本或Node.js服务作为中间层程序,统一管理各组件之间的数据流转。

2、设定触发机制,例如长按按钮启动录音,松开后自动提交语音识别。

3、在收到ASR结果后立即调用豆包API,同时监听其响应状态。

4、一旦获得AI回复文本,立刻转发至TTS服务进行语音生成。

5、加入异常处理逻辑,当任一环节失败时提示错误信息并允许重试。

可添加静音检测功能,在用户停止说话后自动结束录音并进入处理阶段,提升交互自然度。

以上就是豆包AI能做语音助手吗_豆包AI语音功能使用方法的详细内容,更多请关注php中文网其它相关文章!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号