蚂蚁集团近日正式开源了业界首个高性能扩散语言模型推理框架dinfer。

在多项基准测试中,dInfer展现出卓越的性能表现:其推理速度相较英伟达推出的扩散模型推理框架Fast-dLLM提升了10.7倍;在代码生成任务HumanEval中,单批次推理速度达到惊人的1011 Tokens/秒,首次在开源社区实现扩散语言模型的推理效率超越主流自回归模型。这一成果表明,扩散语言模型具备巨大的效率潜力,通过系统性工程创新可充分释放,为通往AGI的技术路径提供了极具竞争力的新选择。

扩散语言模型作为一种新兴范式,将文本生成过程建模为“从噪声逐步去噪恢复完整序列”的过程,具备高度并行化、全局感知能力和结构灵活性三大核心优势。凭借这些特性,由蚂蚁集团与中国人民大学联合发布的LLaDA-MoE等模型已在多个评测中展现出与顶尖自回归(AR)模型相当的生成质量。然而,在推理效率方面,尽管dLLM理论上具备强大潜能,却长期受限于实际工程瓶颈,难以发挥其应有的优势。

当前,扩散语言模型的高效推理面临三大技术挑战:高计算开销、KV缓存机制失效以及并行解码困难。这些问题严重制约了模型的实际部署效率,如何突破这些限制,成为推动dLLM走向实用的关键难题。

为此,dInfer应运而生——这是一款专为扩散语言模型打造的、算法与系统深度融合的高性能推理框架,全面支持包括LLaDA、LLaDA-MoE、LLaDA-MoE-TD在内的多种扩散语言模型。

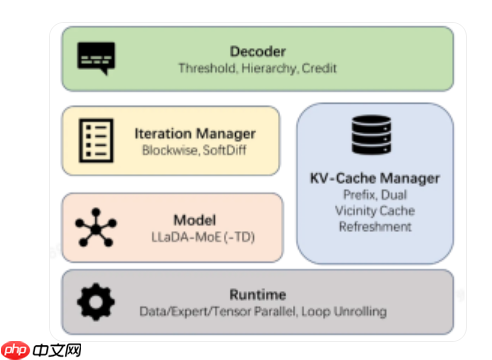

dInfer采用模块化设计,包含四大核心组件:模型接入层(Model)、KV缓存管理器(KV-Cache Manager)、扩散迭代管理器(Iteration Manager)和解码策略模块(Decoder)。这种可插拔架构使开发者能够像搭积木一样灵活组合不同优化方案,并在统一平台上进行标准化评估。更重要的是,针对上述三大挑战,dInfer在每个模块中均集成了创新性的解决方案。

在搭载8块NVIDIA H800 GPU的服务器上,dInfer的实测表现极为亮眼:

与现有dLLM推理方案Fast-dLLM相比,在保证模型效果一致的前提下,dInfer的平均推理吞吐量(avg TPS)实现了高达10.7倍的提升(681 vs 63.6);在HumanEval代码生成任务中,单批次推理速度突破至1011 tokens/秒;相较于在行业领先推理框架vLLM上运行的、参数规模和性能相近的自回归模型Qwen2.5-3B,dInfer的平均推理速度达到其2.5倍(681 vs 277)。

蚂蚁集团表示,dInfer成功连接了前沿学术研究与产业应用落地,标志着扩散语言模型从“理论可行”迈向“实践高效”的重要里程碑。此次开源,旨在邀请全球开发者与研究人员共同探索扩散语言模型的广阔潜力,携手构建更高效、更开放的人工智能新生态。

以上就是蚂蚁开源业内首个高性能扩散语言模型推理框架 dInfer的详细内容,更多请关注php中文网其它相关文章!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号