Coral NPU是什么

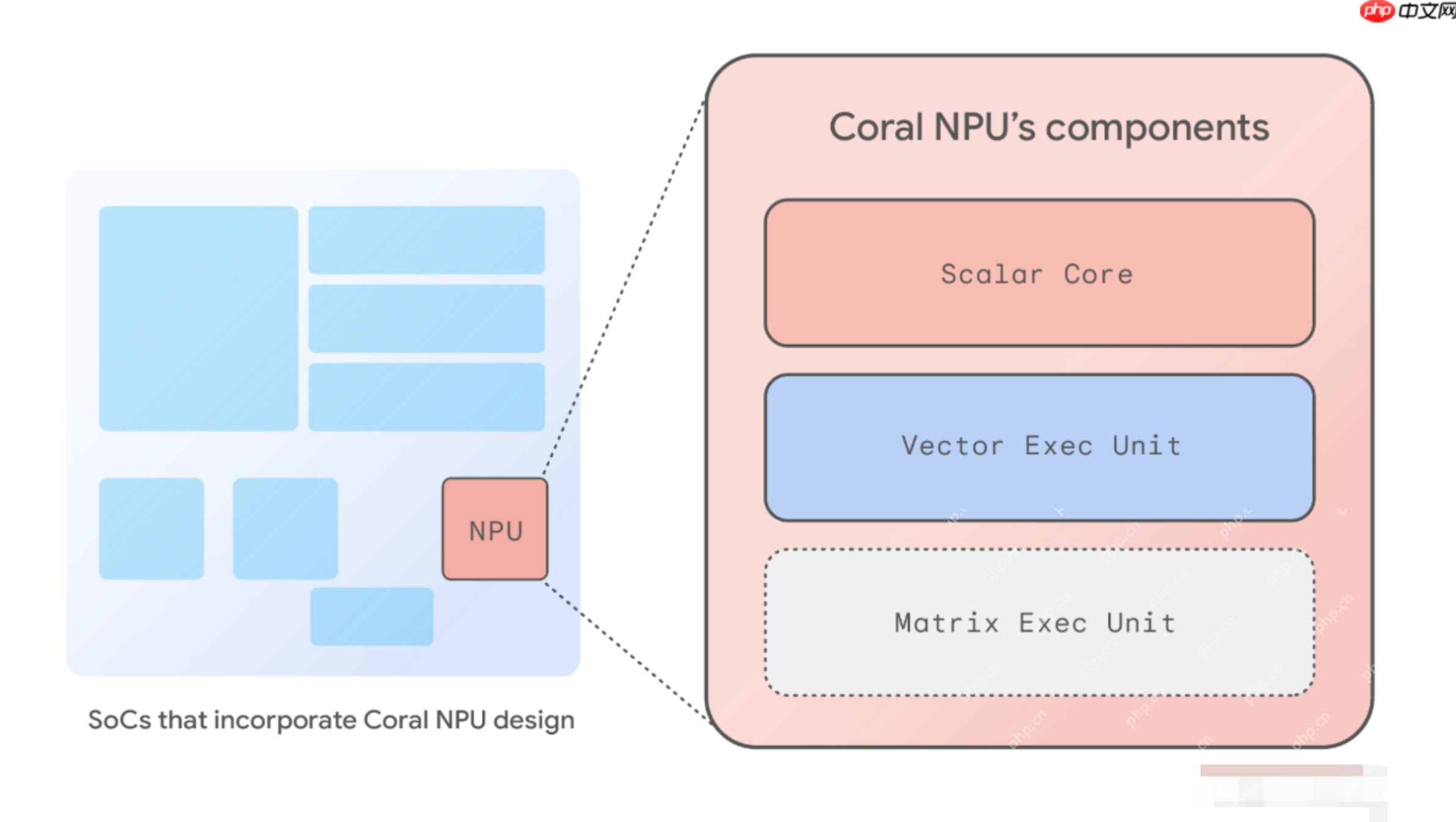

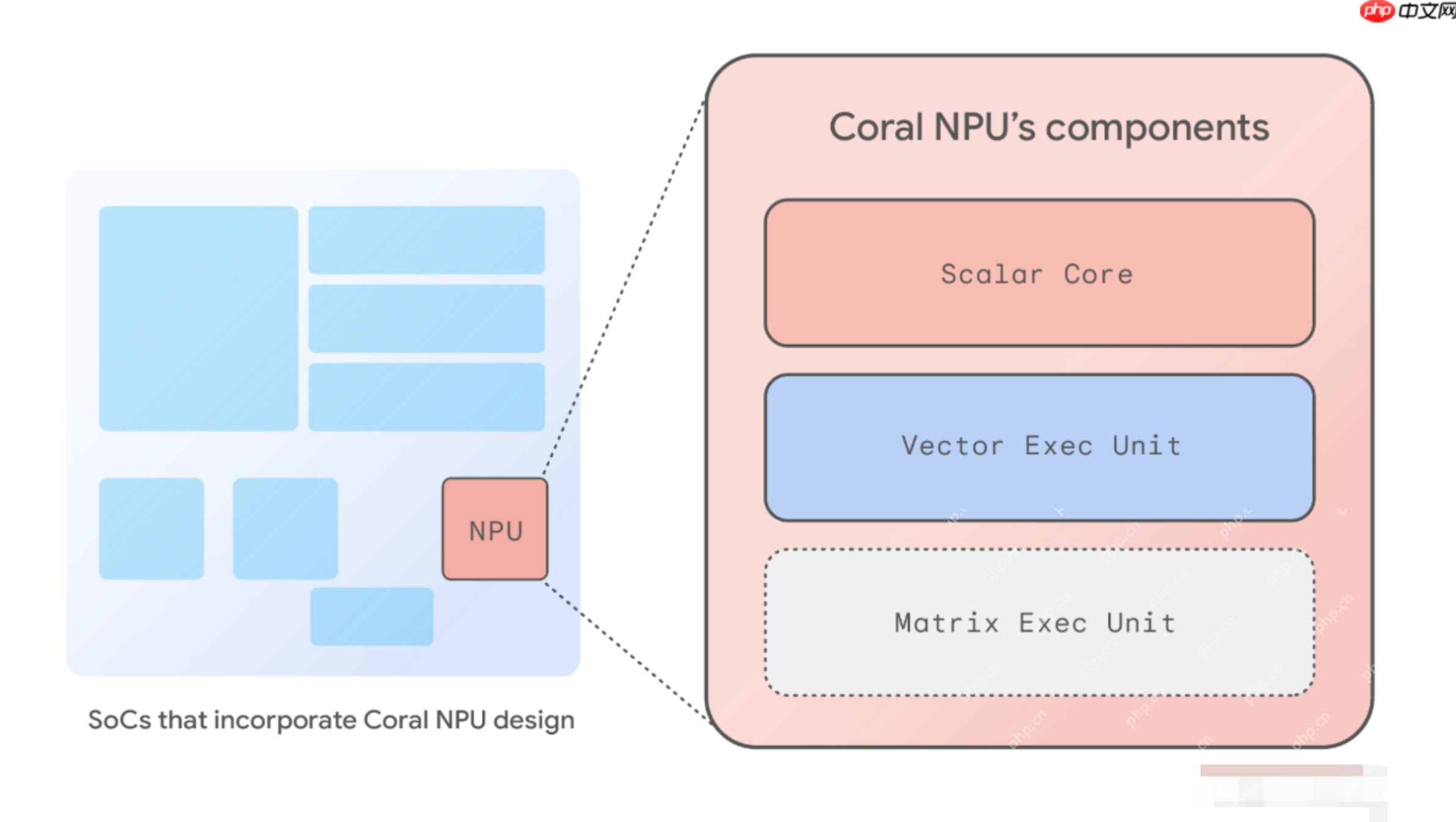

coral npu 是由谷歌推出的一个全栈开源人工智能平台,专为低功耗的边缘计算设备(例如智能手表、ar眼镜等)打造,旨在应对性能瓶颈、生态碎片化以及用户隐私保护三大核心挑战。该npu基于开放的 risc-v 指令集架构,集成了标量核心、向量执行单元和矩阵运算单元,能够高效运行各类机器学习推理任务。coral npu 提供一致且便捷的开发体验,兼容 tensorflow、jax 和 pytorch 等主流ai框架,并通过硬件级安全机制保障数据隐私。其最终目标是在最小化能耗的前提下,实现设备端全天候运行ai功能。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

Coral NPU的主要功能

-

高效的机器学习推理能力:作为专为边缘设备优化的神经处理单元,Coral NPU 能够快速执行图像分类、人物检测、姿态估计、Transformer 类模型等常见AI任务,显著提升本地推理效率。

-

极低功耗表现:得益于高度优化的硬件设计,Coral NPU 可在仅消耗几毫瓦功率的情况下持续运行,适用于对电池寿命要求严苛的可穿戴设备与物联网终端。

-

统一的开发工具链:支持主流深度学习框架如 TensorFlow、JAX 与 PyTorch,结合 IREE 和 TFLM 编译器技术,将训练好的模型转化为轻量化的二进制文件,便于部署到资源受限的边缘设备上。

-

硬件级隐私防护:集成 CHERI 等先进硬件安全技术,实现内存级别的细粒度访问控制,将敏感AI模型和用户数据隔离于受保护的安全沙箱中,有效抵御潜在攻击。

-

灵活可扩展的架构设计:基于开源 RISC-V 架构,开发者可根据具体应用场景自由定制指令集与硬件模块,满足多样化AI应用需求。

Coral NPU的技术原理

-

以AI为核心的硬件架构:Coral NPU 采用“AI优先”的设计理念,重点强化矩阵运算引擎(Matrix Engine),专门用于加速深度神经网络中最耗时的张量计算操作,同时降低通用标量运算的资源占用。

-

RISC-V 指令集支持:构建于开源 RISC-V 架构之上,支持32位地址空间及多种指令扩展(包括整数、浮点、向量等),确保平台具备良好的可编程性与可扩展性。

-

多单元协同架构:

-

标量核心:负责控制流调度与基础逻辑处理,维持系统低功耗运行。

-

向量执行单元:支持 SIMD 并行计算,适合处理大规模一维数据如音频或传感器信号。

-

矩阵执行单元:配备高效的量化乘积累加(MAC)阵列,专为神经网络中的矩阵乘法进行优化,大幅提升推理速度。

-

端到端编译工具链:利用 MLIR 中间表示语言,将来自不同框架的AI模型统一转换并优化,再通过 IREE 编译器生成针对 Coral NPU 硬件特性的高效执行代码。

-

内置硬件安全机制:引入 CHERI 架构所提供的能力式内存保护机制,实现软件分区与内存隔离,防止缓冲区溢出等常见漏洞,从物理层面增强系统安全性。

Coral NPU的项目地址

Coral NPU的应用场景

-

情境感知功能:实时识别用户的活动状态(如行走、跑步)、所处环境(室内/室外)或移动情况,自动触发免打扰模式或其他智能响应,提升用户体验。

-

智能音频处理:实现关键词唤醒、语音命令识别、环境声检测、实时语音翻译与语音转文字等功能,广泛应用于助听设备、语音助手等场景。

-

本地化图像理解:支持人脸检测、物体识别、手势追踪以及低功耗视觉搜索,使设备无需联网即可完成视觉感知任务。

-

自然交互方式:结合手势识别、声音提示和多传感器融合技术,让用户可以通过更直观的方式操控设备,推动人机交互向无感化发展。

以上就是Coral NPU— 谷歌推出的全栈开源AI平台的详细内容,更多请关注php中文网其它相关文章!