蚂蚁百灵大模型团队近日正式推出了全新开源全模态大模型——ming-flash-omni-preview,标志着首个参数规模突破千亿的全模态模型正式向社区开放。该模型基于ling 2.0的稀疏moe架构构建,总参数量达103b,激活参数仅为9b,在保持高效推理的同时显著提升了多模态理解与生成能力。

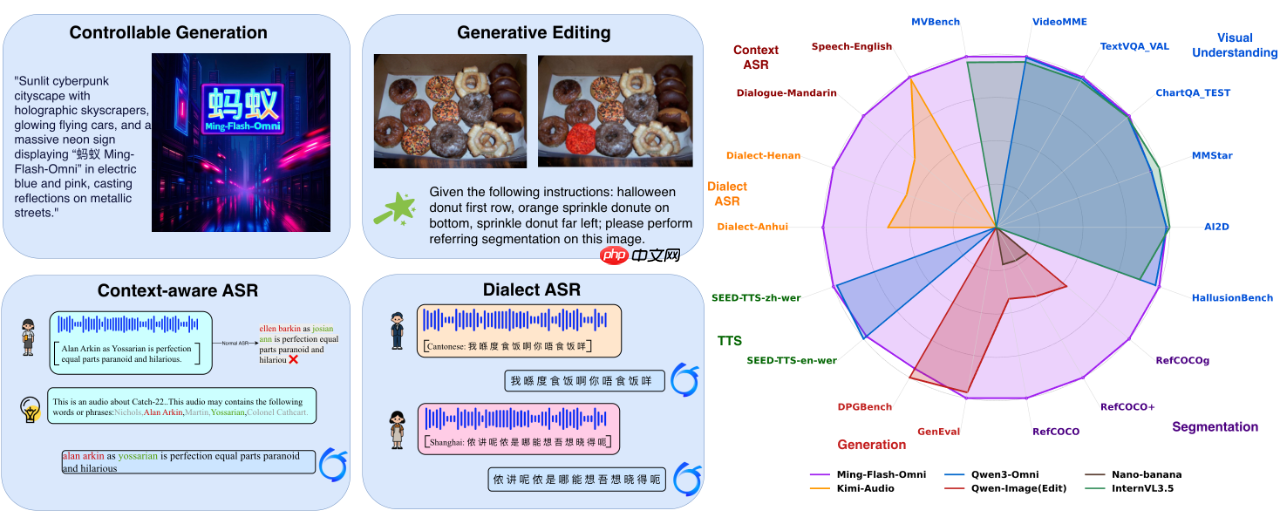

相较于此前广受好评的Ming-lite-omni-1.5,新模型在图像、视频、语音等多个模态任务中实现了全面升级,尤其在可控图像生成、流式视频理解和高精度语音识别方面表现突出,整体性能位居当前开源全模态模型前列。

据团队介绍,Ming-flash-omni-Preview 在技术层面进行了多项关键优化,主要体现在以下三个方面:

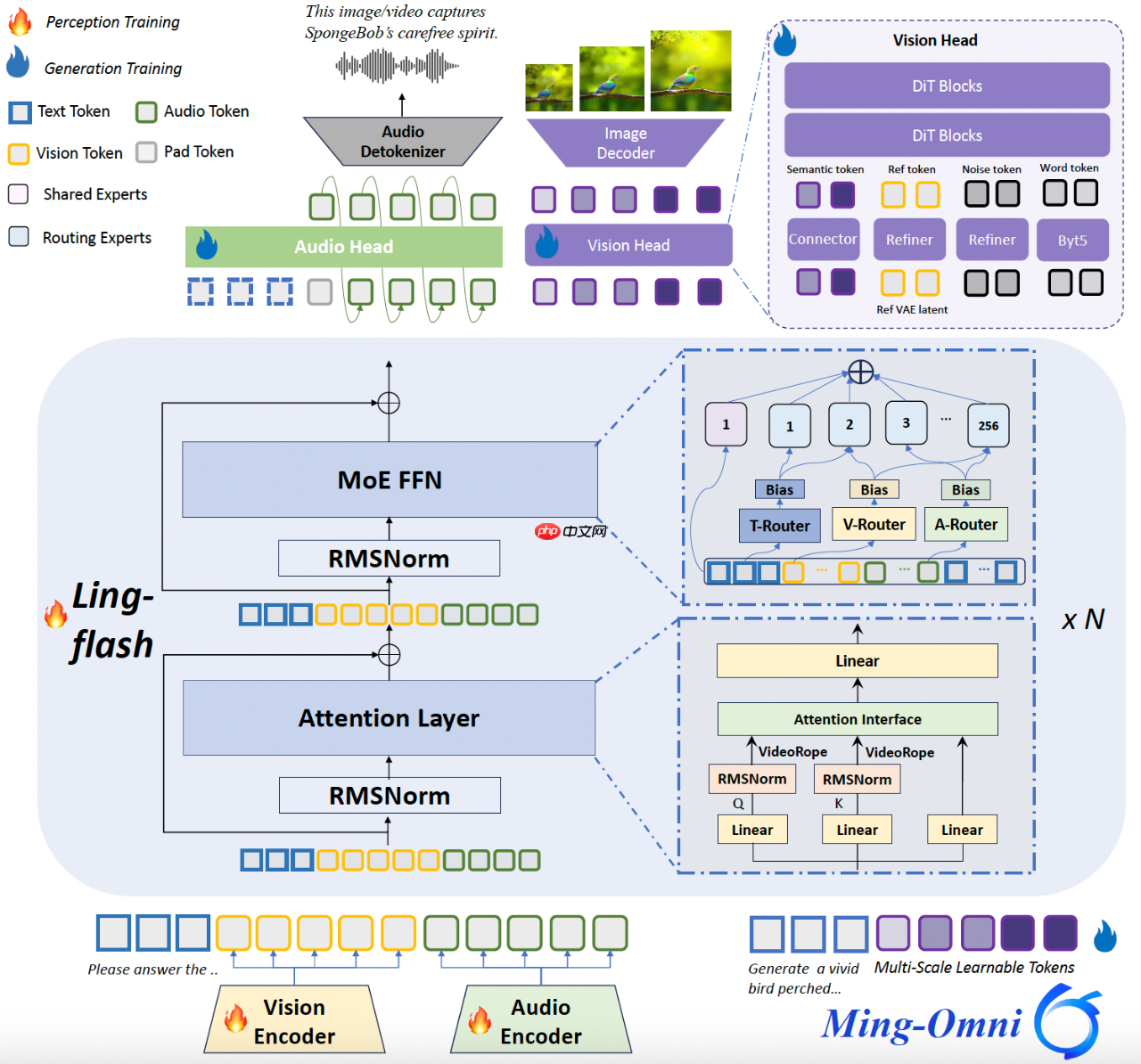

1) 基于稀疏专家架构的全模态协同训练

本模型将Ling-flash-2.0所采用的稀疏MoE架构成功扩展至全模态场景,并沿用Ming-lite-omni提出的模态级路由机制,实现对不同模态数据分布和专家分配策略的精准建模,达成“大容量、小激活”的高效运行模式。通过在注意力层引入VideoRoPE(Video Rotary Position Embedding),增强了对长时视频内容的时空建模能力,显著提升视频交互理解水平。

在训练稳定性方面,团队采用了混合式专家负载均衡方案:

2)生成式分割与编辑一体化训练范式

在统一多模态系统中,如何深度融合图像的理解与生成能力是一大核心挑战。虽然Ming-lite-omni-1.5通过冻结语言通路并引入多尺度QueryToken注入层级化语义,在一定程度上实现了理解与生成的融合,但由于两类任务目标本质差异,诸如物体属性、空间关系等细粒度视觉知识仍难以有效迁移至生成端,限制了生成质量与控制精度。

为此,Ming-flash-omni-Preview创新性地提出 “生成式分割即编辑”(Generative Segmentation as Editing) 的协同训练框架。该方法将传统图像分割任务重构为语义保持型编辑指令,例如:“把香蕉涂成紫色”。这一设计的关键优势在于:

实验表明,在GenEval基准测试中,Ming-flash-omni-Preview取得0.90分的成绩,超越所有非强化学习(non-RL)方法;在GEdit基准上的精准编辑任务(如物体删除、替换)平均得分从6.9跃升至7.9。这些成果验证了该范式不仅提升了编辑能力,还能有效泛化至自由文本驱动的图像生成任务。

3) 高效全模态训练架构设计

全模态基础模型的训练常面临两大瓶颈:数据异构性(各模态序列长度不一)与模型异构性(专用编码器结构差异导致并行困难),易引发负载不均、内存碎片和流水线气泡,严重影响训练效率。

针对上述问题,团队基于Megatron-LM框架实施了两项关键技术改进:

这些优化使得Ming-flash-omni-Preview的训练吞吐量相比基线系统提升近一倍,大幅缩短了大规模全模态模型的迭代周期。

目前,Ming-flash-omni-Preview 的完整模型权重与训练代码已全面开源,欢迎开发者与研究者使用:

GitHub: https://www.php.cn/link/eb901025f1ff4d8010f655b42a33210d

HuggingFace: https://www.php.cn/link/341c1d108df518a9ad0047345b7b641a

ModelScope: https://www.php.cn/link/fc815a0b7bc84dce6b9c6f8ca4c28ad5

以上就是蚂蚁发布千亿参数开源全模态大模型 Ming-flash-omni-Preview的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号