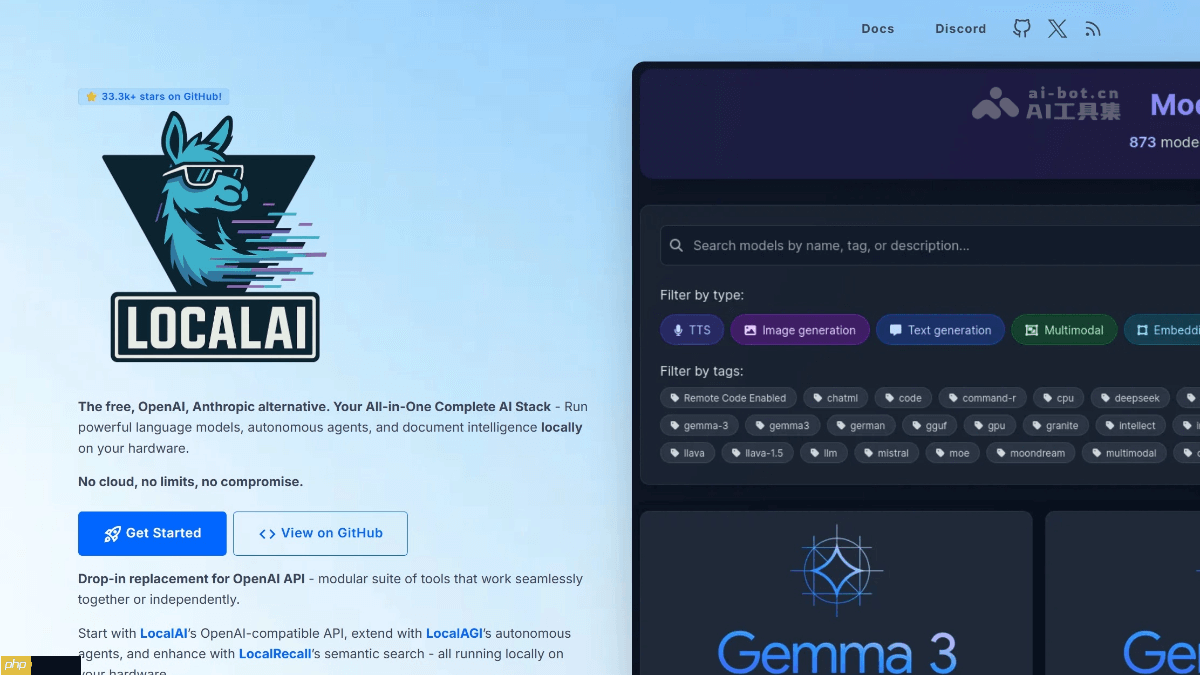

LocalAI是什么

localai 是一个开源的本地化 ai 推理平台,旨在为用户提供完整的离线人工智能解决方案。它支持多种多模态模型,涵盖文本生成、图像创作、语音识别与合成等功能,并完全兼容 openai 的 api 接口标准。其核心设计理念是隐私优先——所有数据处理均在本地设备上完成,无需将任何信息上传至云端。localai 可运行于多种硬件环境,无论是仅依赖 cpu 的低配设备,还是搭载 nvidia、amd 或 intel gpu 的高性能机器都能良好支持。同时,它兼容 ggml、gguf 和 gptq 等主流模型格式,提供灵活的部署方式。系统还集成了 localagi(用于构建自主智能体)和 localrecall(实现语义搜索与记忆功能)等扩展组件,适用于需要综合 ai 能力的应用场景。

RPCMS是一款基于PHP+MYSQL的轻量型内容管理/博客系统,支持PHP5.6版本以上,支持win/Linux系统。它自主研发的RP框架(OPP方式),采用MVC架构搭建的高效、稳定的内容管理系统。灵活小巧,但有着强大的扩展性、丰富的插件接口和大量的模板。统一采用模板标签,轻松上手,让开发更方便!智能缓存机制让网站运行方面大幅度提高。系统特点:源码简洁、体积轻巧、功能丰富、安全、灵活等特点,完

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

LocalAI的主要功能

LocalAI的主要功能

- 多模态能力集成:LocalAI 支持包括文本生成、图像生成、语音转写、文字转语音在内的多种 AI 功能。例如,可通过图像生成接口自动将实验数据转化为可视化图表。

- OpenAI API 兼容设计:提供与 OpenAI 标准一致的 RESTful API 接口,用户可在本地环境中无缝替换原有 OpenAI 服务,现有应用无需代码修改即可实现本地化迁移。

- 本地化推理保障隐私:所有 AI 计算任务均在本地执行,不依赖外部服务器,杜绝敏感信息外泄风险,确保企业或个人的数据安全。

- 广泛的硬件适配性:支持从纯 CPU 到各类 GPU(NVIDIA、AMD、Intel)的多种配置,适合不同性能需求和预算的用户。

- 图形化 Web 操作界面:配备直观的 WebUI,便于进行模型管理、文件上传、对话测试及参数调整等操作,降低使用门槛。

- 高效的模型加载机制:通过 gRPC 接口实现模型的动态加载与管理,支持预加载常用模型至内存,显著减少首次响应延迟。

- 函数调用与系统集成:具备工具调用能力,允许开发者将外部函数或服务接入 AI 流程,便于嵌入到已有业务系统中。

LocalAI的技术原理

- 基于成熟开源项目构建:LocalAI 借助多个知名开源框架实现核心功能,如使用 llama.cpp 和 gpt4all.cpp 处理文本生成,whisper.cpp 实现语音识别,Stable Diffusion 支持图像生成等。

- 遵循 OpenAI API 协议:通过模拟 OpenAI 的 API 结构,LocalAI 实现了高度兼容性,使开发者能够以最小成本将云端应用迁移到本地环境。

- 跨平台硬件优化:支持多种计算设备,结合量化技术(如 ggml/q4_0),可在消费级电脑甚至树莓派等边缘设备上高效运行大语言模型。

- 分布式推理架构设计:采用 P2P 网络结构实现分布式计算,任务可被拆分并分发至多个节点协同处理。节点发现依赖 mDNS 与 DHT 协议,通信过程由 libp2p 加密保障安全性。

- 智能任务调度策略:在去中心化的网络中,系统根据各节点的 CPU 占用率、内存状态和网络延迟动态分配请求,优先选择资源空闲的节点,提升整体系统的稳定性与响应效率。

LocalAI的项目地址

- 官方网站:https://www.php.cn/link/71f0603a717117b0bc2df3f784862801

- GitHub 仓库:https://www.php.cn/link/de6f3928abff533f338ec3847320b0d1

LocalAI的应用场景

- 企业私有化部署:可在企业内网搭建专属 AI 助手,用于文档分析、代码审查、内部知识问答等任务,全程数据不出内网,保障信息安全。

- 本地开发辅助:作为程序员的离线 AI 编程助手,快速完成代码补全、错误排查、注释生成等工作,提升开发效率。

- 无网络环境下的 AI 使用:适用于科研野外作业、飞行途中或封闭网络等无法联网的场景,依然可运行 AI 功能。

- 自主 AI Agent 构建:在本地部署具备决策与行动能力的智能代理,实现自动化流程处理,避免对云服务的依赖。

- 本地知识库与语义检索:结合 LocalRecall 组件,建立个人或团队的知识记忆系统,增强 AI 对上下文的理解与长期记忆能力。

- 创意内容本地生成:支持在本地生成文章、插图、音频等内容,广泛应用于独立创作、营销素材制作和多媒体项目开发。