阿里云百炼重磅推出qwen2.5-turbo模型,支持百万级超长上下文!该模型在多个长文本评测集上性能超越gpt-4,现已正式上线阿里云百炼平台,所有用户均可通过api调用。

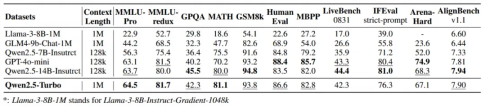

Qwen2.5-Turbo在长文本检索任务中准确率高达100%,并在RULER评测集上取得93.1分,优于GPT-4。 在LV-Eval和LongBench-Chat等更贴近实际应用场景的长文本任务中,其表现也显著超越了GPT-4o-mini。此外,在MMU和LiveBench等短文本基准测试中,Qwen2.5-Turbo同样表现出色,大幅领先同等上下文长度的开源模型。

Qwen2.5-Turbo:长短文本任务全能高手

在推理速度方面,得益于稀疏注意力机制的应用,Qwen2.5-Turbo将处理百万级上下文时的首字返回时间缩短至68秒,较之前提升了4.3倍。

Qwen2.5-Turbo:速度与效率的完美结合

Qwen2.5-Turbo可广泛应用于长篇小说分析、大型代码辅助、多篇论文综合解读等领域,例如一次性处理10部长篇小说、150小时的演讲稿或3万行代码。为庆祝上线,阿里云百炼还为用户提供1000万tokens的免费额度。

研发团队表示,长文本处理仍面临诸多挑战,未来将持续改进模型,提升推理效率并研发更强大、更长上下文长度的模型。

目前,阿里云百炼平台已集成Qwen、Llama、Flux等200多款国内外主流大模型,提供模型调用、微调训练和RAG应用构建等多种服务,已服务超过30万家企业和机构,包括一汽、金山、哈啰集团和国家天文台等。 百万tokens仅需0.3元,性价比超高!