大家好,我是星哥,之前分享了许多关于本地ollama的安装和使用deepseek等大模型的文章。这篇文章将重点介绍如何利用ollama和open-webui在局域网中与团队成员共享deepseek等大模型。

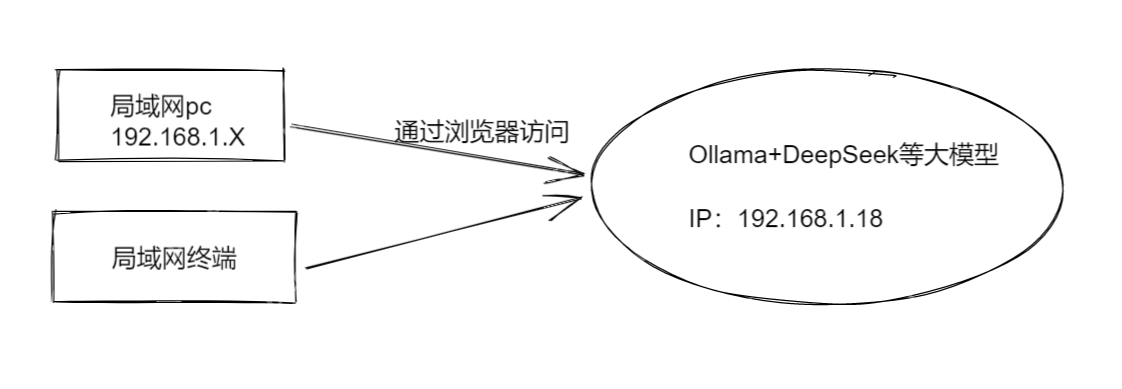

image-20250210183046725我们的最终目标是通过浏览器访问大模型服务器的IP和端口,轻松使用DeepSeek等大模型。

image-20250210183046725我们的最终目标是通过浏览器访问大模型服务器的IP和端口,轻松使用DeepSeek等大模型。

image-20250210182831944准备工作包括部署本地国产DeepSeek大模型,详细步骤可参考这篇文章:https://www.php.cn/link/03d015a5f7a729b37c5f35c89516c4b2。

image-20250210182831944准备工作包括部署本地国产DeepSeek大模型,详细步骤可参考这篇文章:https://www.php.cn/link/03d015a5f7a729b37c5f35c89516c4b2。

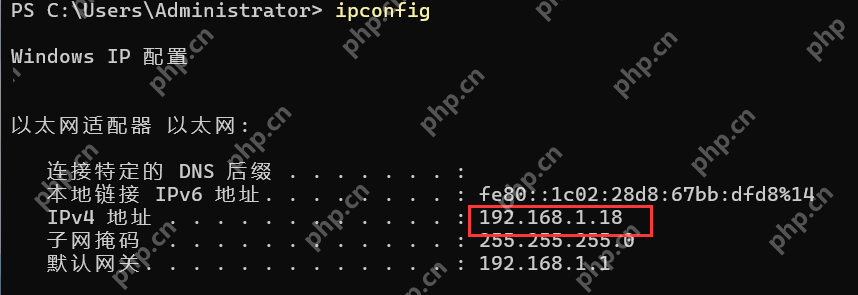

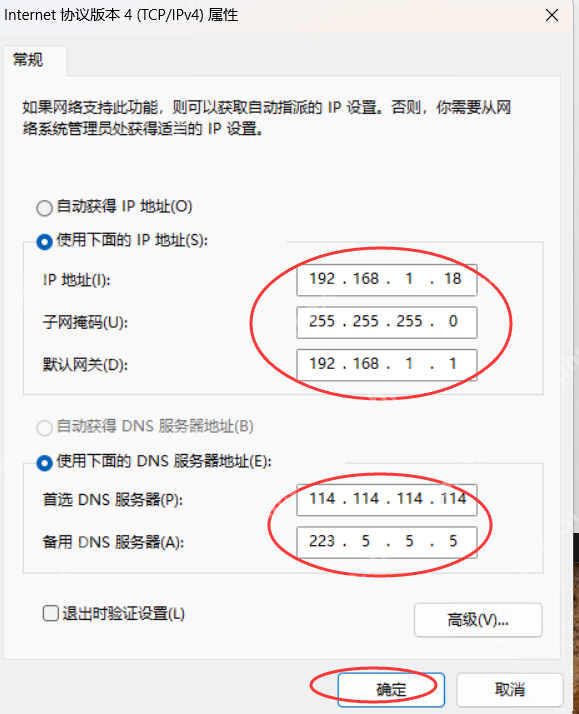

安装好Ollama、Open Webui以及开源大模型(如DeepSeek、Llama等)后,需修改Ollama服务的IP。因为局域网的IP段是192.168.1.X,为了防止DHCP将IP分配给其他设备,我固定了IP。

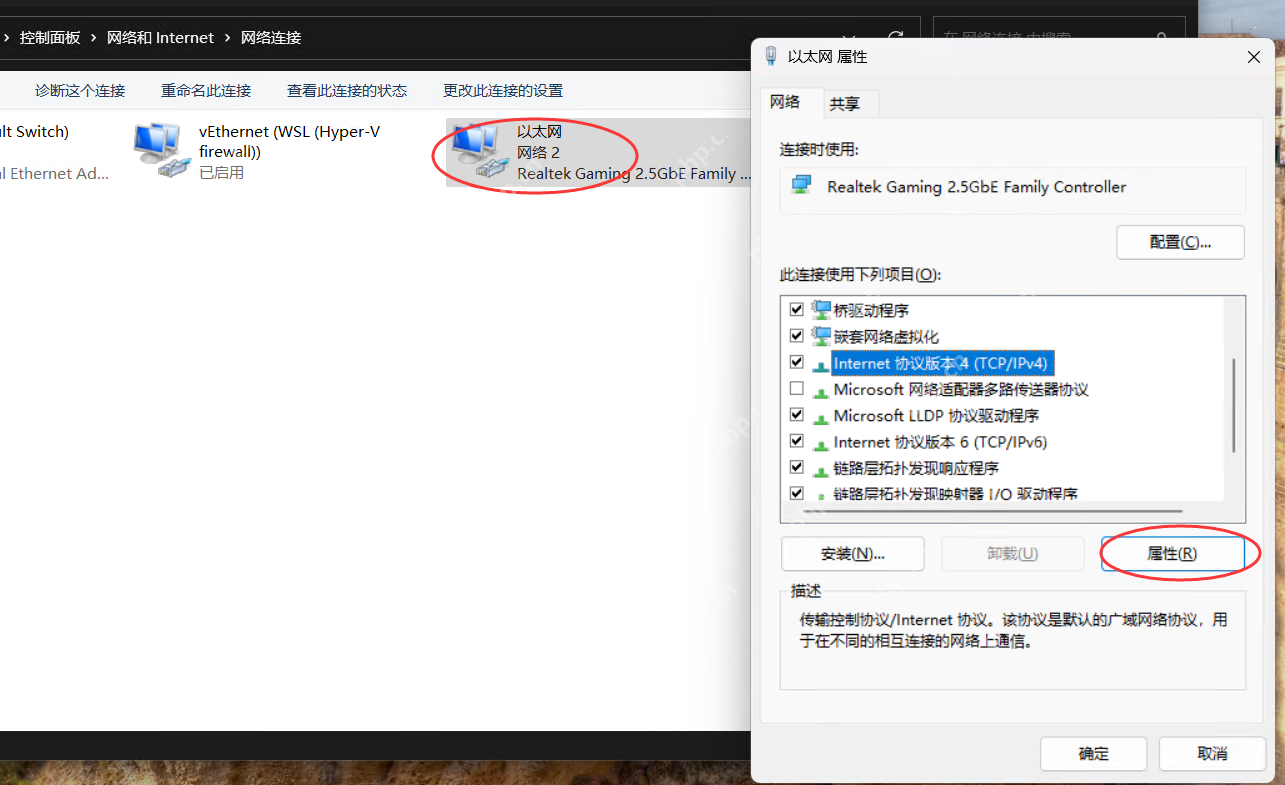

image-20250210173010428我使用的是Win11系统,固定IP的步骤如下:打开TCP/IPV4设置,并根据实际需要设置固定内网IP。

image-20250210173010428我使用的是Win11系统,固定IP的步骤如下:打开TCP/IPV4设置,并根据实际需要设置固定内网IP。

image-20250210180402815

image-20250210180402815

image-20250210180458740

image-20250210180458740

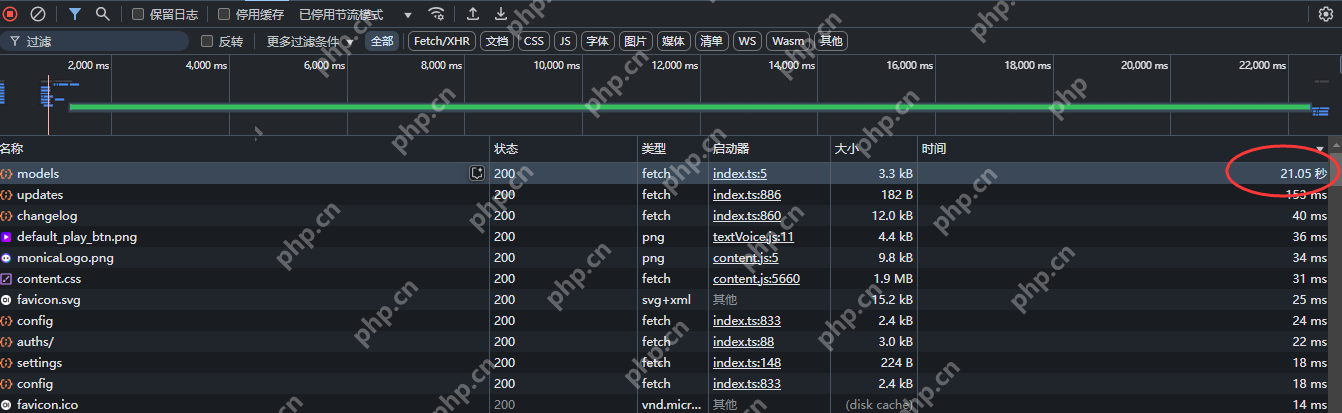

问题1:Open Webui打开速度慢

通过浏览器使用IP和端口访问Open Webui时,发现打开/api/models非常慢,每次都超过20秒。

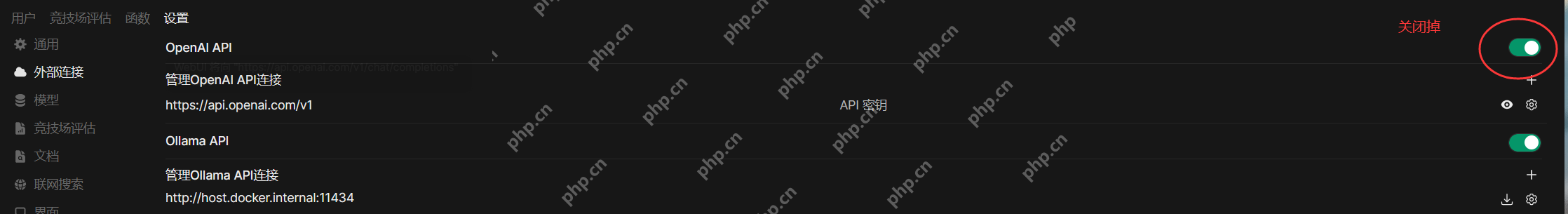

image-20250210172853624解决这个问题的方法是进入管理员面板,找到外部链接选项,并关闭openai_api。这是因为网络环境导致的。

image-20250210172853624解决这个问题的方法是进入管理员面板,找到外部链接选项,并关闭openai_api。这是因为网络环境导致的。

image-20250210181020458

image-20250210181020458

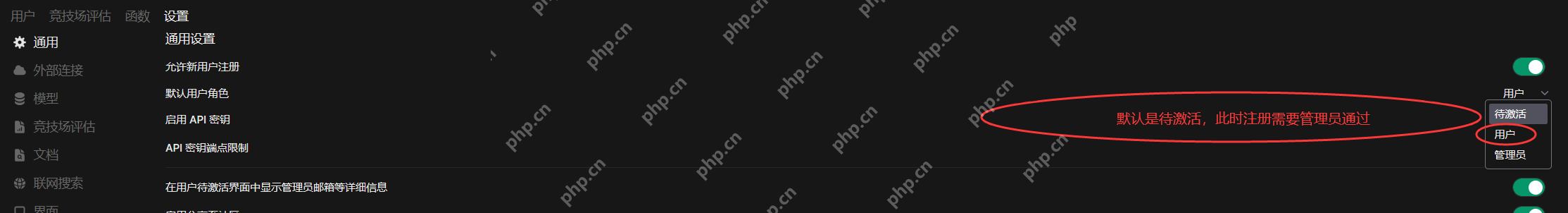

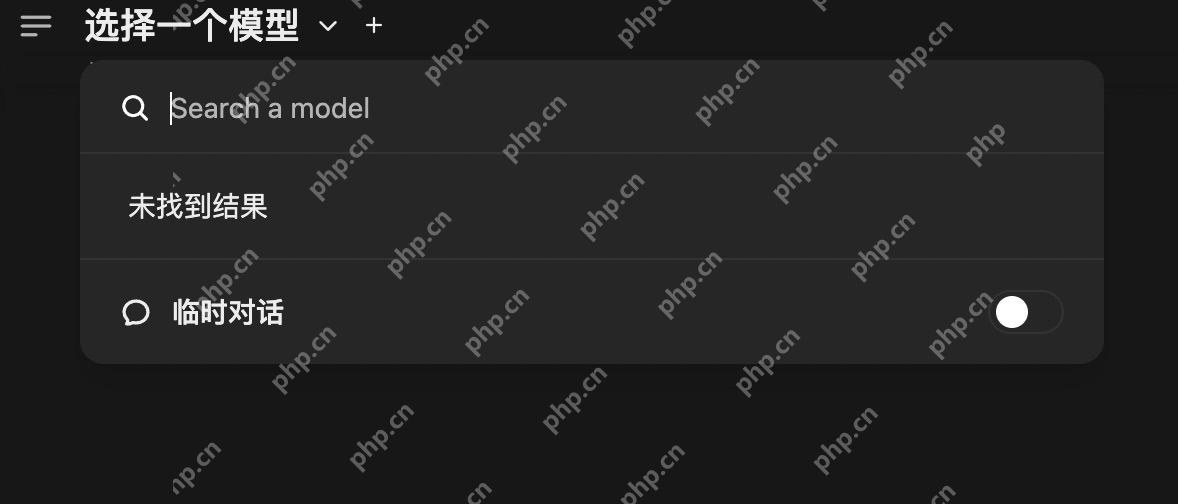

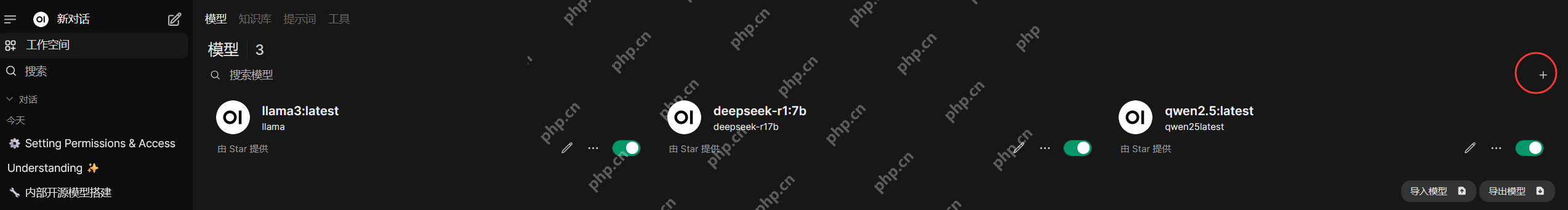

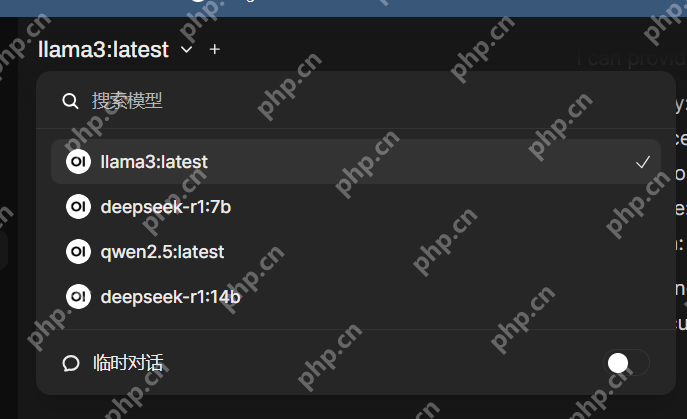

问题2:新用户无法使用大模型

image-20250210181307668

image-20250210181307668

image-20250210181616213

image-20250210181616213

image-20250210181729902

image-20250210181729902

image-20250210181919020

image-20250210181919020

image-20250210182012823

image-20250210182012823

image-20250210182155160

image-20250210182155160

验证

image-20250210182354626

image-20250210182354626

通过上述步骤,团队成员即可通过局域网使用你的Ollama。

结束

通过结合Ollama和Open-WebUI,我们能够非常方便地在局域网中与团队成员共享大模型(如DeepSeek)。这种方法不仅简单直观,还可以通过Web界面让不熟悉命令行的同事轻松使用模型。无论是在本地开发环境中还是公司内部网络内,这种方法都能大大提高团队的协作效率。

写文不易,如果你看到这里,请点个赞和在看,分享给更多的朋友;也别忘了关注星哥玩云!这里有满满的干货分享,还有轻松有趣的技术交流~点个赞、分享给身边的小伙伴,一起成长,一起玩转技术世界吧!?

以上就是使用Ollama+Open-Webui把DeepSeek等大模型分享给团队的小伙伴使用的详细内容,更多请关注php中文网其它相关文章!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号