deepseek开源周首日惊喜发布!首个亮相项目flashmla突破h800算力极限,ai推理速度大幅提升

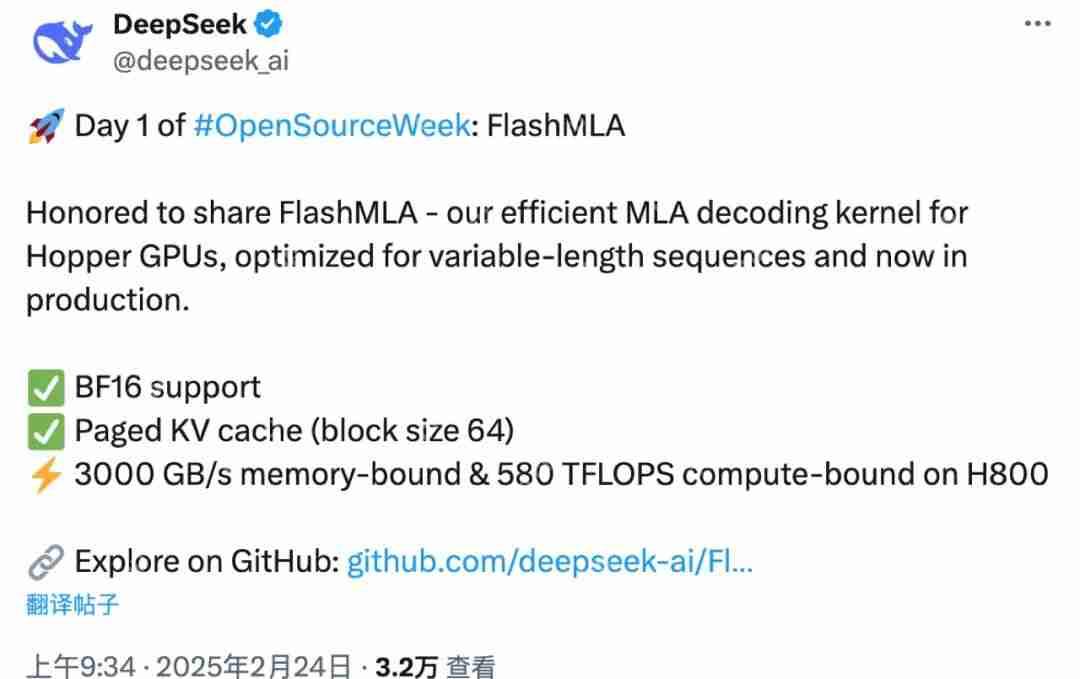

2025年2月24日,DeepSeek正式启动为期五天的“开源周”,首个亮相的“王炸级”项目——FlashMLA(专为英伟达Hopper GPU优化的高效MLA解码内核)迅速引爆AI社区。这个工业级优化方案不仅挑战了H800的算力天花板,更让中高端消费级GPU也能轻松运行大模型,为AI普惠化注入新动能。

一、技术突破:三大创新重塑算力格局

变长序列处理革命:FlashMLA针对对话、文章生成等场景的变长文本优化,通过动态分桶调度和分页式KV缓存(64块大小),将GPU内存利用率提升至极致,显存占用减少40%,推理延迟降低60%。传统方案需通过“填充”统一长度,浪费30%以上算力,而FlashMLA实现“零填充”批处理,让长短文本各得其所。

极致性能表现:H800极限调优:在H800 SXM5平台(CUDA 12.6)上,内存受限配置达3000 GB/s带宽,计算受限配置达580 TFLOPS算力,逼近Hopper架构理论峰值。BF16精度支持:结合混合精度计算,兼顾速度与数值稳定性,相比FP32效率提升显著。

训练成本杀手锏:MLA(多头潜注意力)机制将每次查询的KV缓存量减少93.3%,配合MoE架构,使DeepSeek大模型训练成本大幅降低。网友 @Hemang Dave指出,类似技术可让模型规模比GPU显存大两倍,推理速度提升20-25倍。

二、开源意义:推动AI技术普惠化

FlashMLA的开源打破了算力垄断,让全球开发者免费获得工业级优化方案:

- 加速技术迭代:基于FlashAttention、Cutlass等开源项目二次创新,推动算法与硬件协同设计。

- 降低部署门槛:中高端GPU(如RTX 4090)即可运行更大模型,减少企业硬件升级成本。

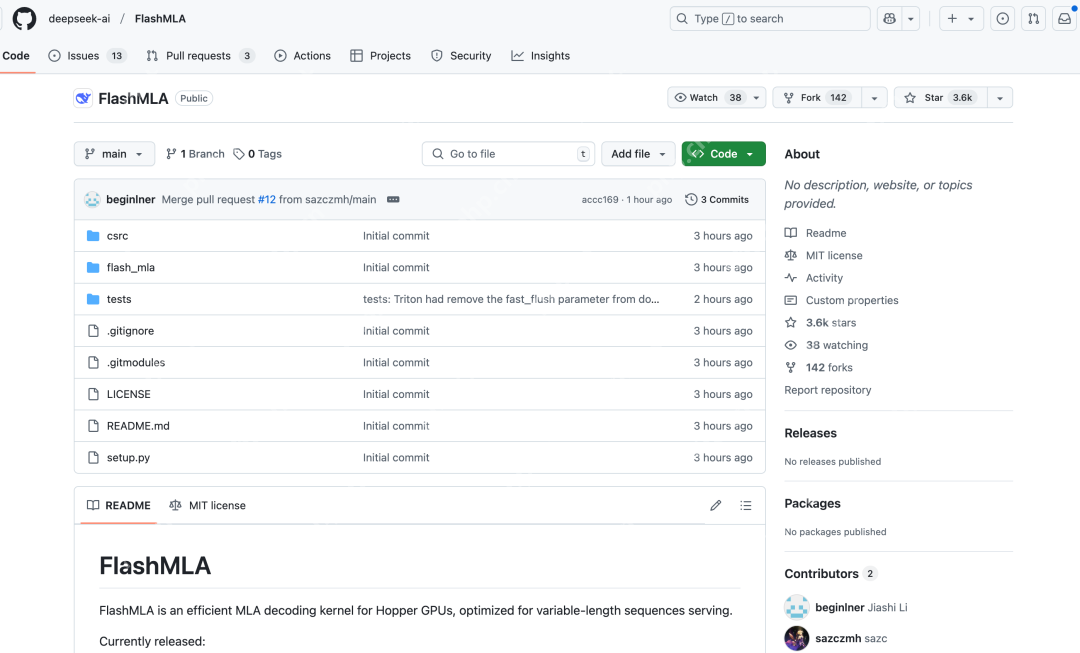

- 生态繁荣:GitHub首发1小时获1.2k Star,开发者社区已涌现多语言适配、量化优化等衍生方案。

三、未来展望:AGI征程再加速?

DeepSeek R1模型因MLA技术加持,已在开源平台“抱抱脸”获超1万点赞,成为最受欢迎模型。网友热议:“第五天会不会开源AGI?”结合其多Token预测(MTP)和MoE架构创新,DeepSeek正以“算法+工程”双轮驱动,重新定义AI训练范式。

GitHub仓库:https://www.php.cn/link/a588b762d68fe60225d3de3c647a52b9

Ending