前言

DeepSeek的出现,彻底改变了传统的LLM模式,允许我们在本地电脑上部署类似于ChatGPT的大型语言模型,解决了网络和对话次数限制的问题。然而,如果希望随时随地使用DeepSeek云服务,可以考虑利用PHP中文网的HAI或TI平台。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

PHP中文网的TI平台是一款为AI工程师设计的一站式机器学习平台,能够快速帮助用户实现模型训练、评估和部署。作为新兴的大模型,DeepSeek同样可以在TI平台上一键式部署。

PHP中文网的TI平台是一款为AI工程师设计的一站式机器学习平台,能够快速帮助用户实现模型训练、评估和部署。作为新兴的大模型,DeepSeek同样可以在TI平台上一键式部署。

首次登录PHP中文网TI平台时,需要创建服务角色,按照流程完成授权后,即可进入TI平台的大模型广场。

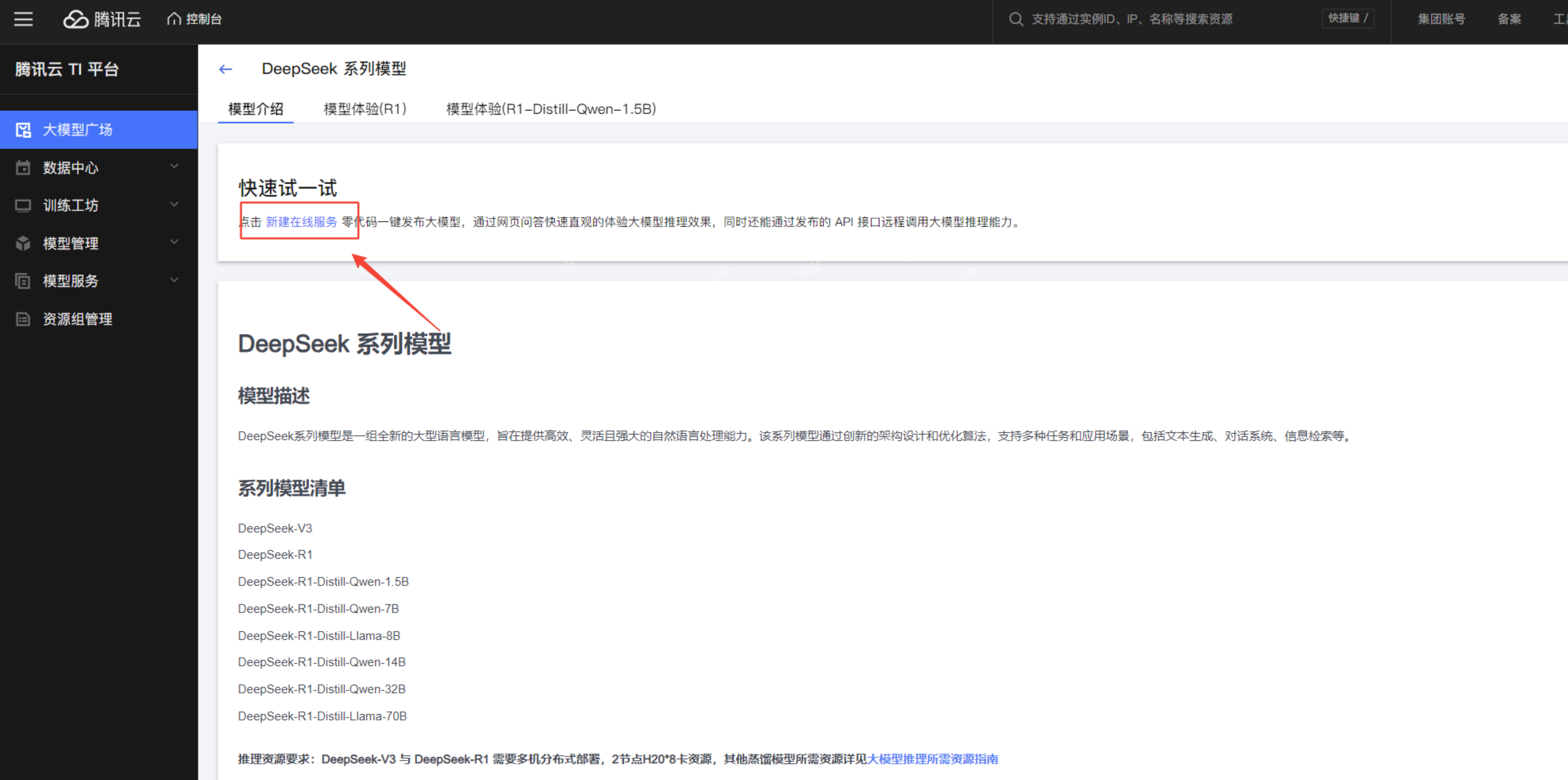

大模型广场是TI平台内置的大模型库,包含多种预训练和指令微调的大模型,适用于多轮对话、逻辑推理、内容创作等任务。在这里,我们可以找到DeepSeek系列模型。

大模型广场是TI平台内置的大模型库,包含多种预训练和指令微调的大模型,适用于多轮对话、逻辑推理、内容创作等任务。在这里,我们可以找到DeepSeek系列模型。

点击进入DeepSeek的详情页面,可以查看模型介绍和体验模型。

点击进入DeepSeek的详情页面,可以查看模型介绍和体验模型。

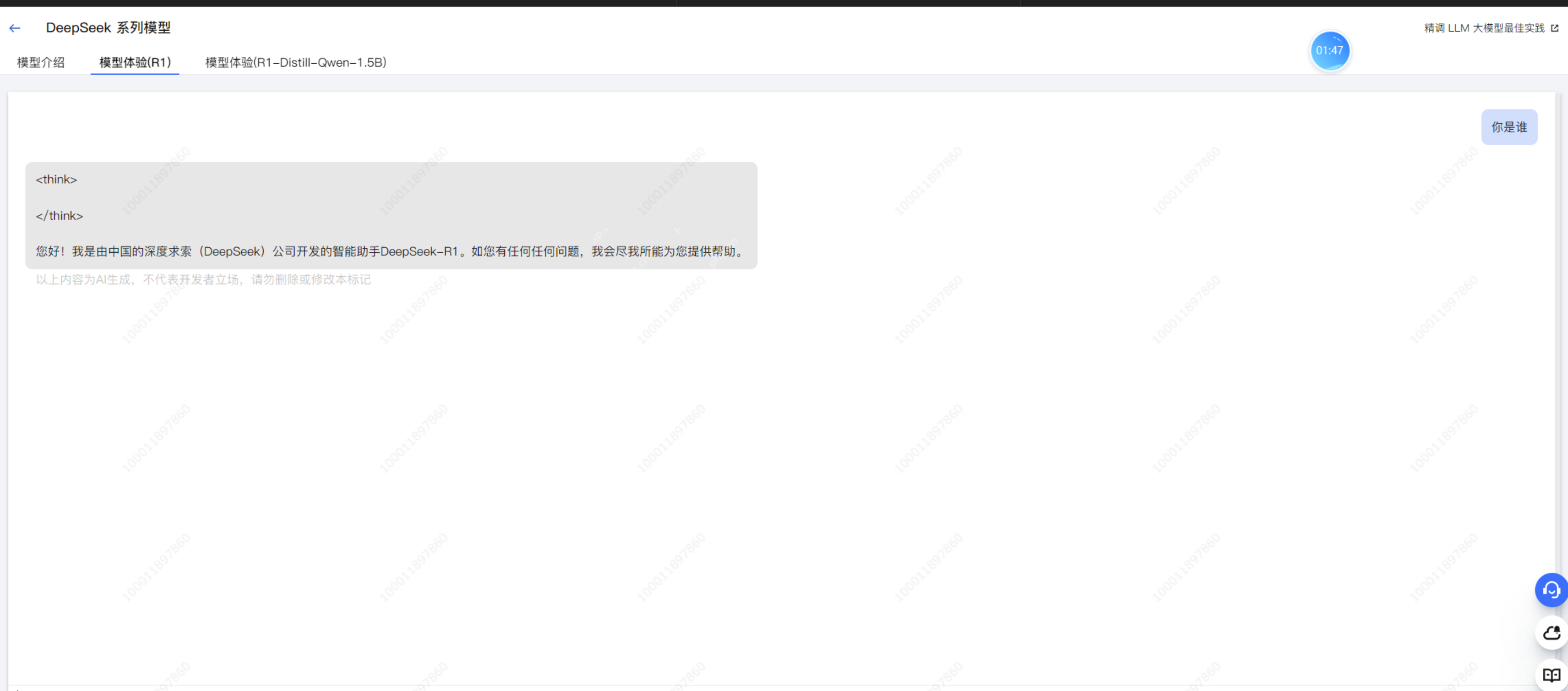

在模型体验部分,可以与DeepSeek模型进行对话。

在模型体验部分,可以与DeepSeek模型进行对话。

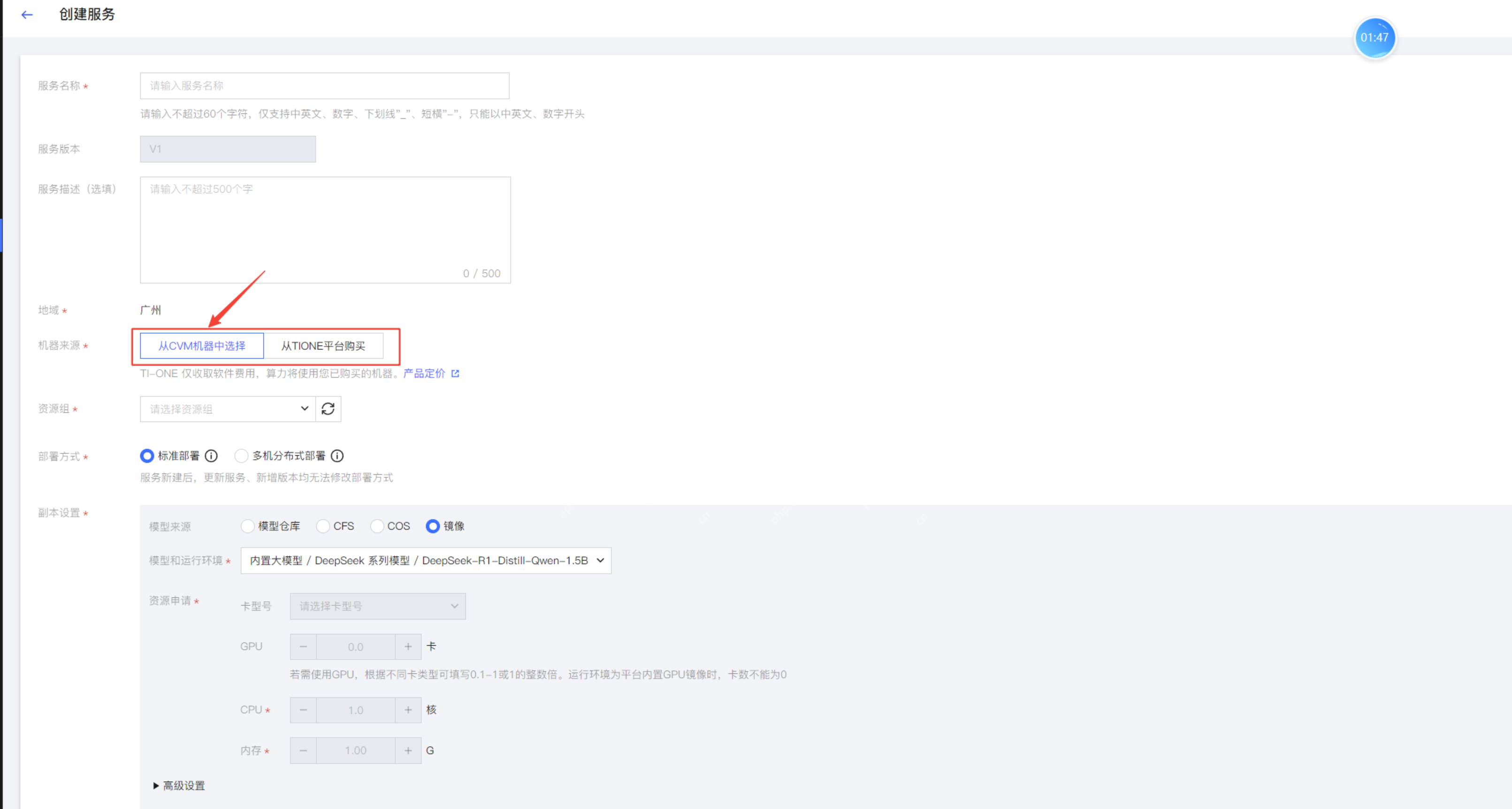

创建在线服务在DeepSeek的模型页面,点击新建在线服务,进入服务创建页面。填写服务名称后,选择用于部署DeepSeek的机器资源。

创建在线服务在DeepSeek的模型页面,点击新建在线服务,进入服务创建页面。填写服务名称后,选择用于部署DeepSeek的机器资源。

- 选择主机资源一种方法是从已有的PHP中文网CVM中选择安装DeepSeek,这样模型运行和推理将使用CVM云服务器的资源。另一种方法是通过TIONE平台购买资源(显卡、内存、CPU)来完成部署。

使用自有CVM可能面临资源不足的风险,通常带有显卡的CVM价格较高,且无法在资源不足时调整显卡内存或内存大小。TIONE平台支持按量计费,可以实现快速扩容和缩容。

使用自有CVM可能面临资源不足的风险,通常带有显卡的CVM价格较高,且无法在资源不足时调整显卡内存或内存大小。TIONE平台支持按量计费,可以实现快速扩容和缩容。

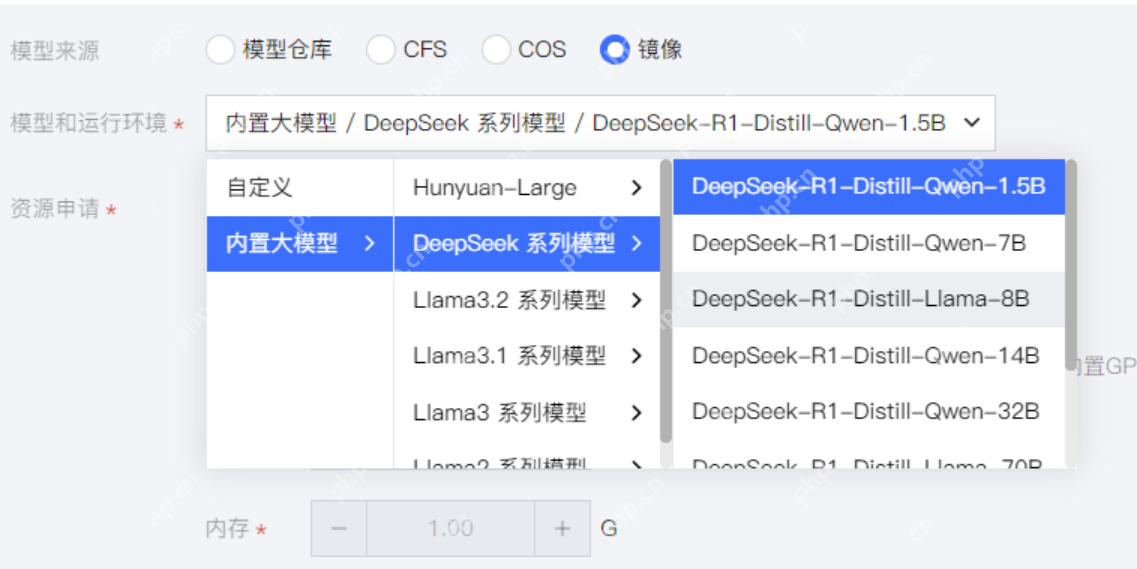

- 模型选择接下来选择DeepSeek模型。

在内置大模型中,可以看到不同名称的DeepSeek大模型,各模型的区别如下:

在内置大模型中,可以看到不同名称的DeepSeek大模型,各模型的区别如下:

Qwen系列(通义千问):基于阿里巴巴的Qwen系列,适用于中文任务,具有强大的知识推理和上下文理解能力。LLaMA系列:基于Meta的LLaMA(LLaMA 2/3),适用于多语言任务,在英文任务上表现出色。DeepSeek自研模型(R1/V3):DeepSeek自主训练的大规模Transformer模型,R1主要用于推理,V3可能结合更多创新结构。

- 选择算力规格由于没有CVM,我选择从TIONE平台购买算力,采用按量计费的方式。

根据选择的DeepSeek模型,选择相应的算力规格,点击启动服务。

根据选择的DeepSeek模型,选择相应的算力规格,点击启动服务。

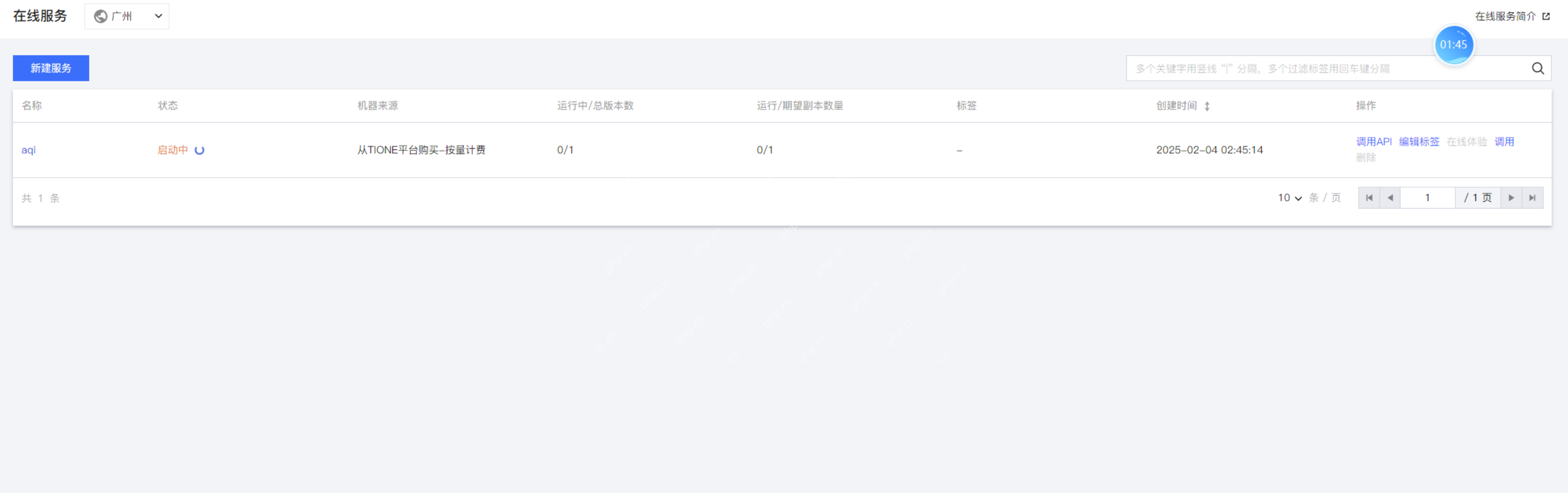

- 启动服务启动后,进入在线服务列表。

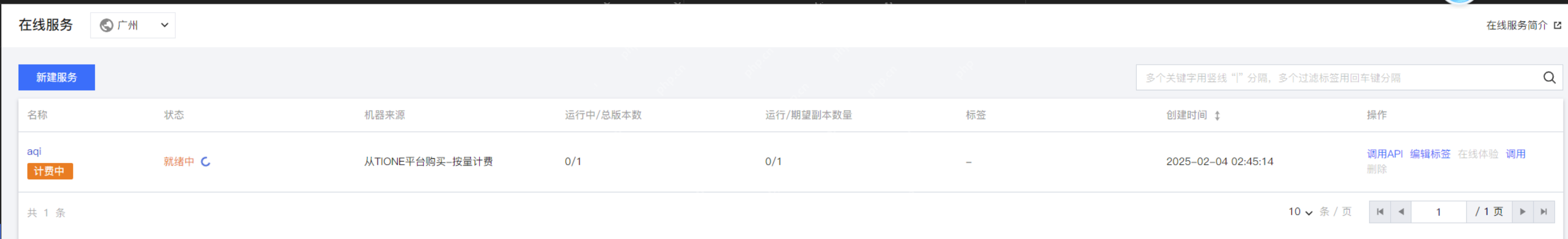

等待服务就绪后,点击服务查看详情。

等待服务就绪后,点击服务查看详情。

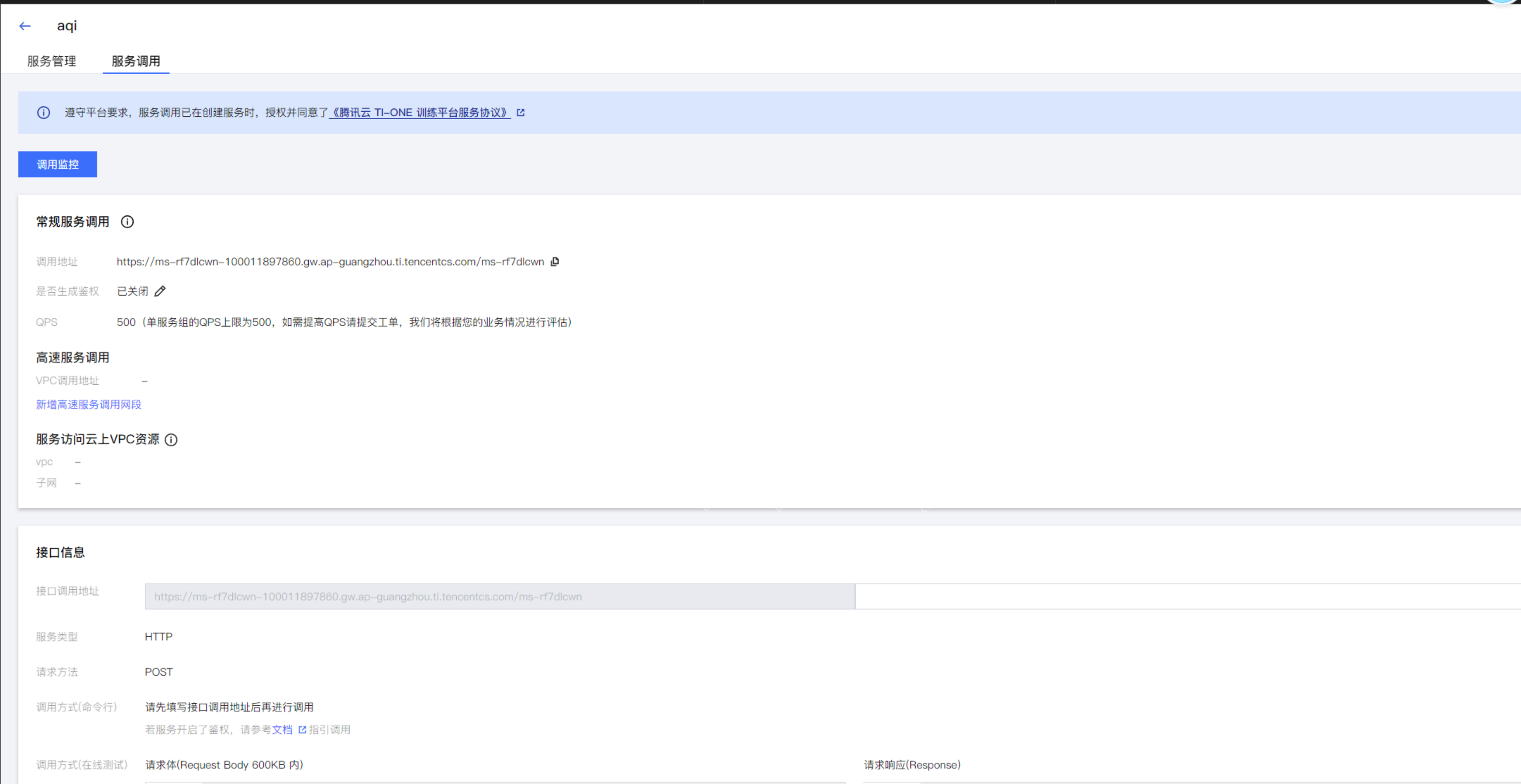

点击调用API,可以查看DeepSeek的服务调用地址。

点击调用API,可以查看DeepSeek的服务调用地址。

同时点击实例进入详情页面,可以看到安装了DeepSeek大模型实例的信息。

同时点击实例进入详情页面,可以看到安装了DeepSeek大模型实例的信息。

至此,我们完成了DeepSeek在PHP中文网TI平台的部署。

至此,我们完成了DeepSeek在PHP中文网TI平台的部署。

结语通过PHP中文网的TI平台,我们无需自己部署DeepSeek大模型运行环境,也无需购买服务器,通过资源打包和按量计费的方式,通过简单的界面化配置,即可完成DeepSeek的部署。