欢迎大家收看《rwkv 社区最新动态》,本期内容收录了 rwkv 社区 2025 年 8 月的最新动态。

只需 3 分钟,快速了解 RWKV 社区 8 月都有哪些新鲜事!

8 月动态省流版(TL;DR)

-

RWKV 模型新闻动态

- RWKV-7s 0.1B 发布

- RWKV7-G0 13.3B 正在训练

-

RWKV 学术研究动态

- 新论文:Monthly Service Prediction for 4G/5G Systems: A Short Time Series Based Neural Network Solution(基于 RWKV 的时序预测,发表于中科院 1 区 TOP 期刊 IEEE TCCN)

- 新论文:REB-former: RWKV-enhanced E-branchformer for Speech Recognition(基于 RWKV 增强的自动语音识别模型,发表于 Interspeech 2025)

- 新论文:A Multimodal Bone Stick Matching Approach Based on Large-Scale Pre-Trained Models and Dynamic Cross-Modal Feature Fusion(基于 RWKV 的多模态骨签匹配,发表于 Applied Sciences)

- 新论文:MSFF-RWKV : Single-Structure Multi-stage Feature Fusion Lightweight Super-Resolution Network(基于 RWKV 的图像超分辨率,已入选 ICIC 2025)

- 新论文:Smooth Reading: Bridging the Gap of Recurrent LLM to Self-Attention LLM on Long-Context Tasks(基于 RWKV 的推理优化)

- PointDGRWKV: Generalizing RWKV-like Architecture to Unseen Domains for Point Cloud Classification(基于 RWKV 的点云域泛化框架)

-

RWKV 社区市场活动

- RWKV 团队参加全球互联网大会

RWKV 模型新闻动态

RWKV-7s 0.1B 发布

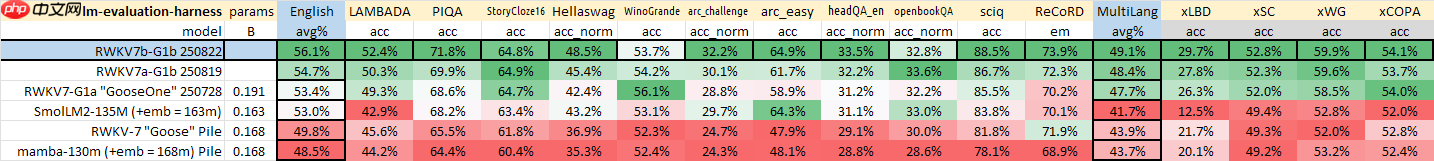

RWKV-7s 0.1B 模型开源发布,其中 RWKV7a-G1b 0.1B 于 8 月 19 日完成训练并开源发布,RWKV7b-G1b 0.1B 于 8 月 22 日完成训练并开源发布。两个模型较原生的 RWKV7-G1a 0.1B 均有合理提升。

经测试,RWKV7+DE 稀疏模型,在端侧的推理速度与 RWKV7 相同,实现了不占内存不减速度的免费性能提升。

| 模型 | 模型构成 | 总参数 (M) | 激活参数 (M) | 每 Token 读取数值量 |

|---|---|---|---|---|

| RWKV7-G1 0.1B | RWKV-7 | 191.03 | 140.70 | 768 |

| RWKV7a-G1b 0.1B | RWKV-7 + DE | 997.85 | 142.23 | 13,056 |

| RWKV7b-G1b 0.1B | RWKV-7 + DE + DEA | 1,806.75 | 145.83 | 25,344 |

推理代码:

https://github.com/BlinkDL/RWKV-LM/blob/main/RWKV-v7/rwkv_v7a_demo.py

https://github.com/BlinkDL/RWKV-LM/blob/main/RWKV-v7/rwkv_v7b_demo.py

可以与 RWKV7 代码做 diff 对比:

https://github.com/BlinkDL/RWKV-LM/blob/main/RWKV-v7/rwkv_v7_demo_fast.py

RWKV7-G0 13.3B 正在训练

2025 年 8 月 26 日,RWKV7-G0 13.3B 模型训练进度已达 33%。在仅完成三分之一训练的情况下,该模型在 MMLU 测试已取得 63.21% 成绩,相较于 RWKV-6 14.1B 的 55.38% 提升近 8 个百分点。

| 模型版本 | 参数量 | 训练进度 | MMLU 分数 (%) |

|---|---|---|---|

| v6 | 14.1B | 100% | 55.38 |

| v7 | 13.3B | 20% | 58.57 |

| v7 | 13.3B | 27% | 60.18 |

| v7 | 13.3B | 33% | 63.21 |

目前 RWKV-7 已发布 0.1/0.4/1.5/2.9/7.2B 支持全球所有 100+ 种语言的带推理基底模型,且 13.3B 正在训练,即将陆续发布。

RWKV 学术研究动态

RWKV 学术研究包括基于 RWKV 架构的新论文或 RWKV 社区参加的学术研究。

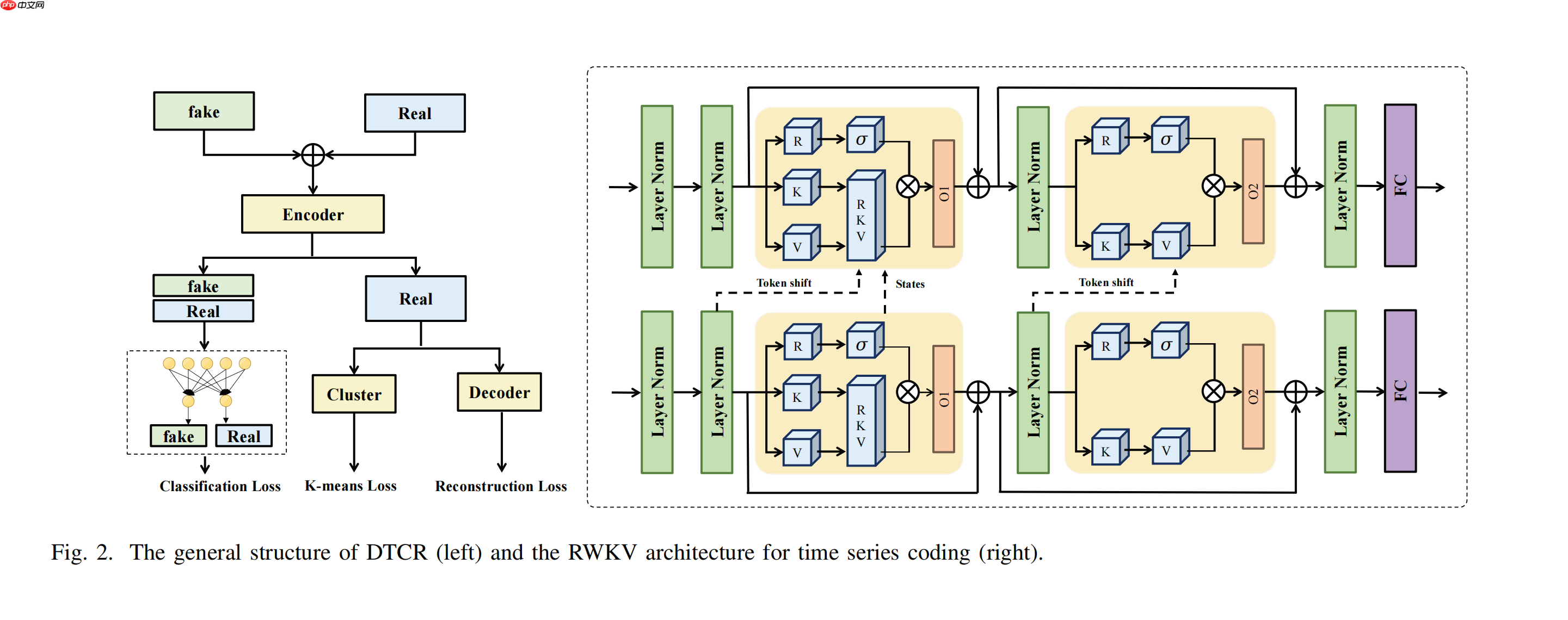

Monthly Service Prediction for 4G/5G Systems

- 论文名称:Monthly Service Prediction for 4G/5G Systems: A Short Time Series Based Neural Network Solution

- 论文链接:https://ieeexplore.ieee.org/abstract/document/11104274

- 发布日期:2025-07-30

本文基于 RWKV 模型开发了一个短时间序列预测框架,包括深度时间聚类表示(DTCR)和递减时间差网络(DTD-Net)。DTCR 使用 RWKV 编码器聚类数据以提升内部逻辑,DTD-Net 通过裁剪月度特征块减少注意力操作防止过拟合。实验在中国移动服务数据上验证了框架的有效性,平均 MAPE 为 0.126 和 0.120。

该论文的模型十分高效,已发表于中科院 1 区 TOP 期刊 IEEE TCCN。

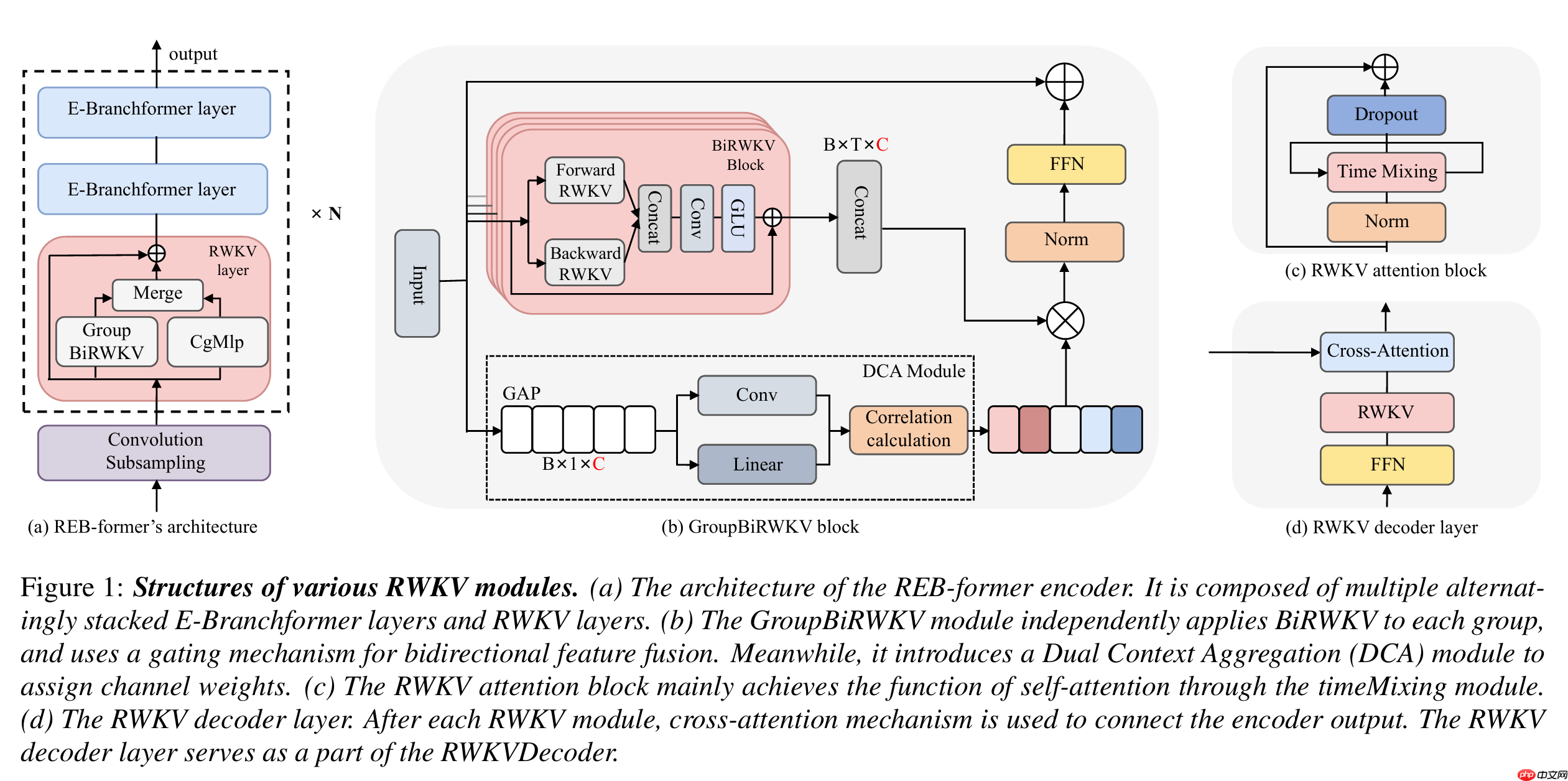

REB-former

- 论文名称:REB-former: RWKV-enhanced E-branchformer for Speech Recognition

- 论文链接:https://www.isca-archive.org/interspeech_2025/song25b_interspeech.html

- 发布日期:2025-08-17

本文提出了 REB-former,一种基于 RWKV 增强的 E-Branchformer 模型,用于自动语音识别 (ASR)。该模型交错结合了 E-Branchformer 和 RWKV 层,并引入 GroupBiRWKV 模块克服 RWKV 的单向性,旨在降低计算复杂度并提升语音建模能力。REB-former 在 LibriSpeech 100h 数据集上实现了先进的性能,显著降低了词错误率。

论文的模型十分有效,已发表于音频领域重要会议 Interspeech 2025。

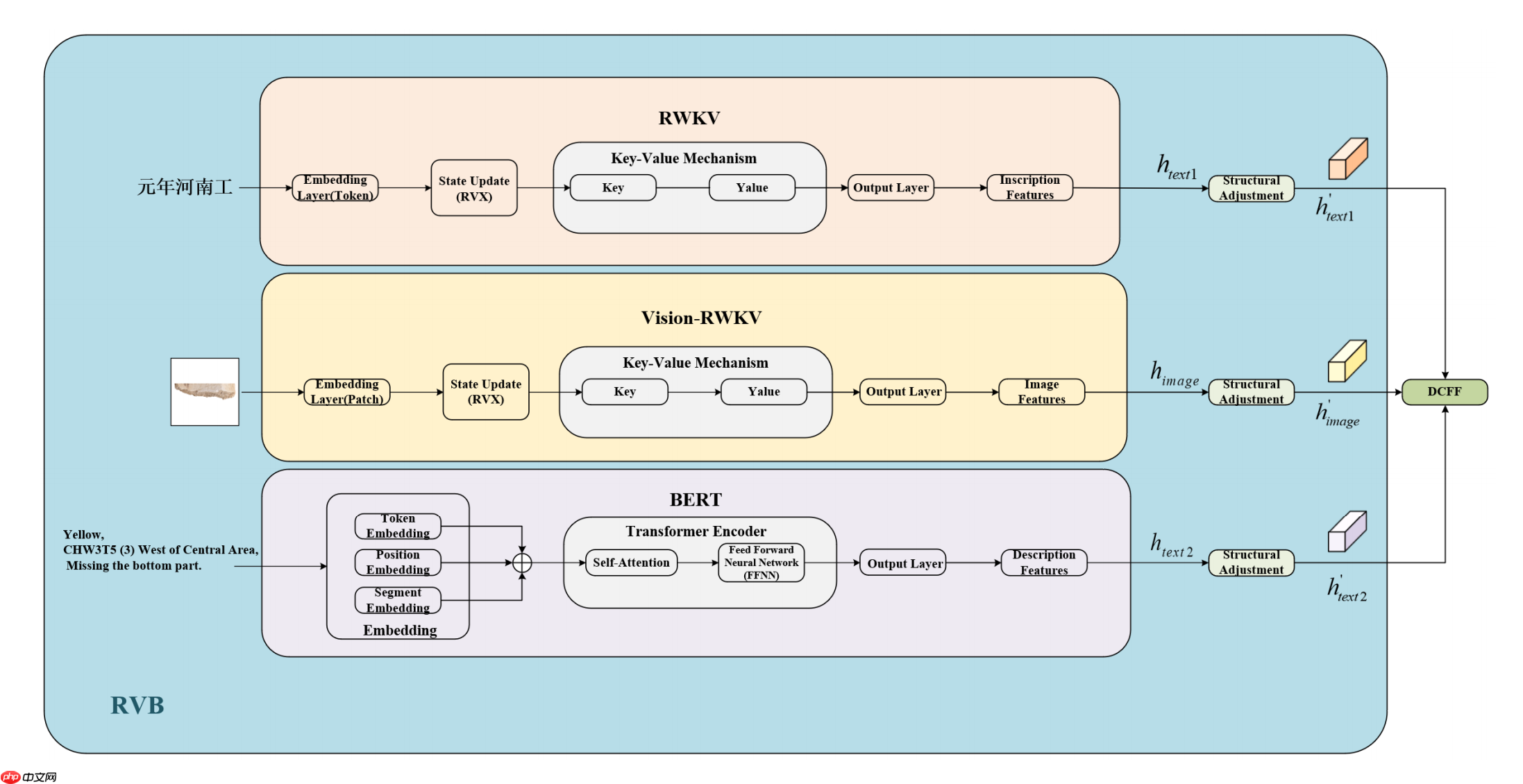

A Multimodal Bone Stick Matching Approach

- 论文名称:A Multimodal Bone Stick Matching Approach Based on Large-Scale Pre-Trained Models and Dynamic Cross-Modal Feature Fusion

- 论文链接:https://www.mdpi.com/2076-3417/15/15/8681

- 发布日期:2025-08-05

本文基于 RWKV 模型及其变体,提出了一种多模态骨签匹配方法。该方法利用 Vision-RWKV 提取视觉特征、RWKV 分析铭文、BERT 编码考古元数据,并通过动态跨模态特征融合机制整合信息。实验表明,该方法在骨签碎片匹配中达到94.73%的准确率,显著优于传统方法。

该论文的方法非常新颖有效,已发表于 JCR Q2 分区的 Applied Sciences。

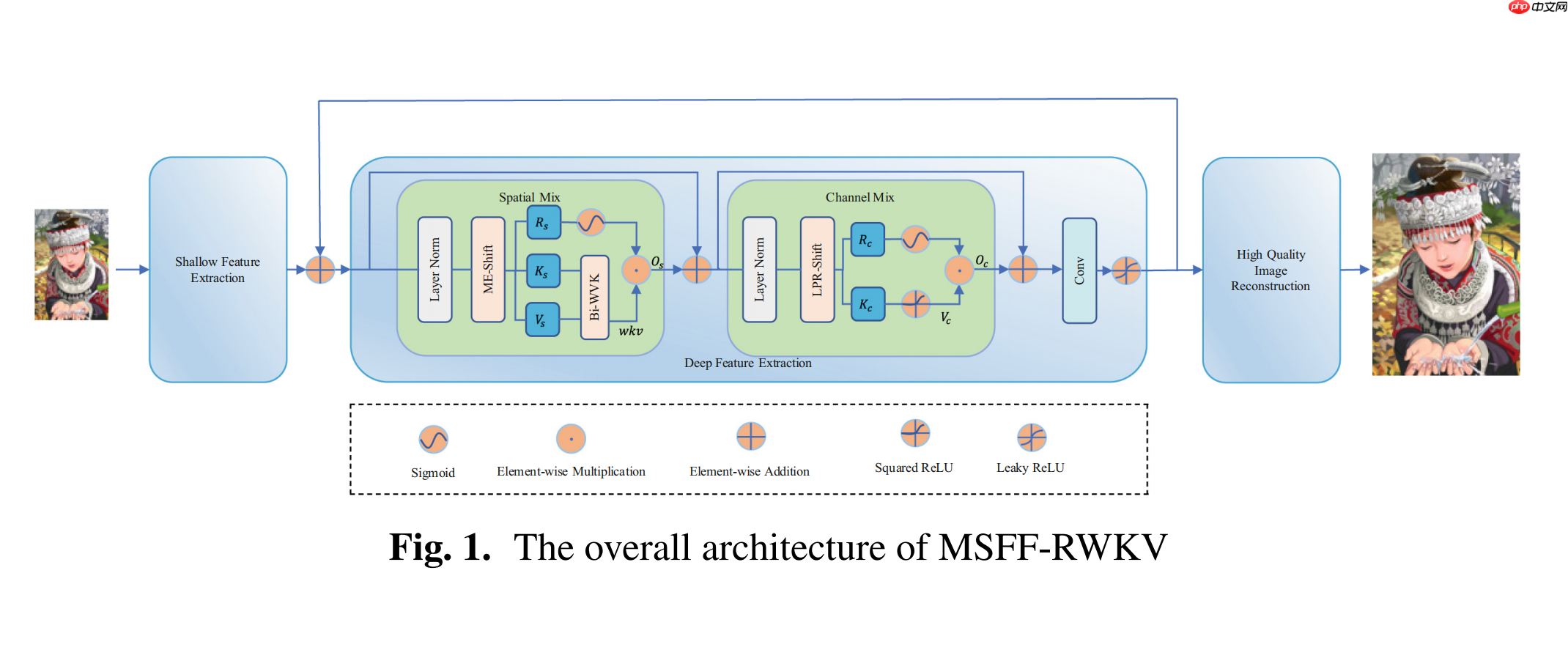

MSFF-RWKV

- 论文名称:MSFF-RWKV : Single-Structure Multi-stage Feature Fusion Lightweight Super-Resolution Network

- 论文链接:https://link.springer.com/chapter/10.1007/978-981-96-9949-0_35

- 发布日期:2025-07-15

本文基于 RWKV 模型提出了一种轻量级图像超分辨率网络 MSFF-RWKV。通过单块多阶段特征融合策略,结合 LPP-Shift 和 ME-Shift 模块,显著减少了参数和计算复杂度,同时提升了图像重建质量。实验表明,该模型在 PSNR 和 SSIM 指标上优于现有方法,参数减少 26.6%。

该论文的模型非常优秀,已收录于 ICIC 2025。

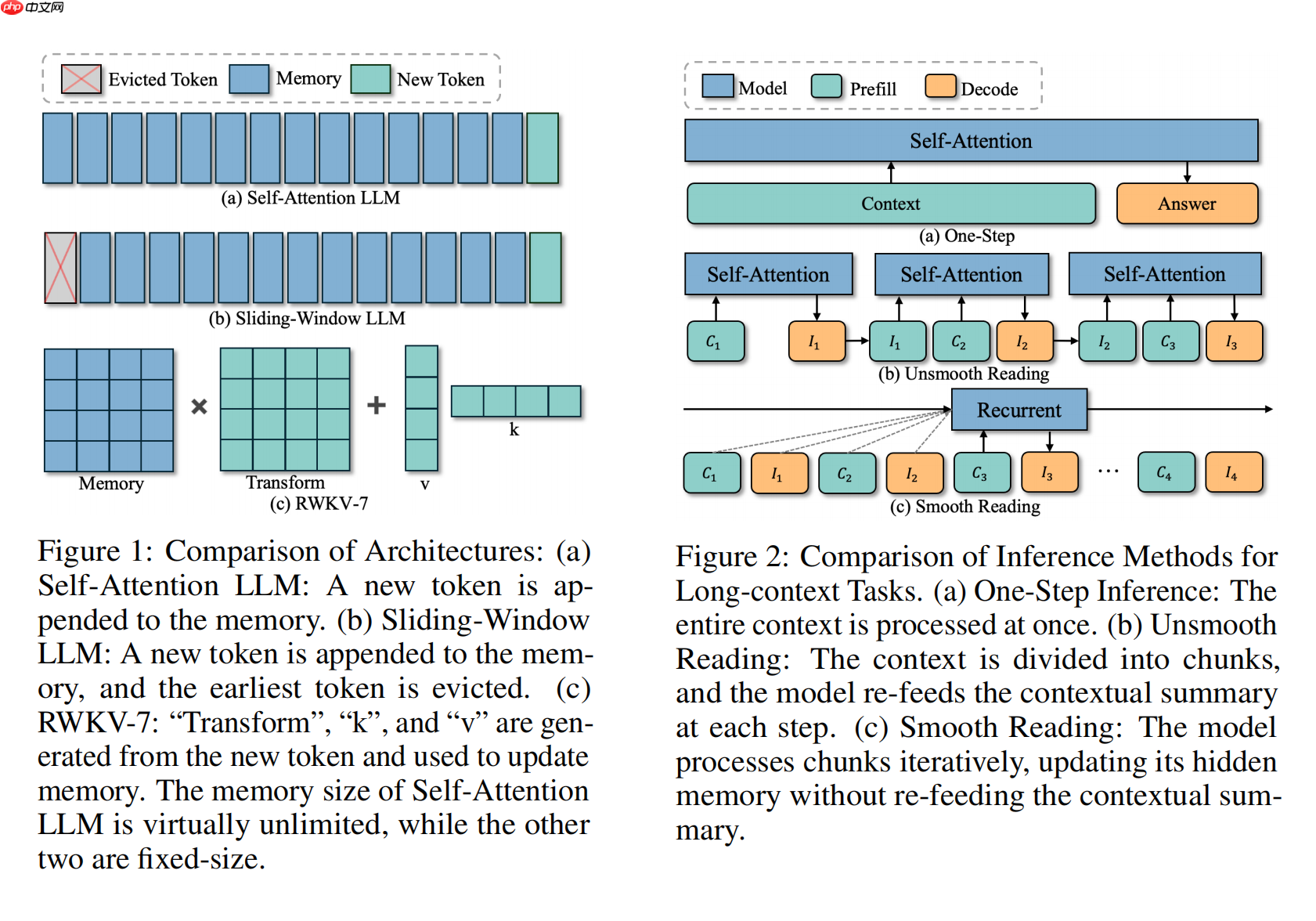

Smooth Reading

- 论文名称:Smooth Reading: Bridging the Gap of Recurrent LLM to Self-Attention LLM on Long-Context Tasks

- 论文链接:https://arxiv.org/abs/2507.19353

- 发布日期:2025-07-25

本文基于 RWKV 模型提出 Smooth Reading 方法,这是一种分块推理策略,灵感来源于人类阅读方式。该方法将长上下文分成小块处理,迭代总结信息以减少内存需求,优化循环模型性能。实验显示,该方法在 LongBench 上提升性能高达 3.61%,并保持高效训练和推理速度,显著缩小与自注意力模型的差距。

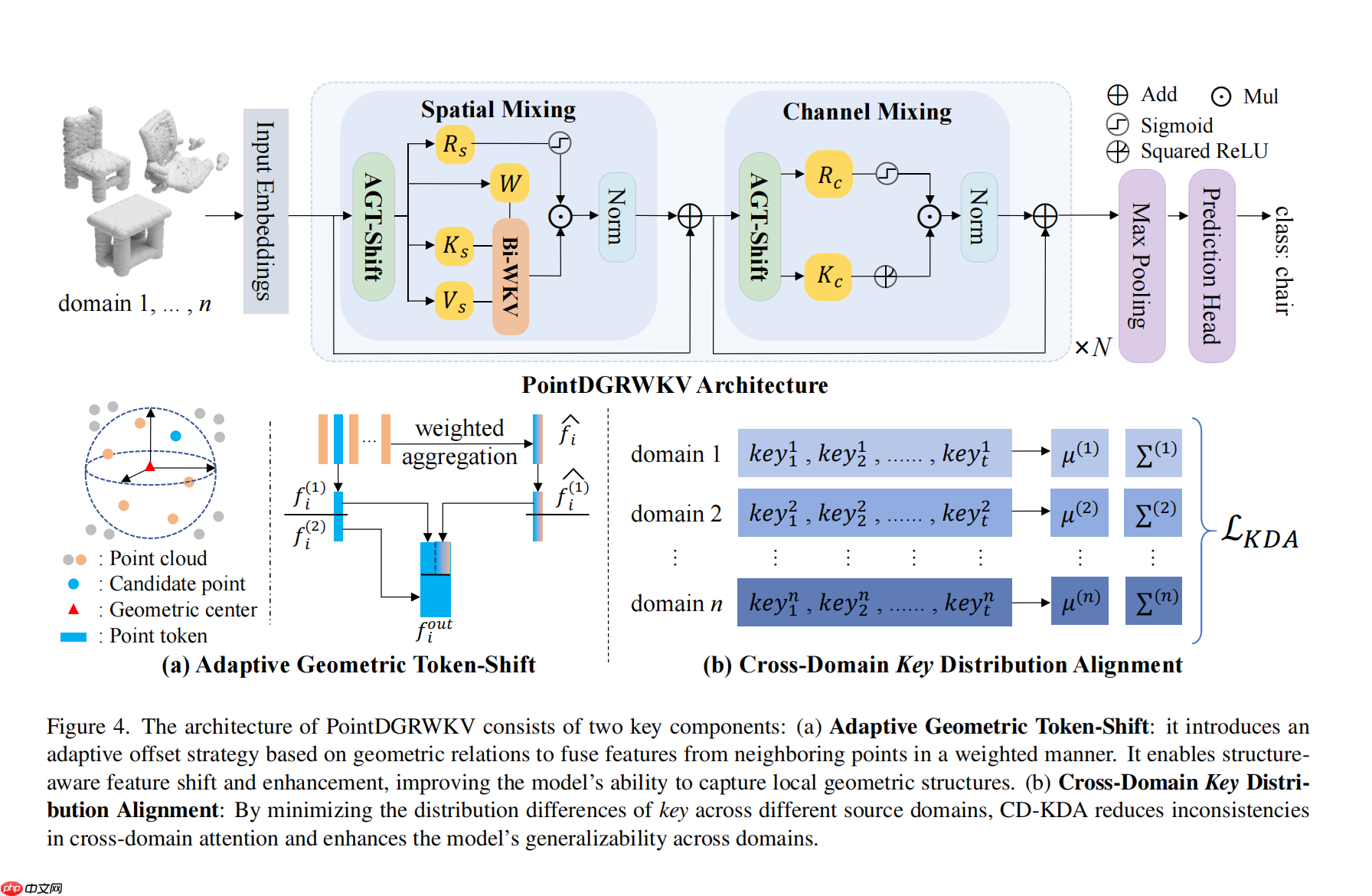

PointDGRWKV

- 论文名称:PointDGRWKV: Generalizing RWKV-like Architecture to Unseen Domains for Point Cloud Classification

- 论文链接:https://arxiv.org/abs/2508.20835

- 发布日期:2025-08-28

本文介绍了 PointDGRWKV,首个针对点云分类域泛化 (DG PCC) 的 RWKV-based 框架。它解决了 RWKV 直接应用于点云时,固定方向 Token Shift 导致的几何扭曲和 Bi-WKV 注意力机制易受跨域差异影响的问题。PointDGRWKV 提出了自适应几何 Token Shift (AGT-Shift) 和跨域 Key 特征分布对齐 (CD-KDA) 模块,以增强局部几何建模和跨域鲁棒性,同时保持 RWKV 的线性效率,并在 DG PCC 基准上实现了先进性能。

社区市场活动

RWKV 团队参加全球互联网大会

2025 年 8 月 14 日,RWKV 团队参加全球互联网大会,详细介绍了 RWKV 模型最新进展。

加入 RWKV 社区

欢迎大家加入 RWKV 社区,可以从 RWKV 中文官网了解 RWKV 模型,也可以加入 RWKV 论坛、QQ 频道和 QQ 群聊,一起探讨 RWKV 模型。

- ? RWKV 中文文档:https://www.rwkv.cn

- ? RWKV 论坛:https://community.rwkv.cn/

- ? QQ 频道:https://pd.qq.com/s/9n21eravc

- ? BiliBili 视频教程:https://space.bilibili.com/3546689096910933

源码地址:点击下载