Meta 超级智能实验室(Meta Superintelligence Labs,MSL)近日发布了其成立以来的首篇关键性研究论文,成功实现大语言模型在检索增强生成(RAG)任务中推理速度的飞跃式提升,提速超过30倍。

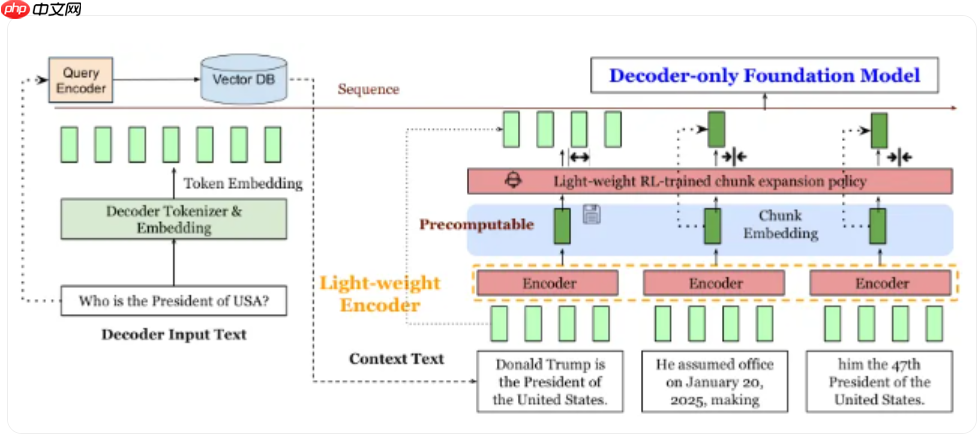

该论文题为《REFRAG: Rethinking RAG based Decoding》,重点研究如何让大型语言模型在处理 RAG 任务时更高效地提取关键信息,从而大幅降低计算开销与响应延迟,同时确保输出结果的准确率不受影响。

Meta 超级智能实验室成立于今年6月,坐落于加利福尼亚州门洛帕克,致力于推动超级智能技术的发展。据悉,扎克伯格在今年4月对 Meta 推出的 Llama4 模型表现感到不满,曾要求团队加班优化性能,这也成为他组建该实验室的重要动因。此后,Meta 迅速集结了一批顶尖人才,其中包括 Scale AI 创始人 Alexandr Wang。

实验室目前设有四大核心团队,分别专注于大语言模型开发、人工智能基础理论研究、产品化落地应用以及底层基础设施建设。此次提出的 REFRAG 框架,正是该实验室在提升模型效率方向上的首个重要成果。

REFRAG 的核心技术在于引入一个轻量级模型,用于将冗长的上下文内容自动提炼为简洁摘要,从而显著减少主解码器需要处理的信息量。这一策略不仅加快了推理速度,也有效降低了资源消耗。此外,研究团队还采用了“持续预训练”机制,通过设计信息重建任务来训练模型,在压缩上下文的同时尽可能保留关键语义细节。

实验证明,REFRAG 在多项基准测试中均表现出卓越性能,尤其在响应延迟和系统吞吐量方面实现了显著优化。数据显示,在上下文压缩比达到16倍的情况下,REFRAG 不仅超越了此前最先进的 CEPE 模型,而且在准确性上几乎无损,展现出极强的实用性与扩展潜力。

以上就是Meta 超级智能实验室推出新技术,使大模型 RAG 推理速度提升 30 倍的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号