蚂蚁百灵大模型团队正式推出万亿级思考模型 ring-1t,发布即全面开源。开发者可通过 hugging face、魔搭社区(modelscope)下载模型权重,也可通过 ling chat 页面或 zenmux 平台直接体验对话功能并调用 api。

Hugging Face:https://www.php.cn/link/4ecca9950b8e48cca47014655c2c4789 ModelScope:https://www.php.cn/link/886551d6661c7e64f03ecdc16f7eae8b Ling Chat(国内用户):https://www.php.cn/link/c96742836bff214c3bb498c11c10ea4d ZenMux(海外开发者,支持Chat/API):https://www.php.cn/link/14c15aaec95f9b40f00007e6336d3e08

Ring-1T 基于 Ling 2.0 架构打造,拥有总计 1 万亿参数,激活参数为 500 亿,并支持长达 128K 的上下文窗口。模型权重已同步上线 Hugging Face 与 ModelScope 平台,并提供 FP8 精度版本以提升推理效率。

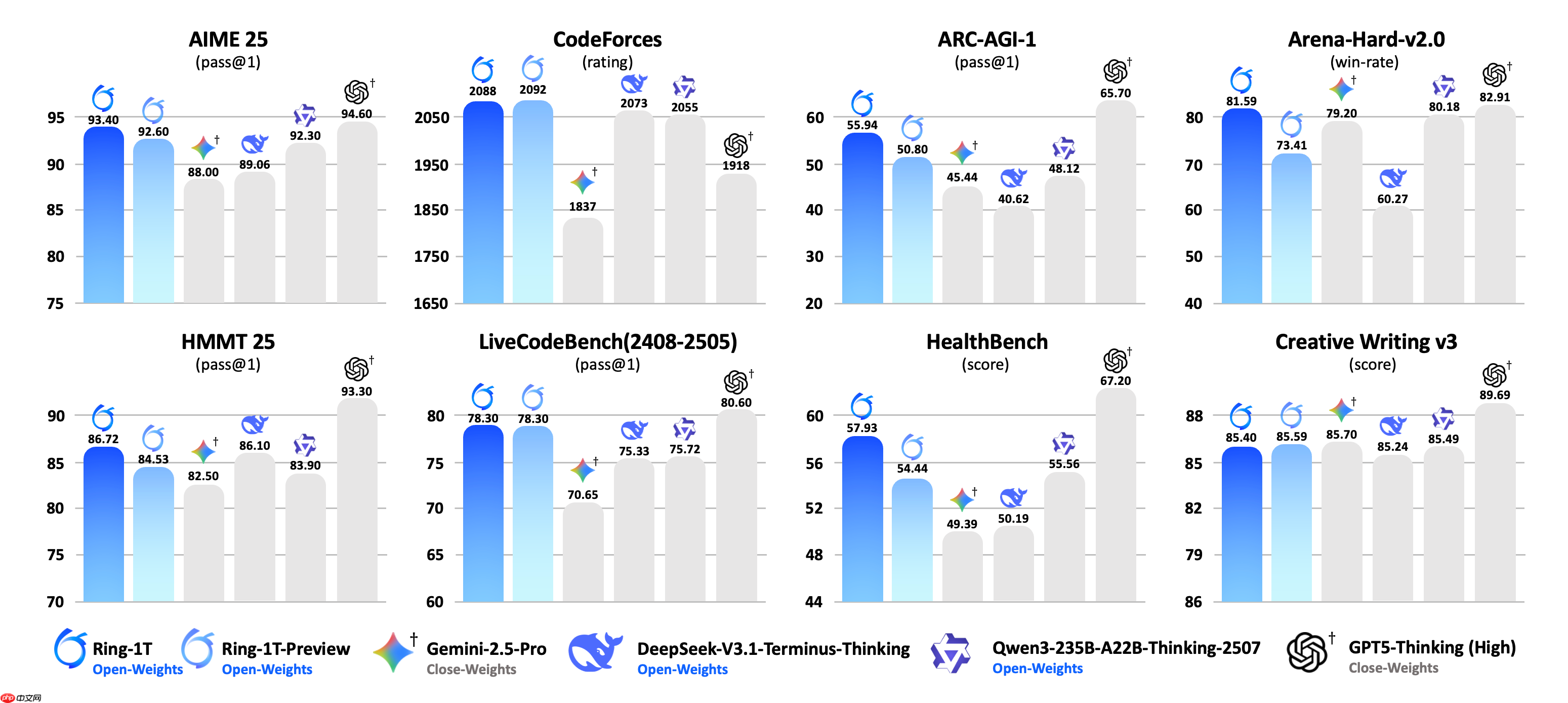

此次发布的正式版在上月底推出的 preview 版本基础上,进一步扩展了大规模可验证奖励强化学习(RLVR)的训练规模,充分释放万亿参数基座模型在自然语言推理方面的潜力。同时,通过 RLHF 技术优化模型的通用能力,使 Ring-1T 在各类任务中的表现更加均衡和稳定。

Ring-1T 沿用 Ling 2.0 架构,在具备 1 万亿总参数、500 亿激活参数的 Ling-1T-base 基础模型之上进行训练,最大支持 128K 上下文长度。依托自研的强化学习稳定训练方法 icepop(“棒冰”),以及高效强化学习系统 ASystem(其核心框架 AReaL 已开源),团队成功实现了 MoE 架构下从百亿参数(Ring-mini-2.0)、千亿参数(Ring-flash-2.0)到万亿参数(Ring-1T)的平稳扩展,显著增强了模型的深度推理与复杂语言理解能力。

相关阅读:蚂蚁百灵大模型团队发布 Ling-1T:万亿参数“非思考”模型、基于 MoE 架构

以上就是蚂蚁百灵大模型团队正式发布并开源万亿思考模型 Ring-1T的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号