10月14日凌晨,蚂蚁集团正式发布了具备万亿参数的思考型模型ring-1t,并全面开放其模型权重与训练方法的源代码。该模型在9月30日发布的预览版本ring-1t-preview基础上,进一步深化了大规模可验证奖励强化学习(rlvr)的训练过程,充分释放了万亿级基座模型在自然语言推理方面的潜力,同时通过rlhf技术优化模型的通用性能,在多项评测任务中展现出更加均衡且强劲的表现。

为持续提升复杂推理能力,尤其是数学领域的表现,百灵团队将Ring-1T接入多智能体协同推理框架AWorld,挑战极具难度的IMO2025国际数学奥林匹克试题,并全程使用纯自然语言进行解题。实验结果令人瞩目:Ring-1T首次尝试即成功解答第1、3、4、5题,达到IMO银牌水平,成为全球首个能够获得国际奥数奖项级别的开源系统。在第三次尝试中,对第2题的几何证明给出了接近满分的严谨推导;而在几乎所有顶级大模型均未能突破的第六难题上,Ring-1T的答案收敛至“4048”——虽未完全正确(标准答案为2112),但已与Gemini 2.5 Pro的结果一致,展现出强大的推理逼近能力。

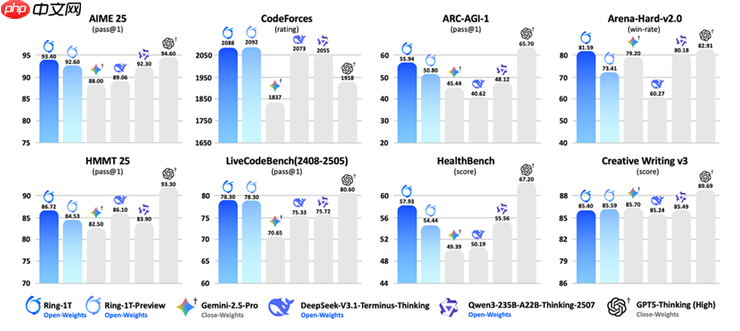

作为一款专注于深度思考的模型,Ring-1T在通用能力方面同样表现出色。在“人类偏好对齐”测试Arena-Hard V2中,其以81.59%的成功率位居开源模型榜首,成绩紧追GPT-5-Thinking(High)的82.91%。在专业领域测评HealthBench中,Ring-1T亦斩获开源模型最高分,彰显其在医疗问答等高严谨性场景下的卓越表现。

(Ring-1T与业界代表性思考模型的性能横评)

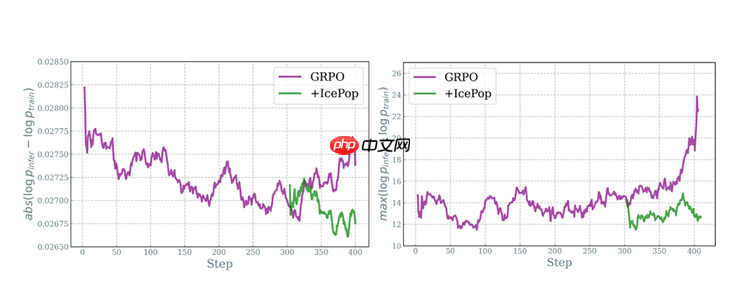

训练万亿参数模型面临的核心挑战之一是训推精度不一致问题——即训练和推理阶段因实现差异导致分布偏移,进而引发训练崩溃。为此,蚂蚁自主研发了名为“棒冰(icepop)”的创新算法,采用带掩码的双向截断技术,将训练与推理之间的分布差异冻结在低水位状态,有效保障长序列、长周期训练的稳定性。此外,针对万亿参数模型在强化学习训练中的显存管理与权重交换瓶颈,蚂蚁打造了高性能强化学习系统ASystem(含已开源的AReaL框架),实现了单机显存碎片秒级回收、权重零冗余传输,使大规模RL训练得以稳定常态化运行。

(图左:GRPO训推差异随训练指数增长,icepop保持平稳;图右:训推差异峰值对比,GRPO显著上升,icepop维持低位)

本次发布的Ring-1T基于Ling 2.0架构的1T base模型进行后续训练。Ling 2.0采用了高度稀疏化的MoE结构、1/32专家激活比、FP8混合精度计算以及MTP等多项先进技术,兼顾高效训练与推理效率。在后训练阶段,百灵团队实施了LongCoT-SFT + RLVR + RLHF的多阶段联合训练策略,显著增强了模型在复杂逻辑推理、指令遵循及创意写作等方面的综合能力。

据百灵团队透露,Ring-1T是其在万亿参数思考模型方向上的首次探索,未来将持续迭代优化,推出更强大的版本。目前,用户可通过HuggingFace、魔搭社区等平台下载模型权重,并通过蚂蚁百宝箱等渠道在线体验其能力。

截至目前,蚂蚁百灵系列已累计发布18款大模型,构建起覆盖从160亿到1万亿参数的完整产品矩阵,其中包括两款标志性万亿参数模型:通用大语言模型Ling-1T与思考型模型Ring-1T。随着这两大模型的相继落地,百灵大模型正式迈入2.0时代。

以上就是蚂蚁发布并开源万亿参数思考模型Ring-1T,综合能力逼近GPT-5的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号