头图来源:智源研究院

10 月 30 日,智源研究院正式发布了 " 悟界 EMU3.5" 多模态世界大模型。

在当前大语言模型(LLM)的文本能力逐渐触顶、行业普遍寻求新突破口的背景下,多模态被视为人工智能的下一个重要方向。

然而,如何有效融合文本、图像、视频等不同模态的数据,一直是业界面临的难题。

长期以来,多模态领域存在两种不同的技术路径:一种是 DiT(Diffusion Transformer)架构,在文生图、文生视频等生成任务上表现出色;另一种则是以智源 Emu 系列为代表的 " 原生多模态 " 架构,尝试从一开始就用统一的模型处理一切。

智源研究院院长王仲远在发布会上表示,EMU3.5 的发布,标志着人工智能从 " 语言学习 " 向 " 多模态世界学习 " 演进的新纪元,并率先指明了多模态 Scaling(规模化)的新范式。

从一年前验证技术路线的 Emu3,到今天宣称 " 开启新纪元 " 的 EMU3.5,智源究竟解决了什么关键问题?这背后又体现了怎样的技术思路?

一、 补齐核心短板:从 " 统一 " 到 " 高效 "

多模态 AI 的核心挑战之一,是如何建立一个 " 大一统 " 的模型。

行业中常见的做法,是将不同功能的模型(如一个理解模型、一个生成模型)拼接起来。但这会带来融合的挑战,不同架构间的 " 语言 " 并不相通。

智源从 Emu3 开始,就选择了一条更彻底、也更难的 " 原生多模态 " 路线:使用统一的自回归(Autoregressive)架构。

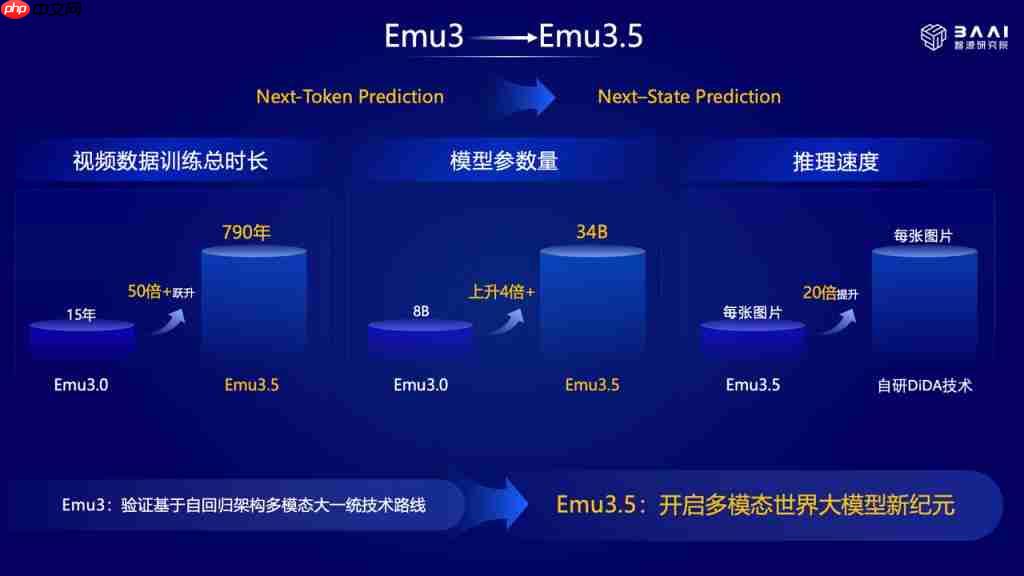

图片来源:智源

自回归架构是目前大语言模型的基石,其范式是 "Next-Token Prediction"。智源将其推广到了多模态领域,无论是文本、图像还是视频,都被打散成 Token,由模型统一预测。这样做的好处是理论上极其简洁优雅,实现了 " 图像、文本、视频的大一统 "。

但这个选择在过去一年里也面临着一个致命的 " 原罪 ":推理效率太低。

当模型生成图像时,需要一个 Token 一个 Token 地 " 吐 " 出来,这个过程就像 " 像素点打印 ",相较于 Diffusion 等模型并行的生成方式,速度慢了几个数量级。

一个无法高效运行的模型,其 " 统一 " 的理论优势就很难在实践中落地。因此,效率问题,是 EMU3.5 必须攻克的第一座大山。MU3.5 团队提出了一项名为 "DiDA(离散扩散自适应)" 的创新技术,作为这个难题的解方。

DiDA 是一种高效的混合推理预测方法,它允许自回归模型在推理时,可以并行地预测和生成大规模的 Token。这从根本上改变了 " 一个点一个点画 " 的低效模式。

带来的提升是显著的:在不牺牲性能的前提下,每张图片的推理速度提升了近 20 倍。王仲远谈到,这使得 EMU3.5 的自回归架构," 首次使自回归模型的生成效率媲美顶尖的闭源扩散模型 "。

这个工程上的关键突破,补齐了原生多模态路线的核心短板。它证明了这条路不仅在理论上可行,在实践中也具备了 " 可用性 " 和 " 可竞争性 "。

解决了效率枷锁后,通往 " 规模化 " 的道路才真正被打开。

二、 开启 " 第三范式 ":当多模态遇上 Scaling Law

在人工智能领域,"Scaling Law"(规模定律)是过去几年最重要的发现之一。它指的是,只要持续增加模型参数、训练数据和算力投入,模型的性能就会相应地可预期地提升。大模型的成功,就是建立在这一 " 力大砖飞 " 的信仰之上。

但在多模态领域,这条路一直不甚明朗。由于技术路线不统一,行业并不确定多模态模型是否存在清晰的 Scaling Law。

EMU3.5 通过 DiDA 技术解决了效率问题后,智源迅速开始了规模化的验证。从 Emu3 到 EMU3.5 的变化清晰地体现了这一点:

模型参数: 从 8B(80 亿)跃升至 34B(340 亿),提升超过 4 倍;训练数据: 累计的视频数据训练时长,从 15 年猛增到 790 年,跃升超过 50 倍;性能也随之获得了显著提升。

基于这一实践,王仲远在发布会上提出了一个大胆的判断:EMU3.5 开启了继 " 语言预训练 " 和 " 后训练及推理 " 之后的 " 第三个 Scaling 范式 "。

为什么称其为 " 新范式 "?智源给出了三个理由:

架构的统一性: EMU 的自回归架构能够大一统地处理各种模态的数据,为规模化提供了简洁的基础。

设施的可复用性: 这一架构可以 " 大规模复用已有的计算基础设施 "。这意味着,所有为训练 LLM 而构建的昂贵智算集群,几乎都可以无缝迁移过来训练 EMU 模型,极大降低了 Scaling 的门槛。

强化学习的引入: EMU3.5 首次在多模态领域实现了大规模强化学习(RL)。强化学习(尤其是 RLHF)是激发 LLM 高级能力、使其 " 听话 " 的关键步骤。如今,智源将这套在语言上被验证过的成熟方案,成功地应用到了更复杂的多模态模型上。

"Scaling 范式 " 的意义在于 " 可预期 "。而 EMU3.5 的潜力才刚刚开始释放。王仲远在现场提到,目前 34B 的参数规模,相比 LLM 动辄万亿的规模还很小;而 790 年的视频数据量," 只占全互联网公开视频数据不到 1%"。

这意味着,无论是在模型参数还是在数据维度上,这条路都还有着巨大的提升空间。只要沿着这条路继续 " 力大砖飞 ",模型能力的上限远未到来。

三、 学习世界规则:从 " 预测 Token" 到 " 预测状态 "

如果说,解决效率问题和开启规模化,回答了 " 怎么做 " 的问题,那么 EMU3.5 的另一大转变,则是在回答 " 学什么 " 的问题。

智源团队在发布会上反复强调 " 第一性原理 "(First Principles)。王仲远举了一个观察两岁小女孩的例子:她通过刷短视频,观察视频里的人如何吃糖葫芦,然后在现实世界中模仿、尝试、失败、再尝试,最终自己学会了串糖葫芦。

他强调人类的学习,不是从文本开始的,而是从对这个世界、对物理规律的视觉观察开始的。

这也是 EMU3.5 试图模拟的核心理念:AI 不应只学习 " 语言 ",更应学习 " 世界 "。

为此,EMU3.5 提出了一个核心范式的升级:从 Emu3 的 "Next-Token Prediction"(预测下一个词元),升级为 "Next-State Prediction ( NSP ) "(预测下一个状态)。

这个转变意味着模型的目标,不再是机械地 " 续写 " 数据(比如预测下一个像素或下一个词),而是要理解事物背后的因果和规律,预测世界在逻辑上的 " 下一个状态 "。

基于此,智源也对 " 世界模型 " 这一概念提出了自己的定义。王仲远在采访中直言,不完全赞同 " 世界模型就是视频生成 " 的观点。他认为,世界模型的核心,是 " 对于整个世界因果关系、时空、物理建模的能力 "。

他用一个 " 桌边的咖啡 " 的例子来说明:

一个 " 视频生成模型 ",也许能预测出 " 杯子掉落、咖啡洒一地 " 的逼真画面。

但一个 " 世界模型 ",首先应该理解 " 这个杯子放得很危险(状态)",并预测 " 它很可能会掉落(状态变化)"。

更进一步,当接收到 " 拿起这杯咖啡 " 的指令时,这个模型会基于对物理常识(纸杯的力度、重心的位置)的理解,来规划 " 下一步的行动 "。

EMU3.5 展现出的许多能力,都在印证这种从 " 理解 " 到 " 行动 " 的进化:

Emu3.5 能以精准可控的方式完成文图生成|图片来源:智源

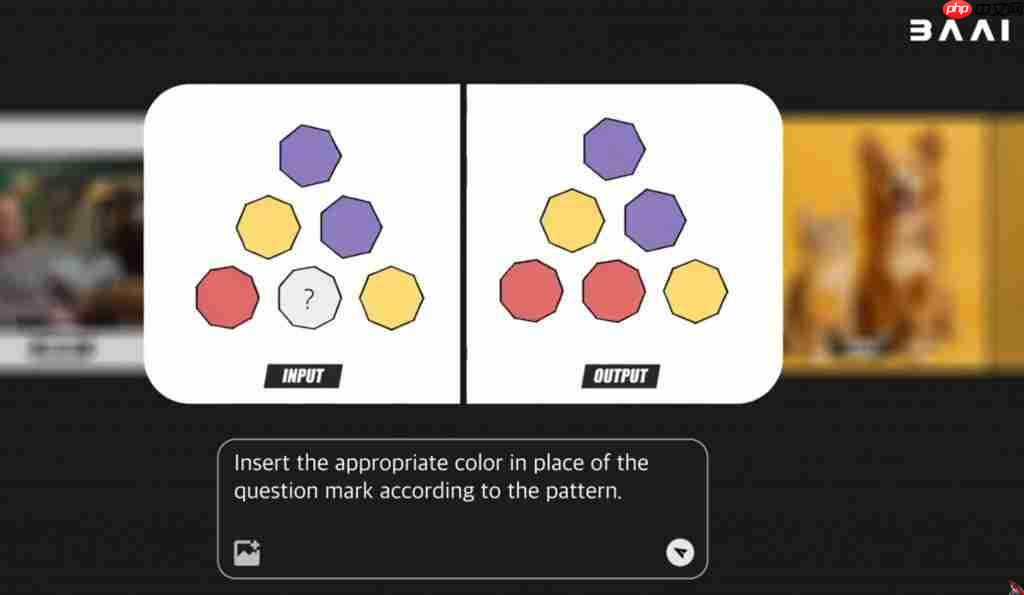

展现出基于视觉理解的图像生成能力图片来源:智源

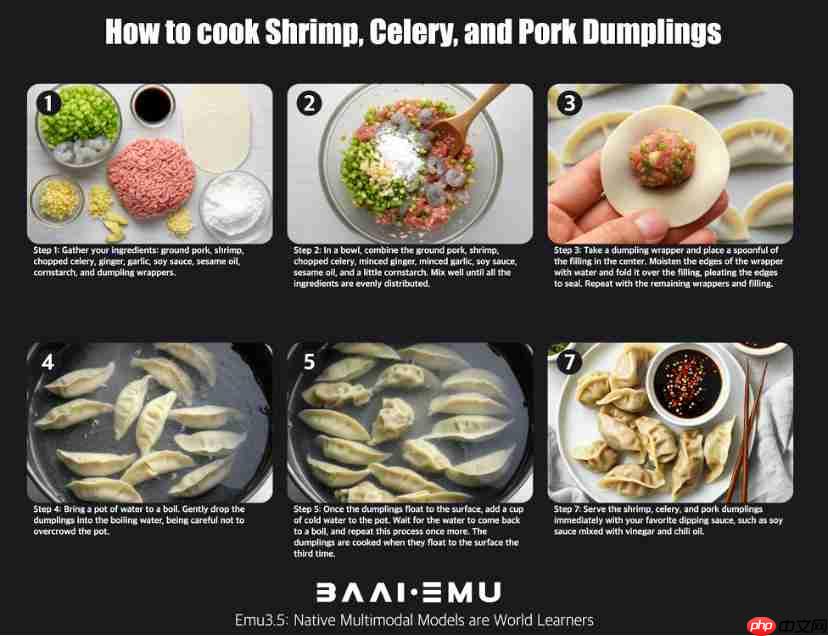

Emu3.5 的多模态指导能力:输入 " 如何做芹菜饺子 ",模型输出有步骤的图文指导图片来源:智源

意图规划: 当用户输入 " 如何做芹菜饺子 " 时,模型输出的不是零散的图片,而是一套图文并茂、步骤清晰的 " 行动指南 "。

动态模拟与推理: 在一个示例中,模型需要根据图案规律,在 "?" 处填上合适的颜色。这要求模型必须先 " 理解 " 图案的排布规则(一种逻辑状态),才能 " 生成 " 正确的红色方块(下一个状态)。

时空理解: 模型可以将一张建筑的正面图,根据指令转换为 " 俯视图 "。这背后是模型对物体三维空间关系的建模。

这种 " 预测下一个状态 " 的能力,最终指向了人工智能的终极应用之一:具身智能(机器人)。

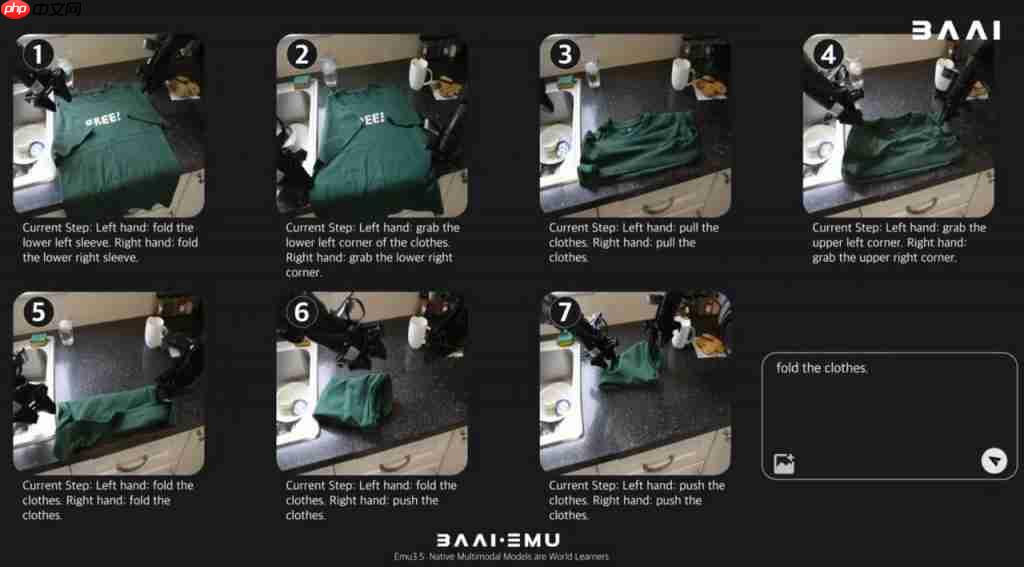

具身智能行业目前面临数据匮乏的瓶颈。而 EMU3.5 这样的世界模型,可以通过对物理世界的理解和模拟,为机器人生成海量、高质量、且多样化的 " 仿真训练数据 "。例如,在 " 叠衣服 " 的演示中,模型自主规划并生成了机器人完成复杂折叠动作的完整序列。

只需一句 " 叠衣服 " 的简单指令,Emu3.5 便能自主规划、拆解任务,并精确生成机器人完成一整套复杂的折叠动作|图片来源:智源

王鑫龙博士则在交流中提到,利用 EMU3.5 的世界模型能力,机器人在 " 没见过的场景 " 中执行任务,成功率可以 " 直接(从 0%)到 70%"。这表明,EMU3.5 正在扮演的,是具身智能 " 大脑 " 的角色,即提供理解、规划和泛化的核心智能。

EMU3.5 的发布,首先通过 DiDA 技术,解决了原生多模态自回归架构最致命的 " 效率 " 短板。以此为基础,它得以开启 " 多模态 Scaling" 的进程,通过堆叠数据和参数来提升能力,并验证了 " 第三种 Scaling 范式 " 的可能性。

而这种规模化的最终目标,是实现一个更宏大的愿景:从 " 预测 Token" 转向 " 预测状态 ",让 AI 真正学习这个世界的物理规律和因果关系,为最终实现能够理解并与物理世界交互的通用人工智能,提供了一条坚实的路径。

目前智源已将技术细节在技术报告里披露,并计划在未来开源模型,或许在多模态世界模型这条新赛道上,一个来自中国的 " 新范式 " 已经登场。

以上就是语言模型之后,智源 EMU3.5 找到了 AI 的「第三种 Scaling 范式」的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号