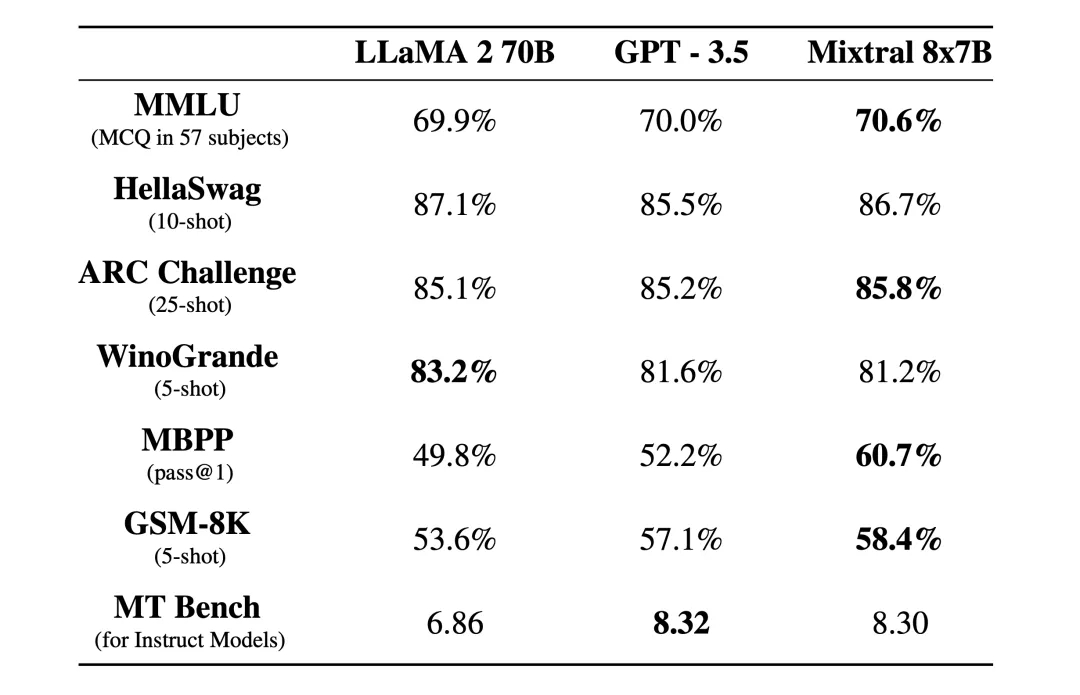

Mixtral 是一种具有开放权重的高质量稀疏专家混合模型 (SMoE)。根据 Apache 2.0 许可。Mixtral 在大多数基准测试中都优于 Llama 2 70B,推理速度提高了 6 倍。它是最强大的开放权重模型,具有宽松的许可证,也是成本/性能权衡方面的最佳模型。特别是,它在大多数标准基准测试中匹配或优于 GPT3.5。

## Use a pipeline as a high-level helperfrom transformers import pipelinedef test_mixtral():pipe = pipeline("text-generation", model="mistralai/Mixtral-8x7B-Instruct-v0.1")pipe("请为google编写web自动化测试用例,使用pytest page object设计模式,断言使用hamcrest")

def test_mixtral():llm = Ollama(model="mixtral", base_url="http://localhost:11434")r = llm.invoke('请为google编写web自动化测试用例,使用pytest page object设计模式,断言使用hamcrest')debug(r)

Mixtral 是一种具有开放权重的高质量稀疏专家混合模型。

Copyright 2014-2026 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号