系统要求:需要windows 10 或更高版本操作系统,硬盘空间应不少于5gb。

下载安装文件的百度网盘链接为:https://www.php.cn/link/3b20413fc76c5f432ede85b03e8af0a1。

从该链接可以下载到本文所需的Ollama安装包以及DeepSeek模型,这两部分文件都包含在压缩包“离线部署deepseek.rar”中。

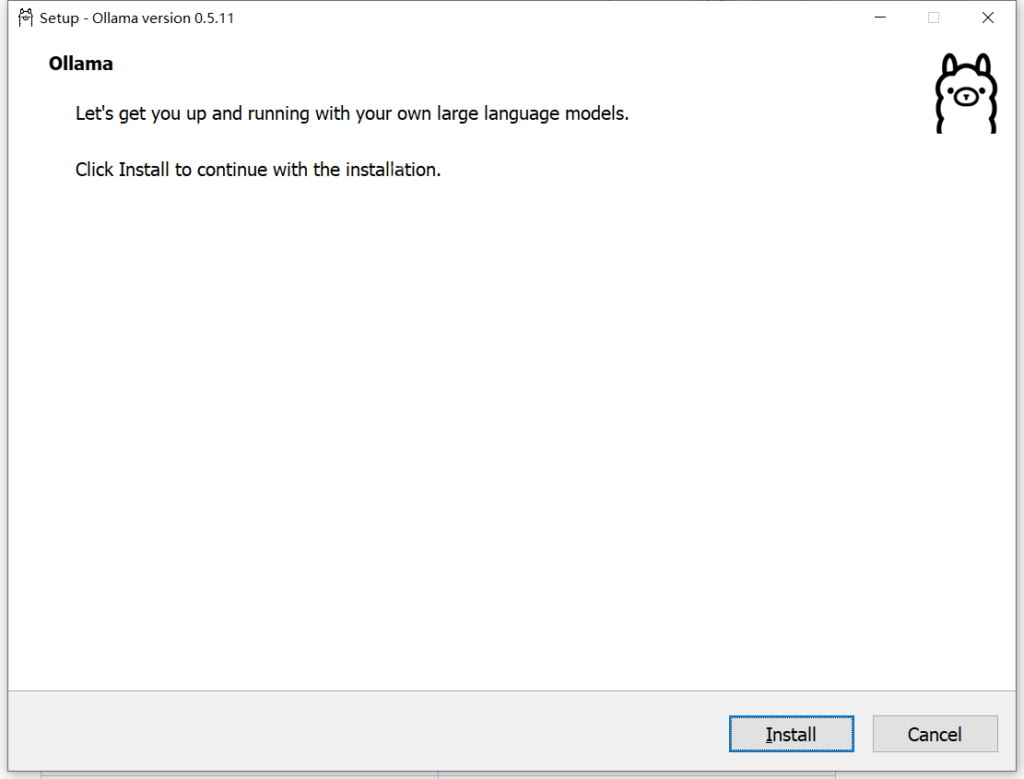

安装Ollama:双击Ollama安装包(OllamaSetup.exe),点击“Install”按钮开始安装。

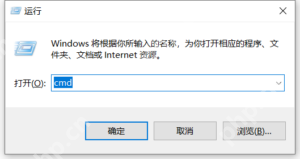

安装完成后,按下 Win + R 键,输入 cmd 并按回车键,启动命令行窗口。

安装完成后,按下 Win + R 键,输入 cmd 并按回车键,启动命令行窗口。

在命令行中输入 ollama,如果看到以下输出,表示Ollama已成功安装。

在命令行中输入 ollama,如果看到以下输出,表示Ollama已成功安装。

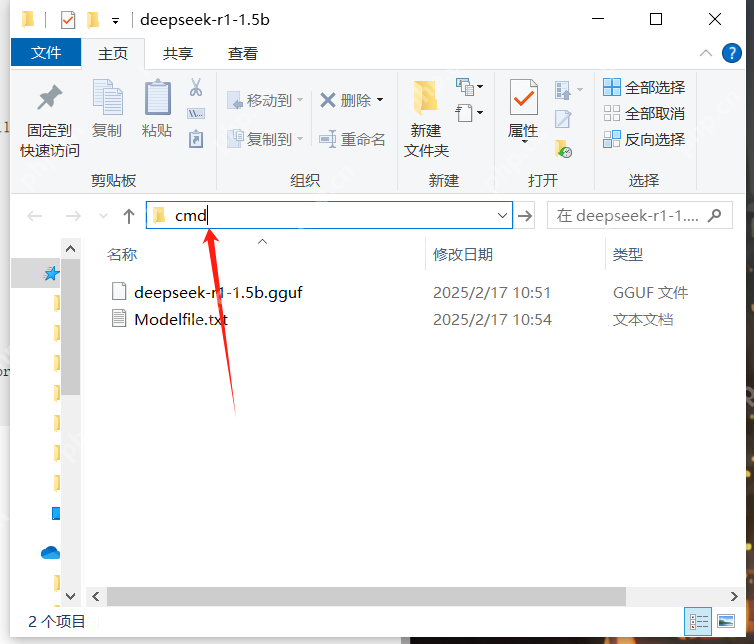

安装Deepseek R1 1.5b模型:1.下载并解压模型从百度网盘下载Deepseek R1 1.5b模型的压缩包(deepseek-r1-1.5b.rar),解压后进入解压后的文件夹,并在该文件夹中输入cmd。

安装Deepseek R1 1.5b模型:1.下载并解压模型从百度网盘下载Deepseek R1 1.5b模型的压缩包(deepseek-r1-1.5b.rar),解压后进入解压后的文件夹,并在该文件夹中输入cmd。

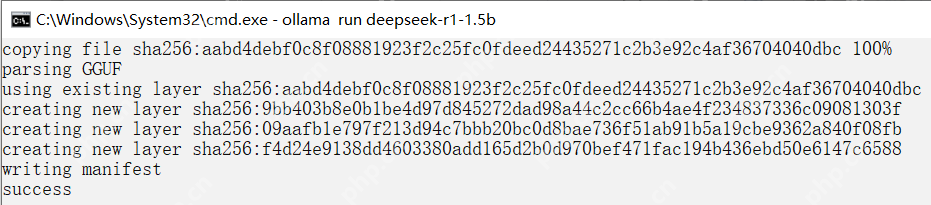

2.通过命令行安装模型在命令行中输入以下命令,Ollama将根据Modelfile中的配置自动安装 deepseek-r1-1.5b.gguf 文件:

2.通过命令行安装模型在命令行中输入以下命令,Ollama将根据Modelfile中的配置自动安装 deepseek-r1-1.5b.gguf 文件:

ollama create deepseek-r1-1.5b -f Modelfile

安装成功后,命令行会显示“success”提示。

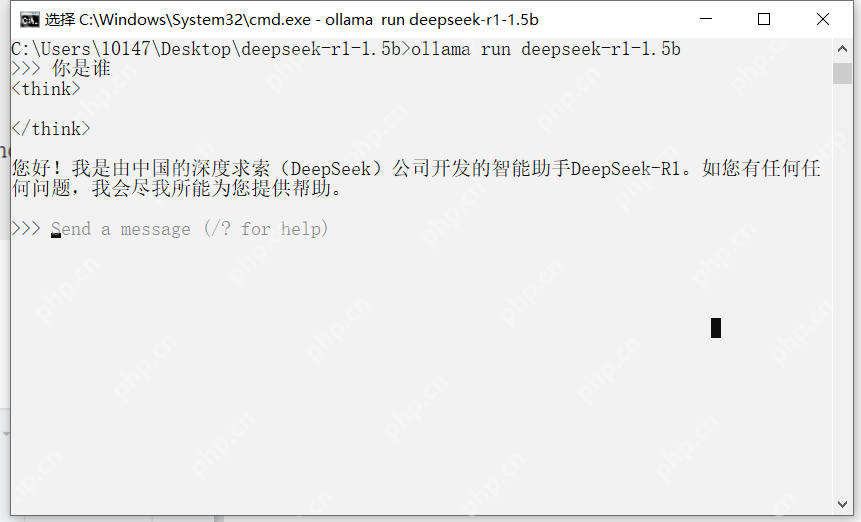

3.运行Deepseek模型安装完成后,输入以下命令即可启动Deepseek模型:

3.运行Deepseek模型安装完成后,输入以下命令即可启动Deepseek模型:

ollama run deepseek-r1-1.5b

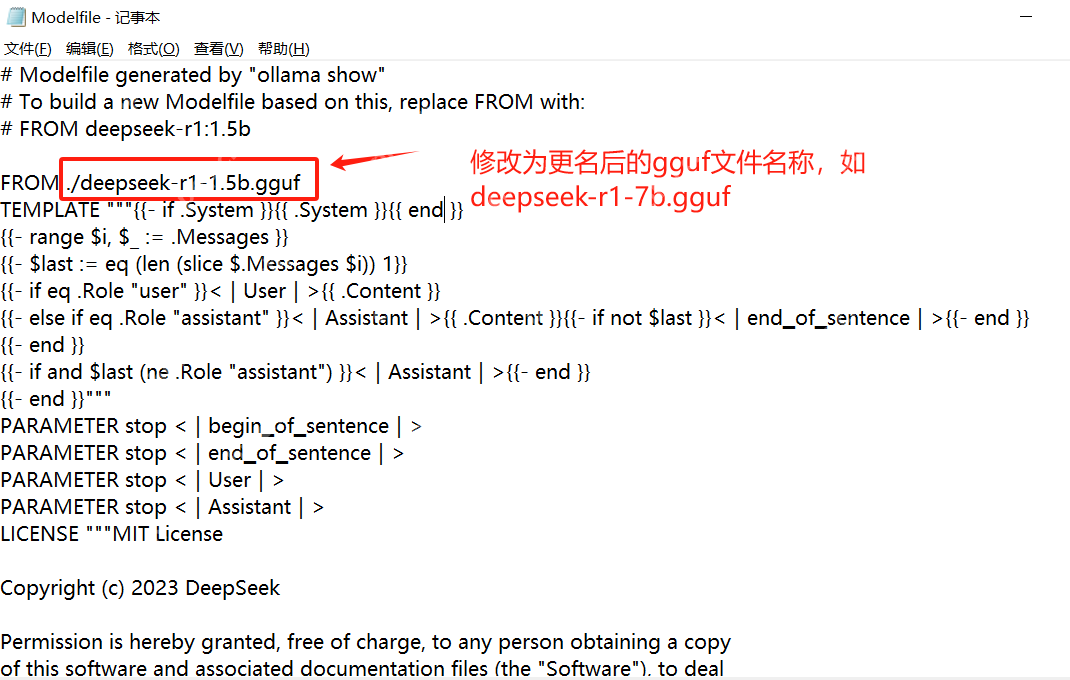

安装其他大小的DeepSeek大模型本文以DeepSeek-r1 1.5b作为示例,如果需要安装其他大小的模型,必须获取该模型的gguf文件。目前DeepSeek在Hugging Face上发布的模型并未直接提供gguf文件,通过量化模型获取gguf文件较为复杂。

安装其他大小的DeepSeek大模型本文以DeepSeek-r1 1.5b作为示例,如果需要安装其他大小的模型,必须获取该模型的gguf文件。目前DeepSeek在Hugging Face上发布的模型并未直接提供gguf文件,通过量化模型获取gguf文件较为复杂。

因此,建议需要安装其他大小DeepSeek模型的用户,在有网络连接的设备上运行Ollama,直接下载相应大小的DeepSeek大模型,例如7B模型。下载后,将模型文件放置于模型文件夹中(C:\Users\你的用户名.ollama\models\blobs),该文件夹内保存的是你下载的模型文件。通过最近的下载时间和文件大小判断出7B模型文件(文件名通常是一个很长的ID),将其重命名为deepseek-r1-7b.gguf。接着修改Modelfile中的FROM字段内容,完成后将文件复制到离线环境中,按照前述步骤进行离线安装即可。