分享一个简便的方法,将 chatglm2-6b 模型快速部署到 huggingface space 在线空间。

01—

在文章《终于部署成功!GPU 云环境搭建 ChatGLM2-6B 坎坷路》中,使用线上云算力资源成功部署了 ChatGLM2-6B 模型,并在最后显示了一行提示:

“This share link expires in 72 hours. For free permanent hosting and GPU upgrades, run gradio deploy from Terminal to deploy to Spaces (https://www.php.cn/link/4b58db5ec33af76c6d9b968cf2c633b1)”

这意味着:“此共享链接将在72小时后过期。为了获得永久的托管和GPU升级,请在终端中运行 gradio deploy 命令,将其部署到 Huggingface 的空间。”

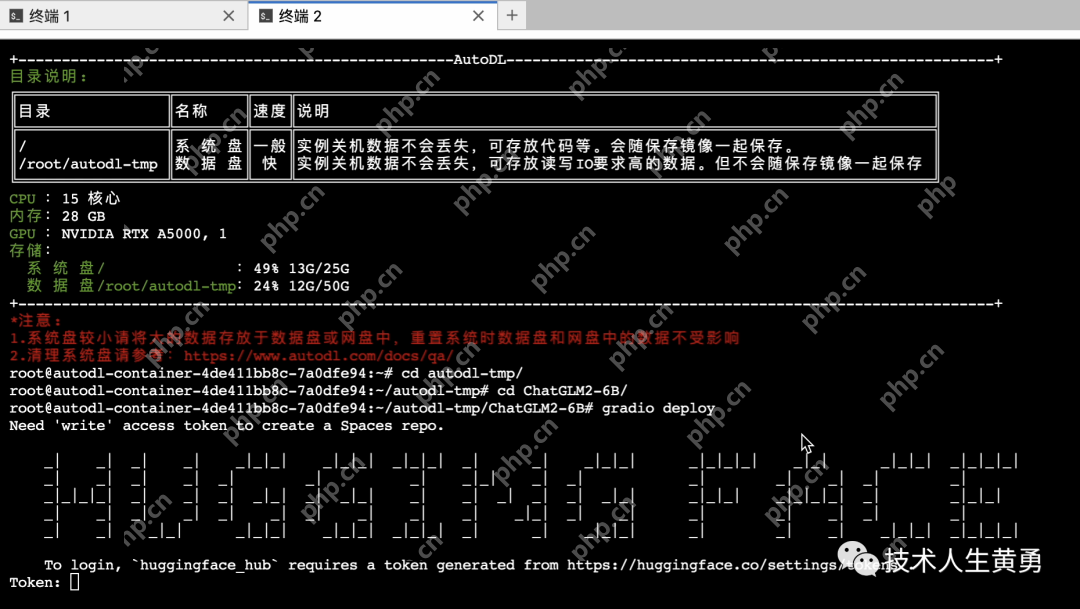

打开命令终端,尝试将模型部署到 Huggingface。

系统提示需要登录到 huggingface_hub 的 token。

系统提示需要登录到 huggingface_hub 的 token。

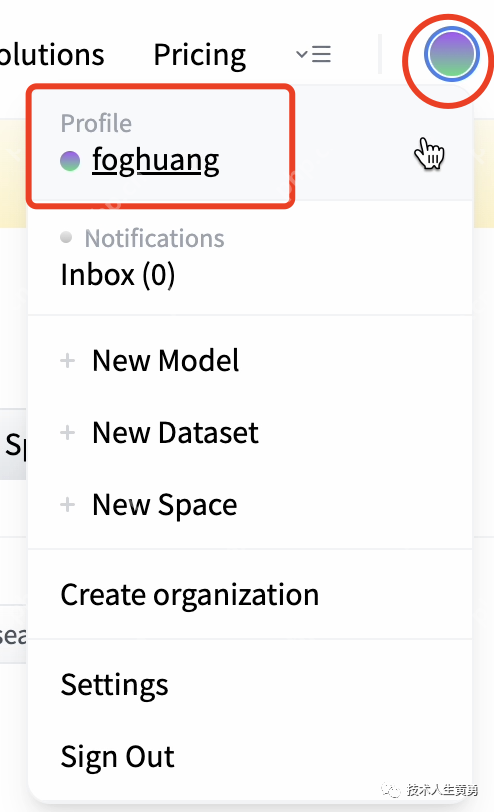

访问 Hugging Face 网站,点击个人账户设置(Profile)。

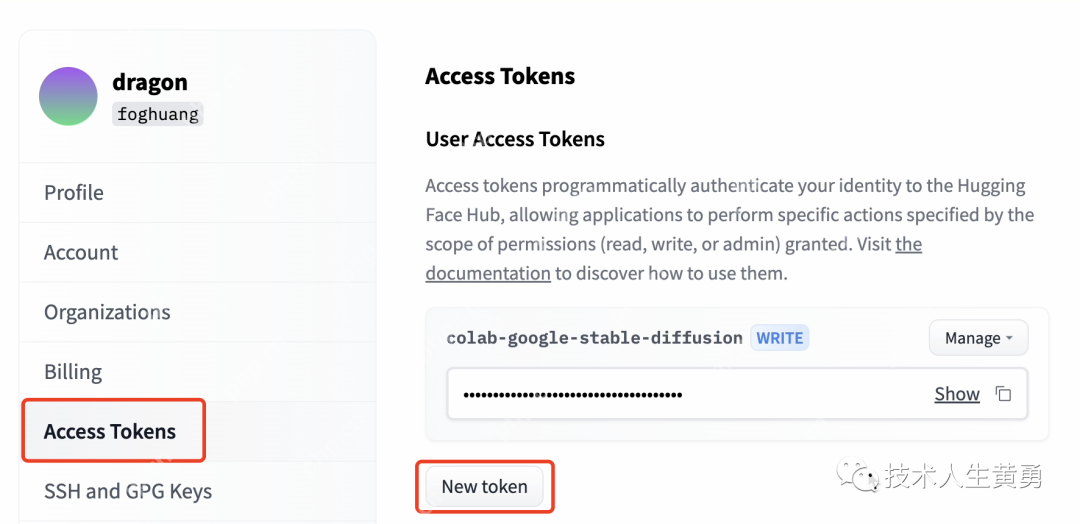

在左侧菜单中找到“Access Tokens”,然后点击“New token”。

在左侧菜单中找到“Access Tokens”,然后点击“New token”。

我的账户已经创建了一个 token,可以参考《没有硬件资源?免费使用Colab搭建你自己的Stable Diffusion在线模型!保姆级教程》,直接复制使用。

我的账户已经创建了一个 token,可以参考《没有硬件资源?免费使用Colab搭建你自己的Stable Diffusion在线模型!保姆级教程》,直接复制使用。

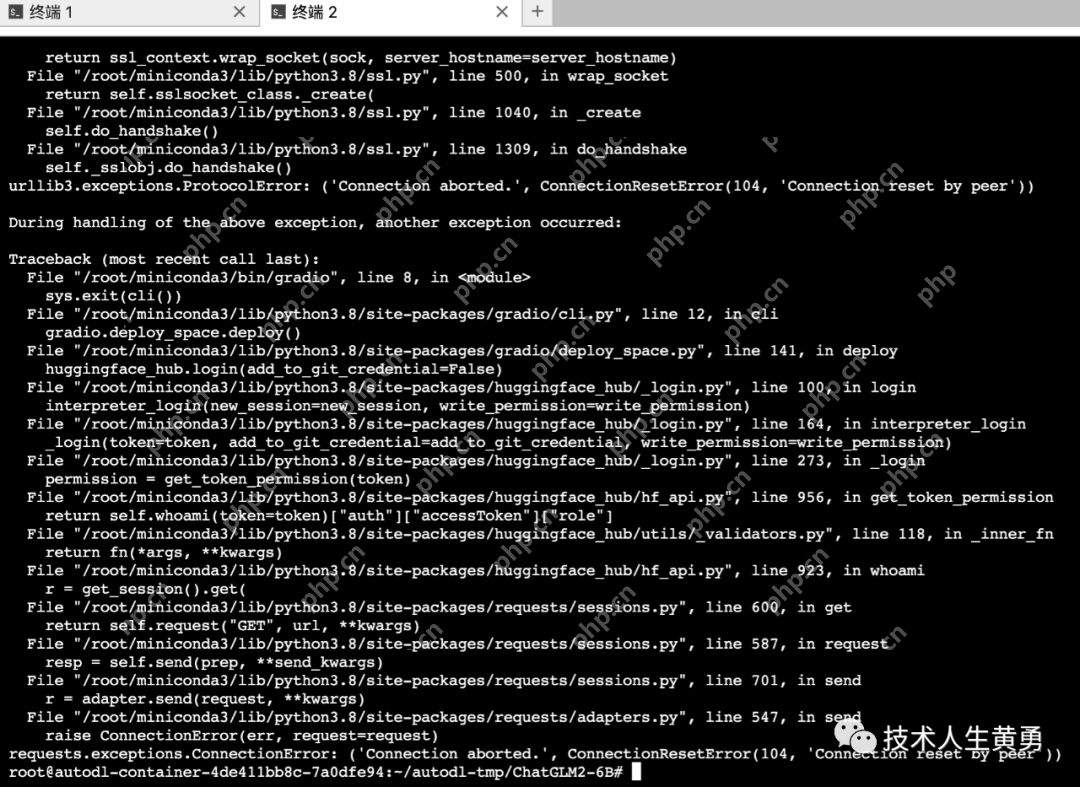

将 token 粘贴到终端窗口,对于询问“Add token as git credential? (Y/n)”,输入“Y”。等待了一段时间后,系统提示:

虽然屏幕上显示了很多信息,但关键的信息只有两个:“Connection aborted.” 和 “Connection reset by peer”。

虽然屏幕上显示了很多信息,但关键的信息只有两个:“Connection aborted.” 和 “Connection reset by peer”。

回想之前部署时,帮助文档中提到了 Huggingface:

估计是无法直接连接了,该怎么办?

估计是无法直接连接了,该怎么办?

02—经过一番思考,我打开了我的PHP中文网账号,咬咬牙,购买了一个月的硅谷云服务器。

通过终端登录,克隆 ChatGLM2-6B 仓库,然后执行 gradio deploy 命令。

通过终端登录,克隆 ChatGLM2-6B 仓库,然后执行 gradio deploy 命令。

出乎意料的是,同样遇到了连接错误。看来即使服务器地址不同,依然执行了相同的网络策略。真是让人沮丧!

虽然部署看起来简单,只需要一行命令,但因为网络连接问题,进展陷入了僵局。

询问 ChatGLM,看看是否有好的解决方案。

ChatGLM2-6B 的建议似乎很合理,国产之光,ChatGPT 国内的替代品名副其实。有兴趣的朋友可以查看 ChatGLM2-6B 的初体验。

ChatGLM2-6B 的建议似乎很合理,国产之光,ChatGPT 国内的替代品名副其实。有兴趣的朋友可以查看 ChatGLM2-6B 的初体验。

最后想到,既然是执行发布命令,连接到 Huggingface Space 空间进行操作,那么将仓库克隆到本地电脑(有代理),再执行发布命令,是不是可行?

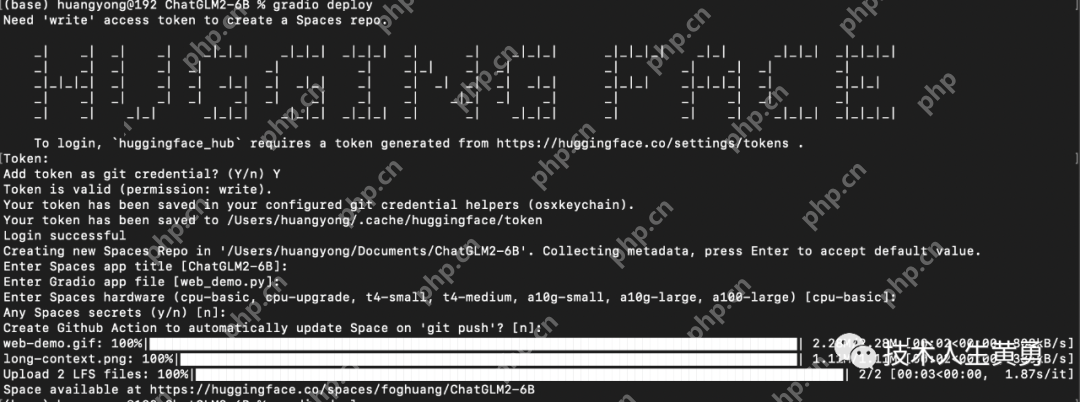

这个方案成功了,命令行下执行完 git 克隆命令,输入 token 后,顺利进入下一步。部署命令 “gradio deploy” 将在 Huggingface 上创建你的仓库空间:

这个方案成功了,命令行下执行完 git 克隆命令,输入 token 后,顺利进入下一步。部署命令 “gradio deploy” 将在 Huggingface 上创建你的仓库空间:

Creating new Spaces Repo in '/Users/huangyong/Documents/ChatGLM2-6B'

请记住,在回答后续问题时,除了硬件配置以外,其他都可以回车采用默认值。

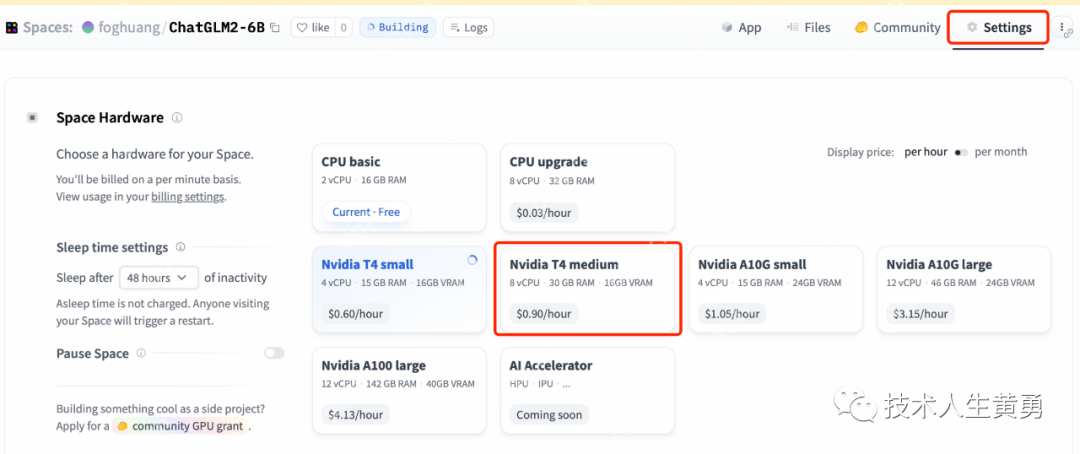

Enter Spaces hardware (cpu-basic, cpu-upgrade, t4-small, t4-medium, a10g-small, a10g-large, a100-large) [cpu-basic]:

这里需要输入:t4-medium,才能让 ChatGLM2-6B 运行起来。

(查看 ChatGLM-6B 官方文档,有量化模型的设置,猜测可以让更少的硬件也能运行起来,但我没有仔细研究。)

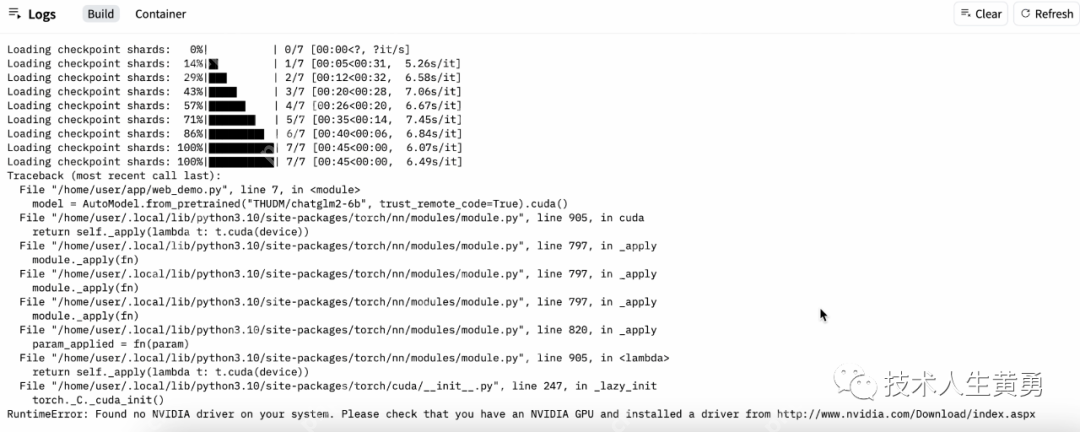

第一次运行时,我按了回车,选择了默认的 cpu-basic 硬件配置,结果模型无法运行。

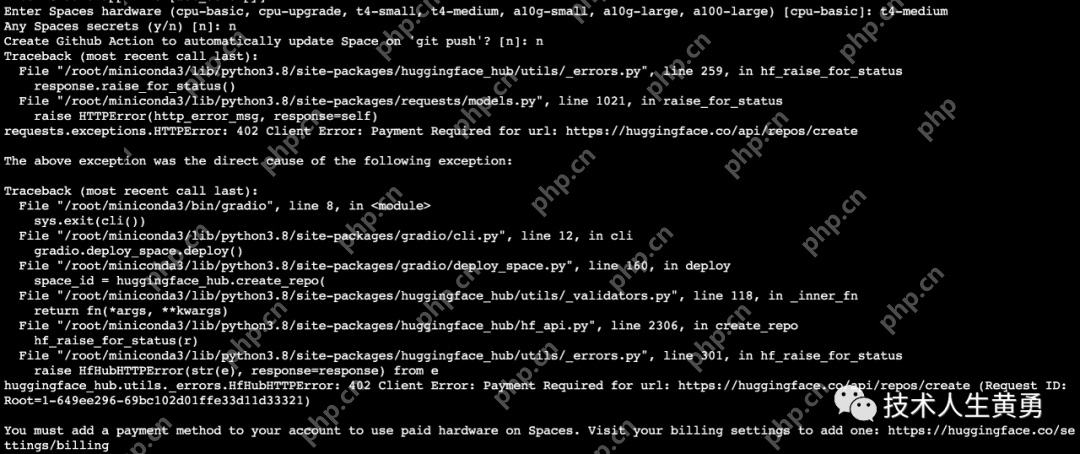

如果直接输入:t4-medium,系统会提示需要添加一个支付方式:You must add a payment method to your account。

当时我没有关注这条提示信息,直接使用基本配置 cpu-basic 进行部署,结果失败了。

当时我没有关注这条提示信息,直接使用基本配置 cpu-basic 进行部署,结果失败了。

RuntimeError:Found no NVIDIA driver。

RuntimeError:Found no NVIDIA driver。

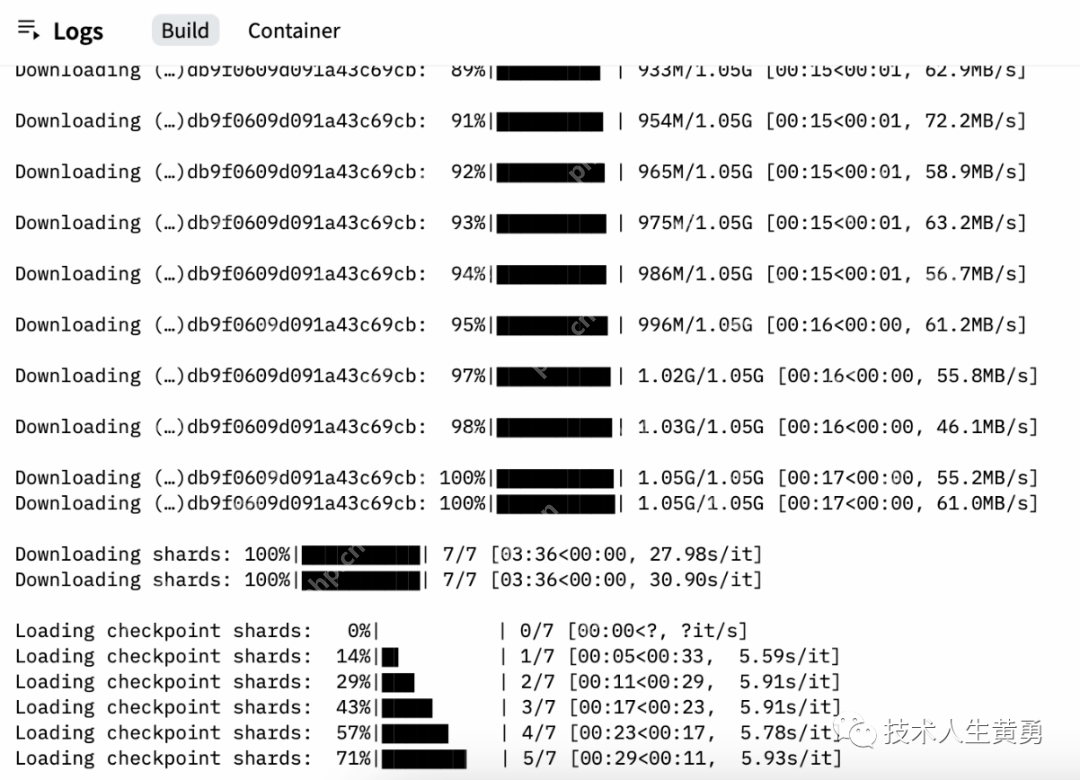

如果硬件配置选择 t4-small,会卡在第5个 Checkpoint。

没有任何错误提示,也卡在这里让我郁闷了很久。最后猜测是不是硬件资源中内存不够,将空间升级到 medium 后,就能顺利运行了。

没有任何错误提示,也卡在这里让我郁闷了很久。最后猜测是不是硬件资源中内存不够,将空间升级到 medium 后,就能顺利运行了。

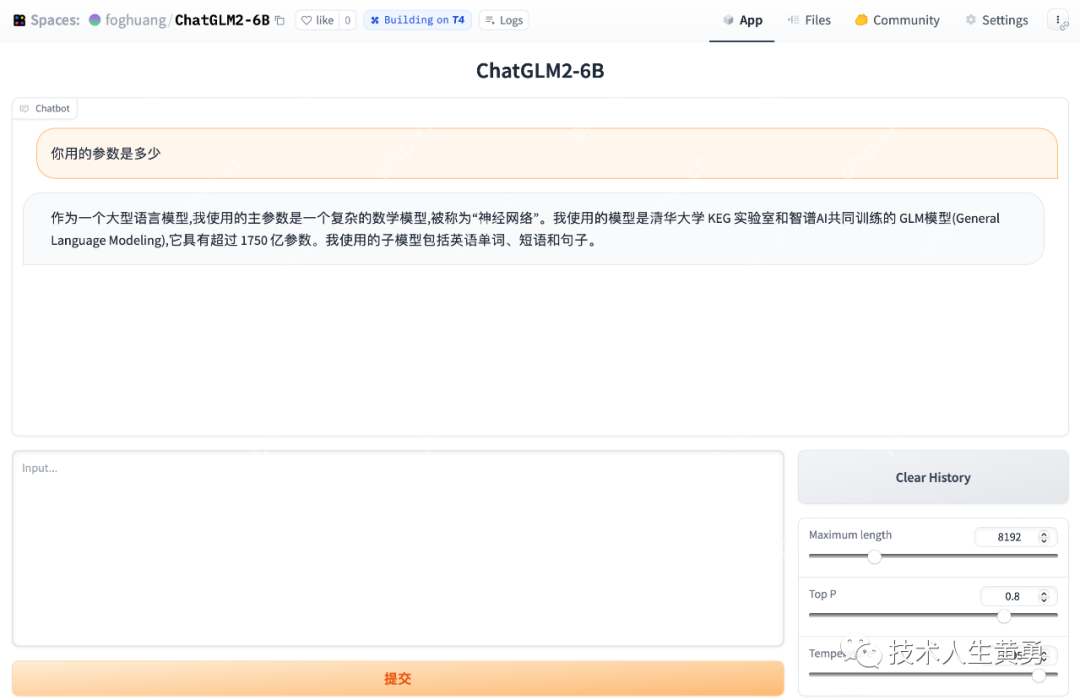

启动后,点击右上角的:“App”。

启动后,点击右上角的:“App”。

Huggingface Space 提供一个永久的空间地址供访问:

Huggingface Space 提供一个永久的空间地址供访问:

https://www.php.cn/link/4b58db5ec33af76c6d9b968cf2c633b1/foghuang/ChatGLM2-6B。

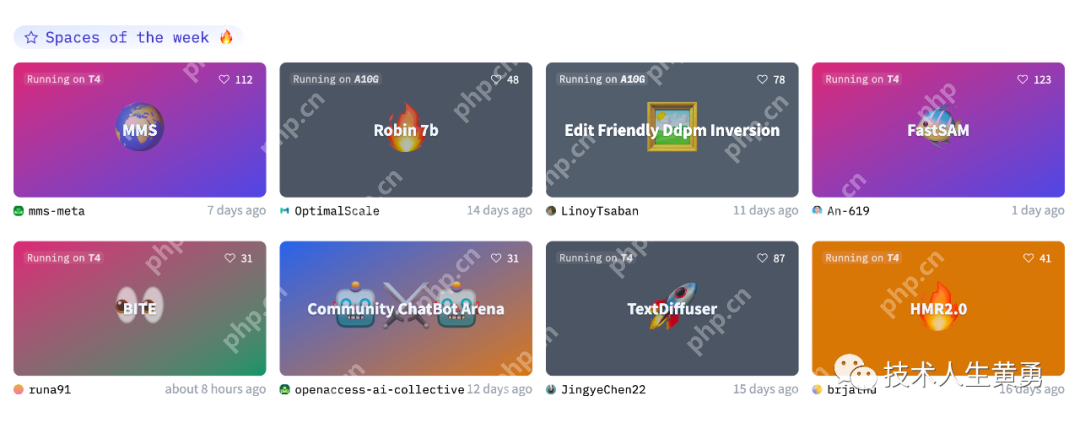

在 Space 上还有很多有趣的,使用人工智能模型的应用,大家有兴趣可以点开试用。像下面的第一个就是文本和语音互转的应用。

https://www.php.cn/link/4b58db5ec33af76c6d9b968cf2c633b1

03—Huggingface Space 部署总结:

03—Huggingface Space 部署总结:

注册 Huggingface 账号;添加 token;添加支付方式,国内借记卡和信用卡均可;确保能访问 Huggingface 的环境;默认情况下,硬件最小配置选择: t4-medium;启动成功后,点击 space 的 App,可以看到运行界面;Huggingface 提供永久地址,可以让应用被外部用户访问。

以上就是快捷部署清华大模型 ChatGLM2-6B,一键搞定 HuggingFace Space 空间的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号