本文介绍如何用飞桨PARL强化学习框架在微软AirSim仿真环境实现智能驾驶。先说明环境配置,包括安装Win10、VS2019、虚幻引擎、AirSim等及验证方法;再讲用Python控制汽车的步骤;最后详述基于飞桨PARL的DQN算法实现,含代码清单、逻辑,还提及相关训练地图和视频。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

https://www.bilibili.com/video/BV1UY4y1e7s5?share_source=copy_web

训练过程视频:PARL_AirSim_DQN.mp4

PARL 是由百度大脑出品的、高性能、易用的国产强化学习(RL)框架。

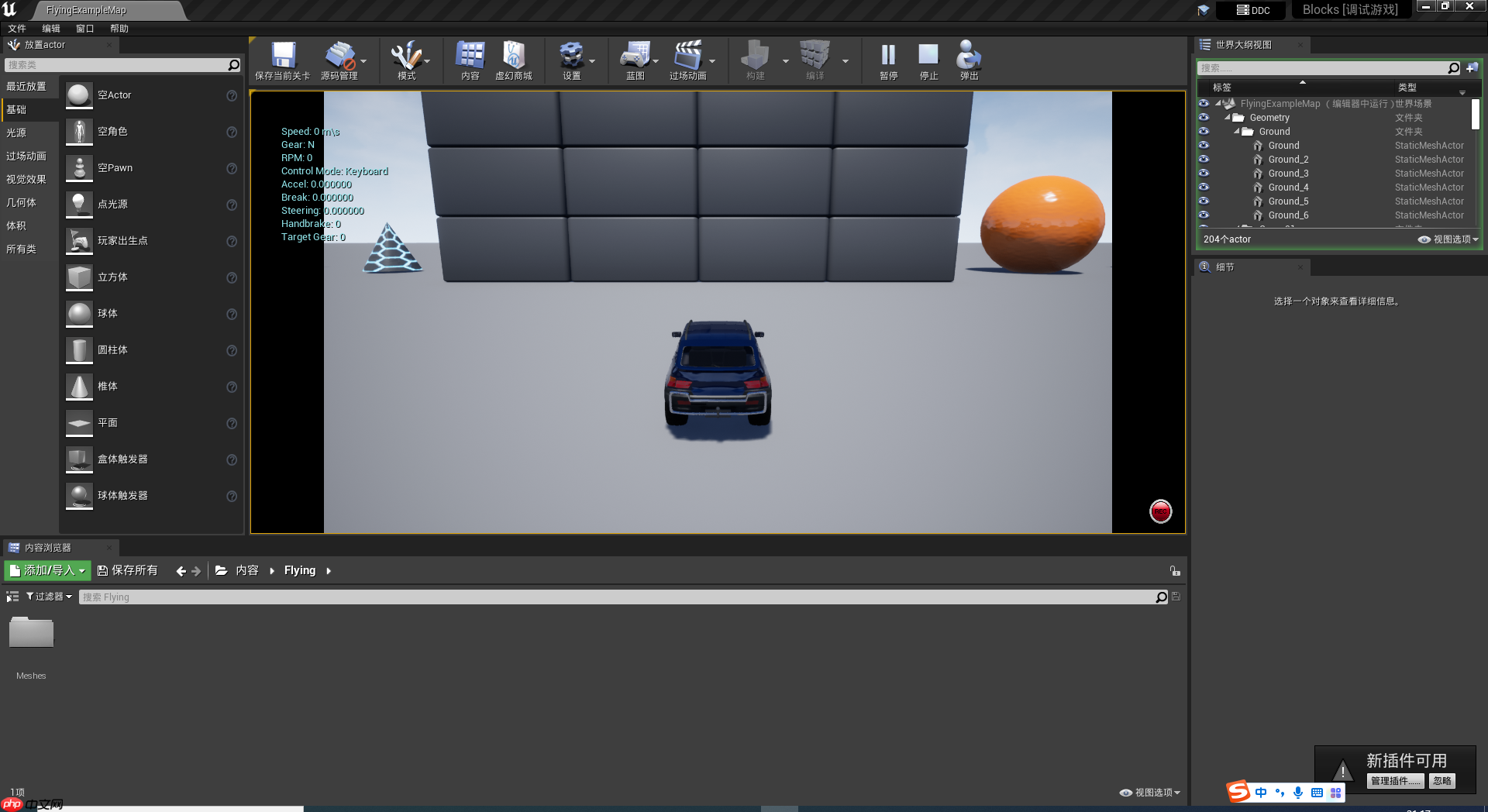

微软AirSim环境是基于Unreal游戏引擎开发的,面向四轴无人机和无人驾驶汽车的虚拟现实环境。

AirSim目前star数高达12.9k,是微软公司最火的人工智能项目之一。

百度PARL的RL程序目前还无法在AirSim环境中运行。

本文实现了AirSim环境中运行基于PARL的强化学习算法。

注册账号

下载软件

下载Visual Studio Community 2019

下载Epic Game Launcher并安装4.26以上版本的“虚幻引擎”

重启Epic Game Launcher并关联项目文件

下载AirSim源代码:git clone https://github.com/Microsoft/AirSim.git

本地编译AirSim源代码(Windows环境)

验证安装

略

# 安装Unreal和python之间的通讯协议

pip install msgpack-rpc-python # 安装airsim的python库

pip install airsim请参考: 《下载与安装示例》章节,不再赘述。

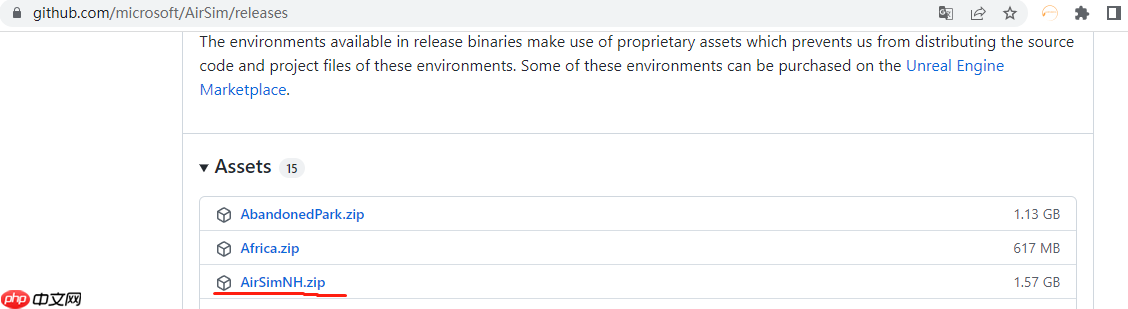

下载AirSim预编译的windows版本的训练地图:

AirSim_Paddle

│ setup_path.py│

│ agent.py│ model.py│ replay_memory.py│ train.py│

└─airgym

│ __init__.py

│

└─envs

airsim_env.py

car_env.py

drone_env.py

__init__.pyairsim_env.py 基础环境配置

car_env.py 汽车训练环境配置

`__init__.py` python包配置

...

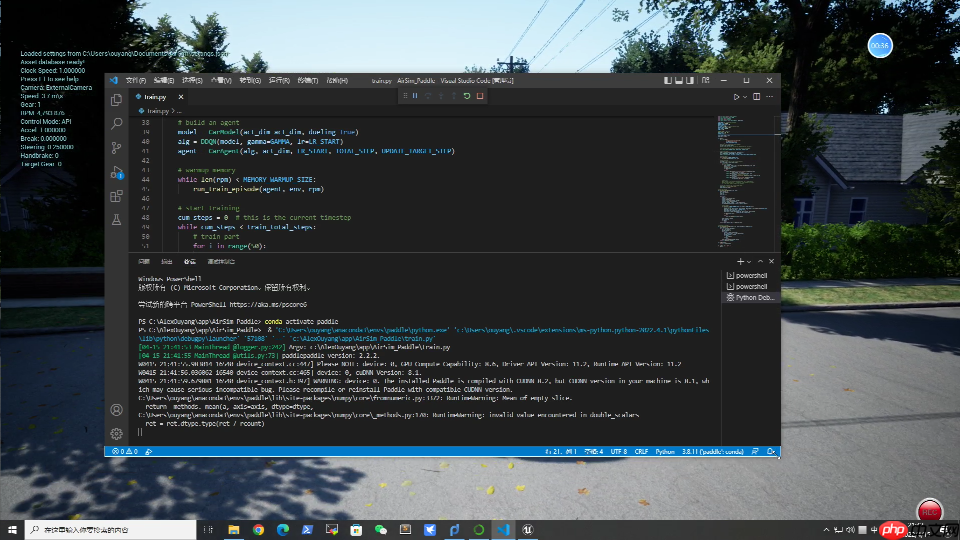

while True:

step += 1

# 获取记忆回放中的4帧

context = rpm.recent_obs() # 把当前动作返回帧加进去

context.append(obs) # 数组增加一维

context = np.stack(context, axis=0) # 选择一个动作,e-greedy算法

action = agent.sample(context) # 触发动作

next_obs, reward, isOver, _ = env.step(action) # 回写记忆回放

rpm.append(Experience(obs, action, reward, isOver)) # train model

if (len(rpm) > MEMORY_WARMUP_SIZE) and (step % LEARN_FREQ == 0): # s,a,r,s',done

(batch_all_obs, batch_action, batch_reward, batch_done) = rpm.sample_batch(BATCH_SIZE) # 抽帧

batch_obs = batch_all_obs[:, :CONTEXT_LEN, :, :] batch_next_obs = batch_all_obs[:, 1:, :, :] # 把抽出的帧放入learn方法中学习

train_loss = agent.learn(batch_obs, batch_action, batch_reward, batch_next_obs, batch_done) loss_lst.append(float(train_loss))

print("loss" + str(train_loss))

total_reward += reward

obs = next_obs

if isOver: break return total_reward, step, np.mean(loss_lst)训练视频:PARL_AirSim_DQN.mp4 完整源代码在work目录

本项目在AirSim仿真环境中首次集成了飞桨PARL强化学习框架。

使用了飞桨PARL库自带的DQN系列算法,验证了AirSim环境中使用飞桨框架的可行性。

以上就是老司机开车了!用飞桨玩AirSim智能驾驶的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号