本文测试了EasyEdge对PaddleX2.0动态图训练模型的支持情况。先介绍相关项目与社区答疑方式,确认支持后,进行动态图转静态图(模型导出),再配置EasyEdge,上传模型文件并查看适配设备,最后生成安卓APP验证效果,实现端云协同部署,还提及该平台可明确模型适用设备及评测部署效果。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

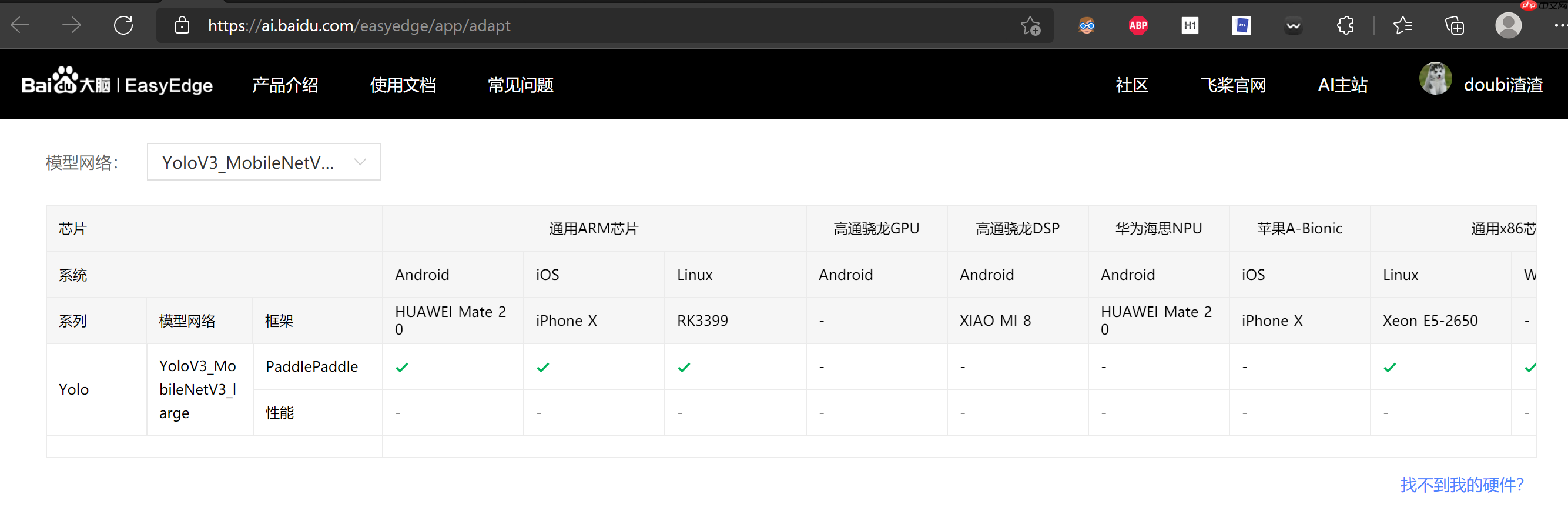

那么,使用PaddleX 2.0动态图训练的模型,还能支持在哪些终端部署?手机上?Jetson(TX2/Nano/Xavier)?是否有这么一个平台,能确凿地告诉我们,当前我们训练的模型,哪个设备上能用,最好还能评测下,部署上去效果如何?

很显然,这样一个“万能”平台是存在的,它就是……曾经介绍过的EasyEdge端与边缘AI服务平台

不过,我们似乎还没验证过EasyEdge对Paddle2.0训练模型的支持情况,现在,不妨来测试一番。顺便,这里也介绍下一些少走弯路的FAQ方式。

关于强大的EasyEdge,首先不妨看看平台上是否有相关介绍,很巧,当初有部分介绍还是本人写的233333

在上面的项目中,我们可以利用EasyEdge实现零代码生成一个目标检测安卓手机APP或是Windows客户端。不过仔细看可以发现,这些项目都是基于Paddle1.8的:

模型文件和我们训练出来的长得不一样啊……主要就是框架版本问题

模型文件和我们训练出来的长得不一样啊……主要就是框架版本问题

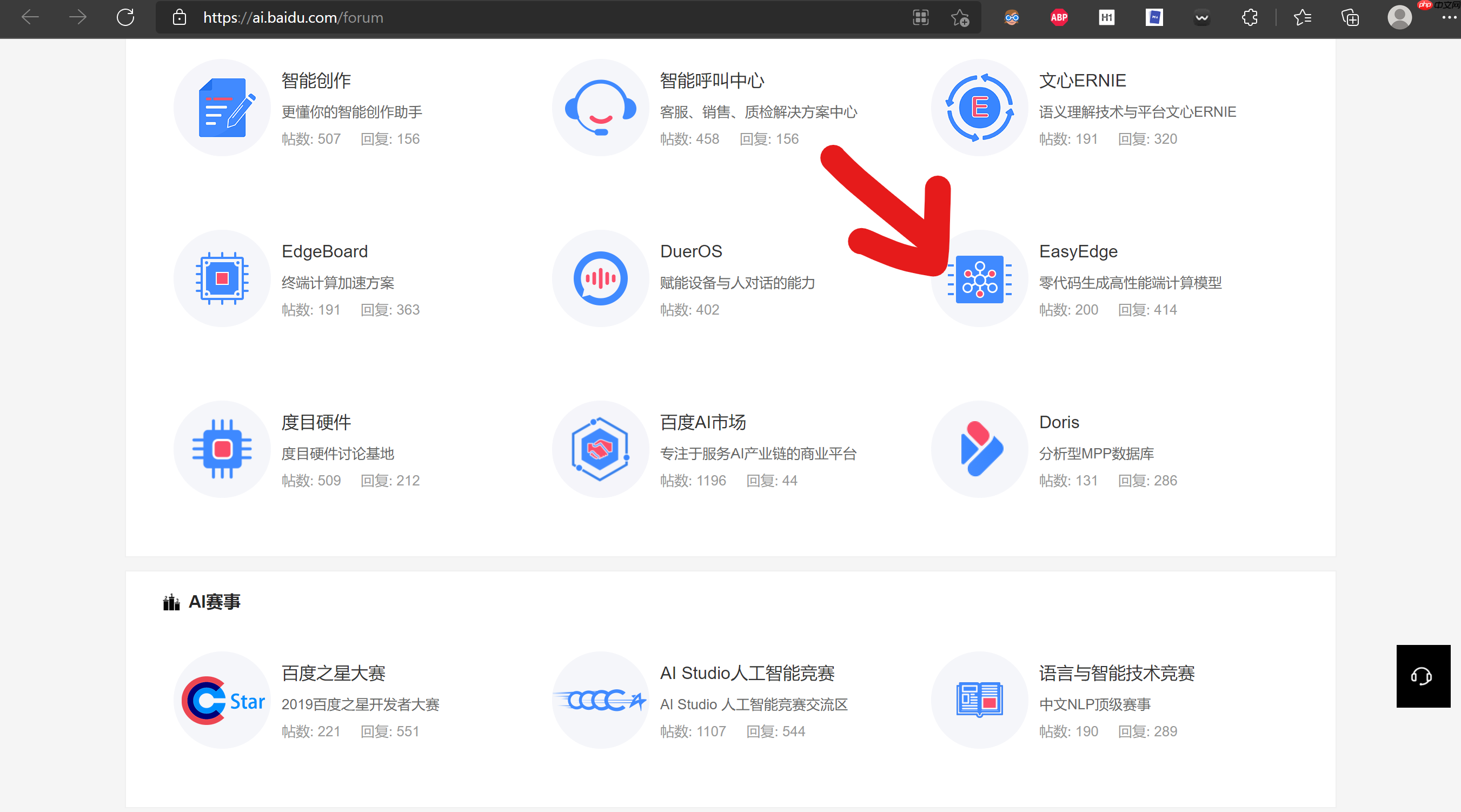

其实,除了我们最常用的QQ群,但凡涉及到需要官方支持的问题,去社区问是个不错的方式,一般,官方支持会在1-2个工作日内回帖,比自己瞎折腾要快多了。——尽管QQ群上理论上可以得到及时回复,但需要比较理想的条件,比如,刚好支持这个方面的大佬在线、其他人遇到过类似问题等等…… 这里多提供一种方式,读者可以根据自己的习惯自行选择。

进入百度AI社区,找到要问问题的板块: 然后发帖咨询

然后发帖咨询 得到了肯定的答复,这时候,可以放心地开始测试PaddleX2.0模型的EasyEdge部署了。

得到了肯定的答复,这时候,可以放心地开始测试PaddleX2.0模型的EasyEdge部署了。

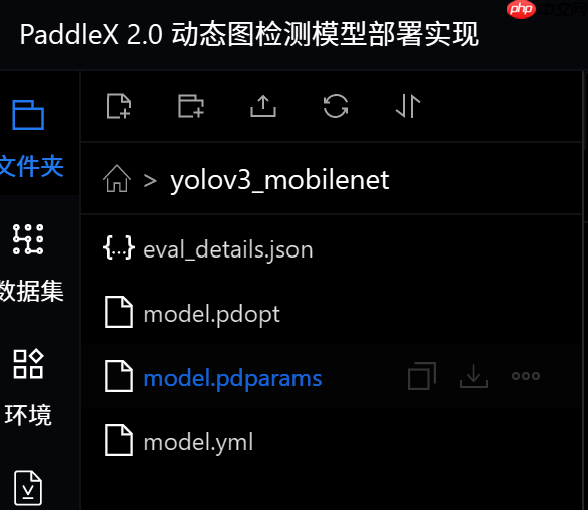

对于PaddleX训练的模型而言,动态图转静态图就是我们前面说过的模型导出

在PaddleX 1.X版本中,是这样解释模型导出的:

注:所有涉及到模型部署,均需要参考本文档,进行部署模型导出

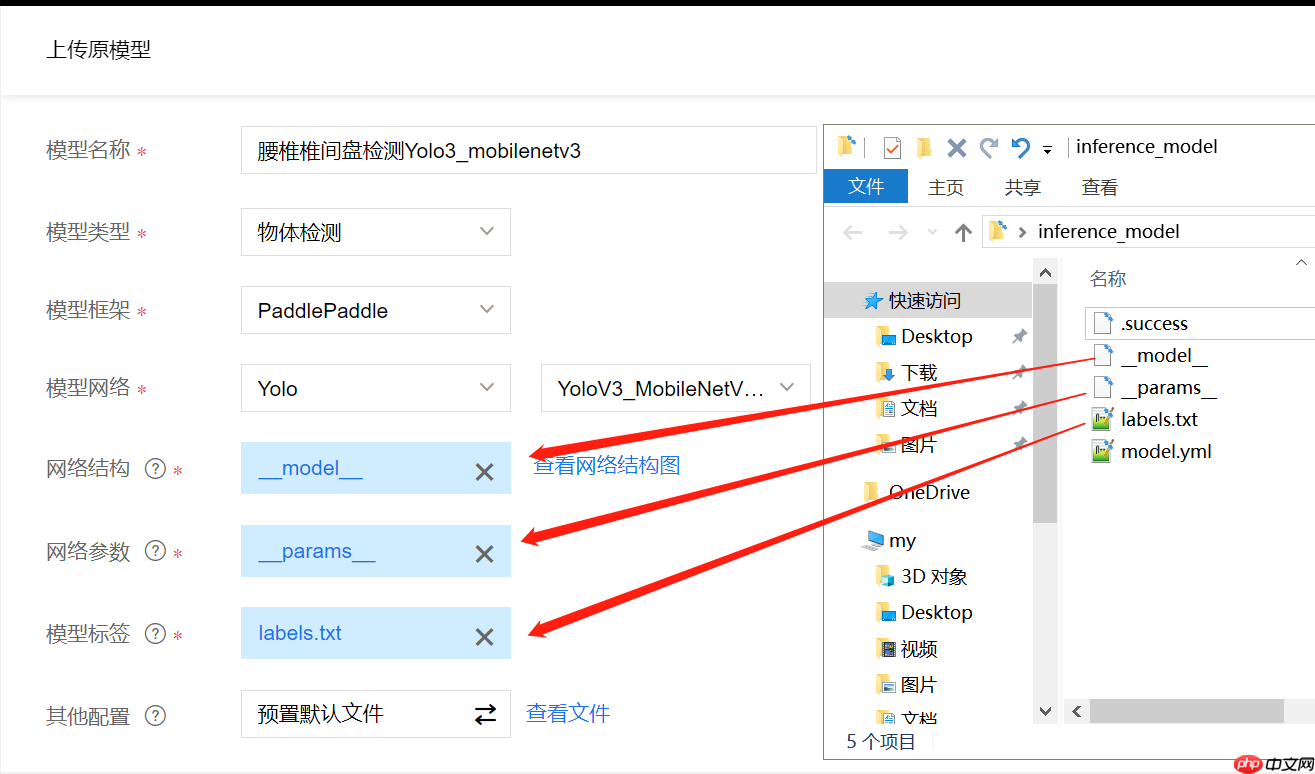

在服务端部署模型时需要将训练过程中保存的模型导出为inference格式模型,导出的inference格式模型包括__model__、__params__和model.yml三个文件,分别表示模型的网络结构、模型权重和模型的配置文件(包括数据预处理参数等)。

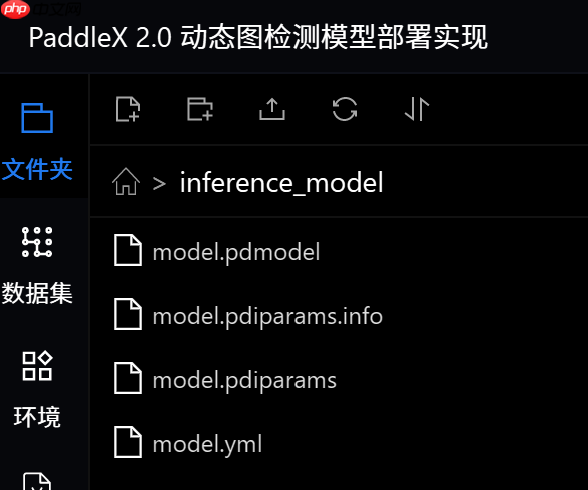

但是,其实我们在PaddleX 2.0 动态图检测模型部署实现中已经知道,导出结果是这样的:

虽然看起来有一定差异,但是我们可以发现,Paddle框架版本升级后,__model__对应model.pdmodel,__params__对应model.pdiparams。

为便于读者使用,前置项目的安全帽检测模型导出结果已放在inference_model目录下。

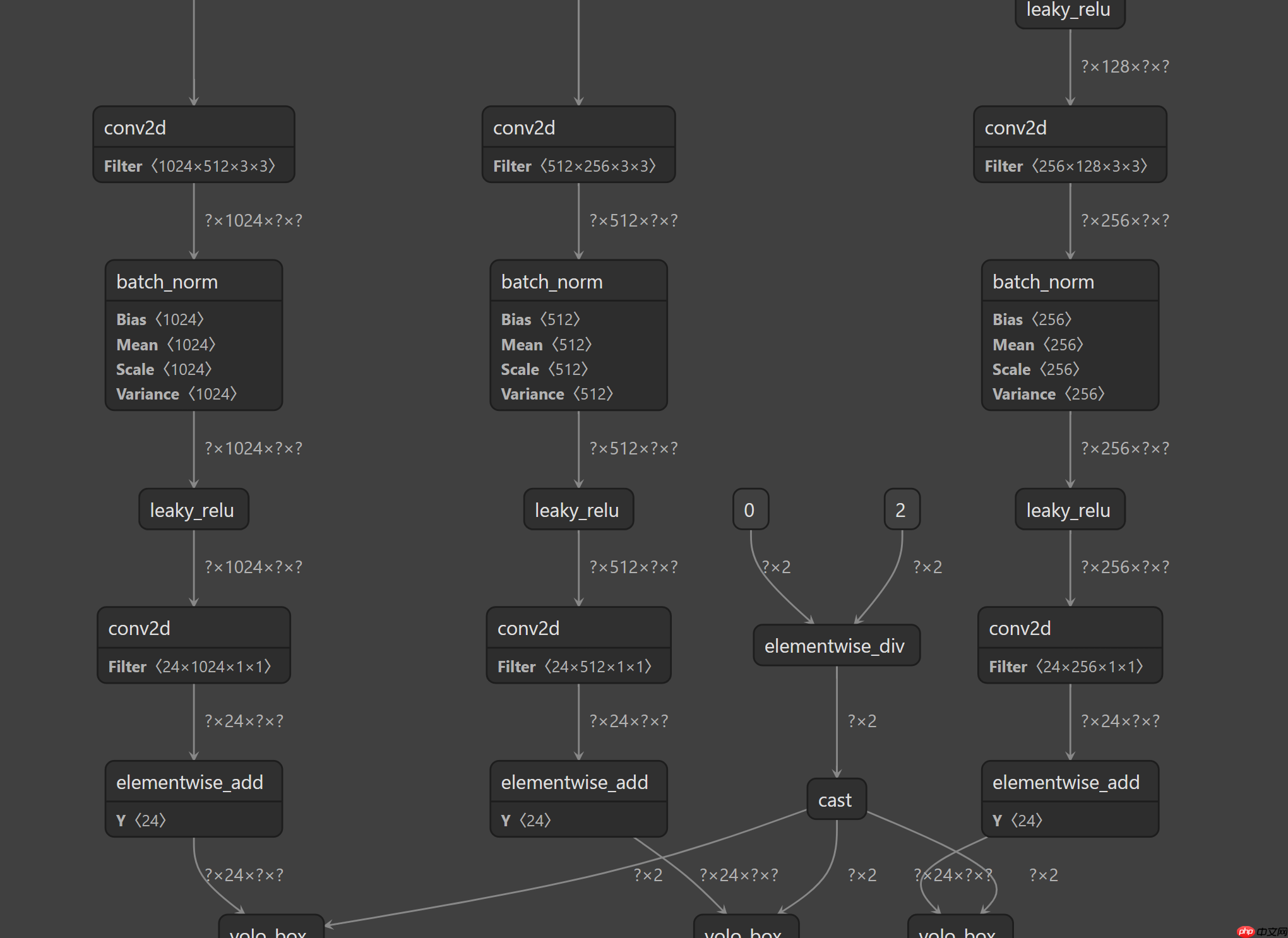

上传网络结构文件后EasyEdge会自动校验,如果能正常查看网络结构图,那模型大概率就没有问题了,所以,其实是不是__model__、__params__其实不重要,这里可能是因为迭代的原因,EasyEdge在提示方面并没有说清楚。换句话说,其实Paddle2.0动态图的模型导出后,EasyEdge是支持部署的!

上传网络结构文件后EasyEdge会自动校验,如果能正常查看网络结构图,那模型大概率就没有问题了,所以,其实是不是__model__、__params__其实不重要,这里可能是因为迭代的原因,EasyEdge在提示方面并没有说清楚。换句话说,其实Paddle2.0动态图的模型导出后,EasyEdge是支持部署的!

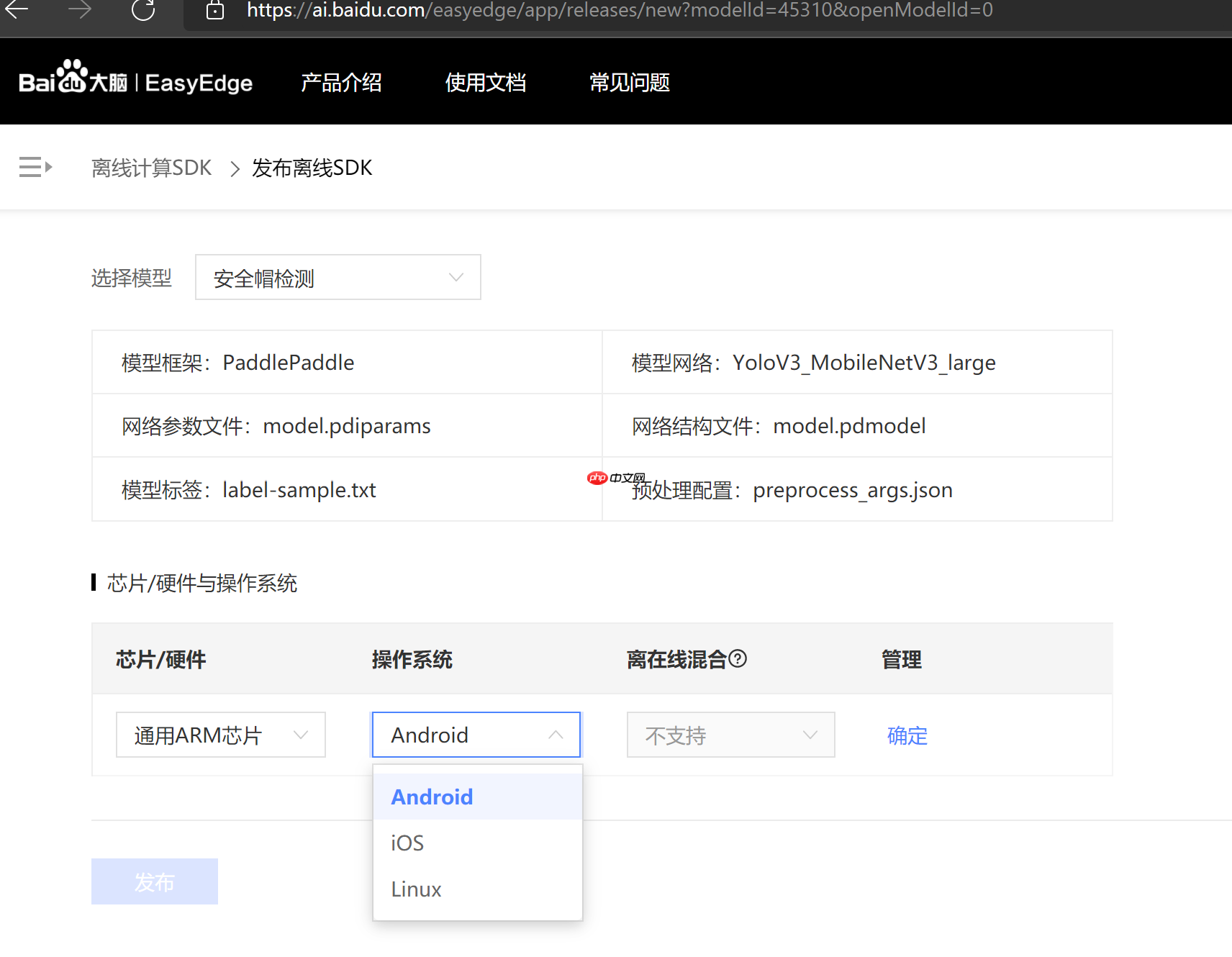

这里选择生成一个安卓手机的APP,因为笔者手上刚好有这个设备可以验证效果

这种部署方式是不是简单又实用,探索起来吧

这种部署方式是不是简单又实用,探索起来吧

以上就是EasyEdge:PaddleX 2.0动态图检测模型的部署的详细内容,更多请关注php中文网其它相关文章!

Edge浏览器是由Microsoft(微软中国)官方推出的全新一代手机浏览器。Edge浏览器内置强大的搜索引擎,一站搜索全网,搜文字、搜图片,快速识别,帮您找到想要的内容。有需要的小伙伴快来保存下载体验吧!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号